热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

Kangwook Lee

威斯康星大学麦迪逊分校 / 克拉夫顿 AI

作为评判者的LLM已成为评估模型解决任务能力的主要方式,因为它不依赖于测试集,并且能够处理答案不唯一的情况。

但尽管这种方法被广泛使用,几乎所有报告的结果都存在高度偏见。

很高兴分享我们关于如何正确使用LLM作为评判者的预印本。

🧵

===

那么人们实际上是如何使用LLM作为评判者的呢?

大多数人只是将LLM用作评估者,并报告LLM认为答案看起来正确的经验概率。

当LLM完美时,这种方法很好,并且提供了一个无偏估计。

如果LLM不完美,这种方法就会失效。

考虑一个案例,其中LLM正确评估的概率为80%。

更具体地说,如果答案是正确的,LLM以80%的概率说“这看起来正确”,而当答案实际上是错误的时,LLM同样以80%的概率说“这看起来正确”。

在这种情况下,你不应该报告经验概率,因为它是有偏的。为什么?

设被测试模型正确的真实概率为p。

那么LLM说“正确”的经验概率(= q)为:

q = 0.8p + 0.2(1 - p) = 0.2 + 0.6p

因此,无偏估计应该是:

(q - 0.2) / 0.6

如果错误模式不对称,或者你事先不知道这些错误率,情况会变得更加有趣。

===

那么这意味着什么?

首先,遵循我们预印本中建议的指导方针。

没有免费的午餐。除非你的LLM作为评判者被证明在评判上是完美的,否则你无法评估你的模型有多好。

根据它与完美评估者的接近程度,你需要足够大小的测试集(= 校准集)来估计评估者的错误率,然后你必须对此进行修正。

其次,非常不幸的是,我们在过去几年中看到的许多研究结果需要重新审视。

除非两篇论文使用了完全相同的LLM作为评判者,否则在它们之间比较结果可能会产生虚假的声明。改进可能仅仅来自于稍微改变评估流程。迫切需要进行严格的元研究。

===

tldr:

(1) 在过去几年中,几乎所有LLM作为评判者的评估都是以有偏估计报告的。

(2) 这很容易修正,所以请等待我们的完整预印本。

(3) 许多LLM作为评判者的结果应谨慎对待。

完整的预印本将在几天内发布,请保持关注!

我的学生和合作者们做了惊人的工作。

@chungpa_lee @tomzeng200 @jongwonjeong123 和 @jysohn1108

203.8K

关于DeepSeek-OCR炒作/严重误解的更严肃的讨论。

1.

关于通过将文本表示为图像来减少令牌,剑桥的研究人员之前已经证明,500倍的提示令牌压缩是可能的(ACL'25,Li,Su和Collier)。

而不使用将文本转换为图像的想法。

2.

我们不应该将DeepSeek OCR的成功归因于图像表示的力量。

同时,使用任何分词器进行文本表示并没有根本上的错误。

事实上,你可以做与DeepSeek-OCR相反的事情,即你可以将图像表示为一系列文本令牌(每个代表其RGB值),一切都会正常工作。(参见LIFT论文。)

3.

唯一正确的结论是,当前LLMs使用的嵌入空间是巨大的,甚至可能非常浪费。

而且重要的是,我们还没有充分利用它们。

4.

最近有很多证据支持同样的信息。

例如,有证据表明,如果你在单一上下文中提供来自多个任务的上下文演示,那么你的模型可以同时解决多个ICL预测任务。(参见EVERYTHING EVERYWHERE ALL AT ONCE论文。)

5.

tldr;

- DeepSeek-OCR很酷

- 但你可以通过对压缩文本令牌进行微调LLMs来实现更高的令牌减少率

- 有更多证据表明LLMs没有充分利用大嵌入空间以及在推理时投入的大量计算

- 这才是你应该真正记住的唯一结论

85.96K

DLLMs 看起来很有前景……但并行生成并不总是可能的

基于扩散的 LLM 可以同时在不同位置生成多个标记,而大多数自回归 LLM 是一个一个地生成标记。

这使得基于扩散的 LLM 在我们需要快速生成且计算量较少时非常有吸引力。

一个大问题是……在不失去建模准确性的情况下,是否可以进行并行生成?

答案是否定的。我们可以实现的并行性有基本的限制。

考虑这个例子:

“从以下四个城市中均匀随机选择一个城市:

纽约、新奥尔良、墨西哥城或巴拿马城。”

然后,

P(Y₁ = New, Y₂ = York) = 1/4,

P(Y₁ = New, Y₂ = Orleans) = 1/4,等等。

因此,P(Y₁ = New) = 1/2,P(Y₂ = City) = 1/2。

如果你选择并行生成 Y₁ 和 Y₂,无论你使用什么解码算法……

你注定会抽样出“New City”。

今天的 DLLMs 没有一个可以在不放弃并行性的情况下正确生成这两个词。

-----

为什么会这样?

事实上,我们从未训练 LLM 学习在一次前向迭代中多个标记的联合分布。

我们总是教一个基于上下文的单标记边际分布。

(自回归模型也是如此。)

因此,只有在这些标记在当前上下文下是相互独立的情况下,才能同时抽样多个标记。

而这种并行抽样的限制可以被精确地形式化。

可以推导出一个与解码策略无关的信息论极限,也可以推导出特定策略的极限。

-----

那么 DLLMs 注定要失败吗?不!

它们在节省计算和时间方面具有巨大的潜力。

但是:

(1)我们需要意识到它们的基本限制,

(2)我们需要设计更好的训练和解码策略。

特别是在解码方面,有很大的改进空间。

为什么?

理想情况下,我们希望模型在生成过程中控制并行性的程度。

同时,它应该选择在当前上下文下几乎相互独立的未来标记的子集。

当前的解码策略在这方面表现如何?

很难说。

大多数 DLLMs 从未经过压力测试。

-----

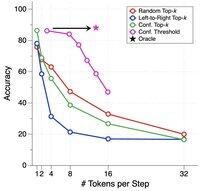

这就是为什么我们引入了一个合成基准来对 DLLMs 进行压力测试。

我们称之为 ParallelBench。

这个想法很简单:这些是自然语言任务,但经过精心设计,使得并行生成本质上很困难。

(想想“New City”,但更自然,更真实的任务。)

我们发现了什么?

我们测试了流行的 DLLMs 和各种解码算法,没有一个接近“oracle”性能,即如果模型能够在解码过程中最佳调整其并行性时所能获得的理想性能。

-----

要点:

(1)并行生成并不总是可能,更多细节请查看我们的论文 :)

(2)如果你能设计一个在我们的基准上匹配 oracle 性能的 DLLM,嗯,谁知道呢,你可能会接到来自门洛帕克某人的电话。😉

63.7K

热门

排行

收藏