Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kangwook Lee

UW Madison / KRAFTON AI

O LLM como juiz tornou-se uma forma dominante de avaliar a qualidade de um modelo para resolver uma tarefa, já que funciona sem um conjunto de testes e lida com casos em que as respostas não são únicas.

Mas, apesar de essa ampla utilização, quase todos os resultados relatados são altamente tendenciosos.

Animado para compartilhar nosso preprint sobre como usar corretamente o LLM como juiz.

🧵

===

Então, como as pessoas realmente usam o LLM como juiz?

A maioria das pessoas apenas usa o LLM como avaliador e relata a probabilidade empírica de que o LLM diga que a resposta parece correta.

Quando o LLM está perfeito, isso funciona bem e fornece um estimador imparcial.

Se o LLM não for perfeito, isso quebra.

Considere um caso em que o LLM avalia corretamente 80% das vezes.

Mais especificamente, se a resposta estiver correta, o LLM diz "isso parece correto" com 80% de probabilidade, e os mesmos 80% se aplicam quando a resposta está realmente errada.

Nessa situação, você não deve reportar a probabilidade empírica, pois ela é tendenciosa. Por que?

Seja a probabilidade real de o modelo testado estar correto como p.

Então a probabilidade empírica de que o LLM diga "correto" (= q) é

q = 0,8p + 0,2(1 - p) = 0,2 + 0,6p

Portanto, a estimativa imparcial deveria ser

(q - 0.2) / 0.6

As coisas ficam ainda mais interessantes se o padrão de erro for assimétrico ou se você não conhece essas taxas de erro a priori.

===

Então, o que isso significa?

Primeiro, siga a diretriz sugerida em nosso preprint.

Não há almoço grátis. Você não pode avaliar a qualidade do seu modelo a menos que seu LLM, como juiz, seja conhecido por ser perfeito em avaliá-lo.

Dependendo de quão próximo ele está de um avaliador perfeito, você precisa de um conjunto de teste de tamanho suficiente (= conjunto de calibração) para estimar as taxas de erro do avaliador, e então deve corrigi-las.

Segundo, muito infelizmente, muitas descobertas que vimos em artigos nos últimos anos precisam ser revisadas.

A menos que dois jornais tenham usado exatamente o mesmo LLM que um juiz, comparar resultados entre eles poderia ter produzido alegações falsas. A melhoria pode simplesmente vir de uma leve alteração no pipeline de avaliação. Um metaestudo rigoroso é urgentemente necessário.

===

Resumo:

(1) Quase todas as avaliações do LLM como juiz nos últimos anos foram reportadas com um estimador tendencioso.

(2) É fácil de corrigir, então aguarde nosso preprint completo.

(3) Muitos resultados de LLM como juiz devem ser encarados com cautela.

O pré-print completo chegará em alguns dias, então fiquem ligados!

Trabalho incrível dos meus alunos e colaboradores.

@chungpa_lee @tomzeng200 @jongwonjeong123 e @jysohn1108

203,83K

Um tópico mais sério sobre o hype do DeepSeek-OCR / sérias interpretações errôneas acontecendo.

1.

Na redução de token por meio da representação de texto em imagens, pesquisadores de Cambridge mostraram anteriormente que a compactação de token de prompt de 500x é possível (ACL'25, Li, Su e Collier).

Sem usar a ideia de converter texto em imagens.

2.

Não devemos atribuir o sucesso do DeepSeek OCR ao poder da representação de imagens.

Ao mesmo tempo, não há nada fundamentalmente errado com a representação de texto com qualquer tokenizador.

Na verdade, você pode fazer o oposto do que o DeepSeek-OCR fez, ou seja, você pode representar imagens como uma sequência de tokens de texto (cada um representando seus valores RGB), e as coisas funcionarão bem. (Veja o artigo LIFT.)

3.

A única conclusão correta é que os atuais espaços de incorporação usados pelos LLMs são enormes e talvez até muito desperdiçadores.

E o mais importante, ainda não estamos fazendo uso total deles.

4.

Há muitas evidências recentes que apóiam a mesma mensagem.

Por exemplo, é mostrado que, se você fornecer demonstrações no contexto de várias tarefas, mas misturadas em um único contexto, seu modelo poderá resolver várias tarefas de previsão de ICL simultaneamente. (Veja o artigo TUDO EM TODOS OS LUGARES AO MESMO TEMPO.)

5.

tldr;

- DeepSeek-OCR é legal

- mas você pode obter uma taxa de redução de token mais alta apenas ajustando LLMs em tokens de texto espremidos

- há mais evidências de que os LLMs não estão utilizando totalmente o grande espaço de incorporação e a enorme quantidade de computação que entra no momento da inferência

- e essa é a única lição real que você deve tirar

85,99K

DLLMs parecem promissores ... mas a geração paralela nem sempre é possível

Os LLMs baseados em difusão podem gerar muitos tokens em diferentes posições ao mesmo tempo, enquanto a maioria dos LLMs autorregressivos gera tokens um por um.

Isso torna os LLMs baseados em difusão altamente atraentes quando precisamos de geração rápida com menos computação.

Uma grande questão é ... A geração paralela é possível sem perder a precisão da modelagem?

A resposta é não. Existem limites fundamentais sobre quanto paralelismo podemos alcançar.

Considere este exemplo:

"Escolha uma cidade uniformemente aleatoriamente entre as quatro cidades a seguir:

Nova York, Nova Orleans, Cidade do México ou Cidade do Panamá.

Então

P(Y₁ = Novo, Y₂ = York) = 1/4,

P(Y₁ = Novo, Y₂ = Orleans) = 1/4 e assim por diante.

Assim, P(Y₁ = Novo) = 1/2, P(Y₂ = Cidade) = 1/2.

Se você optar por gerar Y₁ e Y₂ em paralelo, não importa qual algoritmo de decodificação você use ...

Você está condenado a experimentar "New City".

Nenhum dos DLLMs de hoje pode gerar essas duas palavras corretamente sem abrir mão do paralelismo.

-----

Por que esse é o caso?

Na verdade, nunca treinamos LLMs para aprender a distribuição conjunta em vários tokens em uma iteração direta.

Sempre ensinamos uma distribuição marginal de token único condicionada ao contexto.

(O mesmo vale para modelos autorregressivos também.)

Portanto, a amostragem de vários tokens de uma só vez só é possível quando esses tokens são mutuamente independentes, dado o contexto atual.

E essa limitação da amostragem paralela pode ser formalizada com precisão.

Pode-se derivar um limite teórico da informação que seja agnóstico em relação à estratégia de decodificação e também derivar limites específicos da estratégia.

-----

Então, os DLLMs estão condenados? Não!

Eles têm um enorme potencial para economizar computação e tempo.

Mas:

(1) precisamos estar cientes de suas limitações fundamentais, e

(2) precisamos projetar melhores estratégias de treinamento e decodificação.

Em particular, há um enorme espaço para melhorias na decodificação.

Por que?

Idealmente, queremos que o modelo controle o grau de paralelismo durante a geração.

Ao mesmo tempo, ele deve escolher um subconjunto de tokens futuros que sejam quase mutuamente independentes, dado o contexto atual.

As estratégias de decodificação atuais são boas nisso?

Difícil dizer.

A maioria dos DLLMs nunca foi testada para isso.

-----

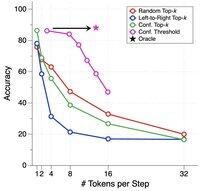

É por isso que introduzimos um benchmark sintético para testar o estresse de DLLMs.

Nós o chamamos de ParallelBench.

A ideia é simples: essas são tarefas de linguagem natural, mas cuidadosamente projetadas para que a geração paralela seja inerentemente difícil.

(Pense em "Cidade Nova", mas tarefas mais naturais e reais.)

O que encontramos?

Testamos DLLMs populares com vários algoritmos de decodificação, e nenhum chegou perto do desempenho "oracle", o desempenho ideal que você obteria se o modelo pudesse ajustar seu paralelismo de maneira ideal durante a decodificação.

-----

Takeaway:

(1) A geração paralela nem sempre é possível e confira nosso artigo para obter mais detalhes :)

(2) Se você puder projetar um DLLM que corresponda ao desempenho do oráculo em nosso benchmark, bem, quem sabe, você pode receber uma ligação de alguém em Menlo Park. 😉

63,81K

Melhores

Classificação

Favoritos