المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kangwook Lee

جامعة ويسكونسن ماديسون / كرافتون الذكاء الاصطناعي

أصبح نموذج اللغة الكبيرة كقاض وسيلة مهيمنة لتقييم مدى كفاءة النموذج في حل مهمة، لأنه يعمل بدون مجموعة اختبارات ويتعامل مع الحالات التي لا تكون فيها الإجابات فريدة.

ولكن رغم مدى انتشار هذا الاستخدام، فإن معظم النتائج المبلغ عنها متحيزة للغاية.

متحمس لمشاركة طباعتنا التمهيدية حول كيفية استخدام LLM بشكل صحيح كحكم.

🧵

===

فكيف يستخدم الناس LLM فعليا كحكم؟

معظم الناس يستخدمون النموذج كمثمن ويبلغون عن الاحتمال التجريبي بأن النموذج يقول إن الإجابة تبدو صحيحة.

عندما يكون نموذج اللغة الكبير مثاليا، يعمل هذا بشكل جيد ويعطي تقديرا غير متحيز.

إذا لم يكن نموذج اللغة الكبير مثاليا، ينكسر هذا القانون.

تخيل حالة يقوم فيها المدير الكبير بتقييم صحيح بنسبة 80 بالمئة من الوقت.

وبشكل أكثر تحديدا، إذا كانت الإجابة صحيحة، تقول النموذج الكبير "يبدو صحيحا" باحتمال 80 بالمئة، ونفس النسبة تنطبق عندما تكون الإجابة خاطئة فعليا.

في هذه الحالة، لا يجب أن تبلغ عن الاحتمال التجريبي لأنه منحاز. لماذا؟

لتكن الاحتمال الحقيقي لصحة النموذج المختبر هو p.

حينها فإن الاحتمال التجريبي بأن يقول النموذج "صحيح" (= q) هو

q = 0.8p + 0.2(1 - p) = 0.2 + 0.6p

لذا يجب أن يكون التقدير غير المتحيز

(ق - 0.2) / 0.6

تصبح الأمور أكثر إثارة إذا كان نمط الخطأ غير متماثل أو إذا لم تكن تعرف هذه معدلات الخطأ مسبقا.

===

فماذا يعني هذا؟

أولا، اتبع الإرشادات المقترحة في ما قبل الطبع.

لا يوجد غداء مجاني. لا يمكنك تقييم مدى جودة نموذجك إلا إذا كان الماجستير الكبير كقاض معروفا بأنه مثالي في الحكم عليه.

اعتمادا على مدى قربه من المقيم المثالي، تحتاج إلى حجم كاف من مجموعة الاختبار (= مجموعة معايرة) لتقدير معدلات الأخطاء لدى المقيم، ثم يجب تصحيحها.

ثانيا، وللأسف الشديد، العديد من النتائج التي رأيناها في الأوراق خلال السنوات القليلة الماضية تحتاج إلى إعادة نظر.

ما لم تستخدم ورقتان نفس نموذج اللغة الكبيرة كقاض، فإن مقارنة النتائج بينهما قد تؤدي إلى ادعاءات خاطئة. قد يأتي التحسن ببساطة من تغيير بسيط في مسار التقييم. هناك حاجة ماسة إلى دراسة ميتا صارمة.

===

ملخص:

(1) تقريبا جميع تقييمات LLM-كقاض في السنوات القليلة الماضية تم الإبلاغ عنها باستخدام مقدر متحيز.

(2) من السهل إصلاحه، لذا انتظر الطباعة الكاملة للطباعة المسبقة.

(3) يجب التعامل مع العديد من نتائج LLM كحكم بحذر.

الطباعة الكاملة قبل الطباعة قادمة خلال أيام قليلة، فتابعونا!

عمل مذهل من طلابي ومتعاوني.

@chungpa_lee @tomzeng200 @jongwonjeong123 @jysohn1108

203.83K

موضوع أكثر جدية حول ضجيج DeepSeek-OCR / سوء التفسير الخطير يحدث.

1.

فيما يتعلق بتقليل الرمز المميز من خلال تمثيل النص في الصور ، أظهر باحثون من كامبريدج سابقا أن ضغط الرمز المميز الفوري بمعدل 500x ممكن (ACL'25 و Li و Su و Collier).

دون استخدام فكرة تحويل النص إلى صور.

2.

لا ينبغي أن نعزو نجاح DeepSeek OCR إلى قوة تمثيل الصور.

في الوقت نفسه ، لا يوجد شيء خاطئ بشكل أساسي في تمثيل النص مع أي رمز مميز.

في الواقع ، يمكنك أن تفعل عكس ما فعله DeepSeek-OCR ، أي أنه يمكنك تمثيل الصور كسلسلة من الرموز المميزة للنص (كل منها يمثل قيم RGB الخاصة به) ، وستعمل الأشياء بشكل جيد. (انظر ورقة LIFT.)

3.

الوجبات الجاهزة الصحيحة الوحيدة هي أن مساحات التضمين الحالية التي تستخدمها LLMs هائلة وربما حتى مهدرة للغاية.

والأهم من ذلك ، أننا لا نستفيد منها بشكل كامل بعد.

4.

هناك الكثير من الأدلة الحديثة التي تدعم نفس الرسالة.

على سبيل المثال ، يظهر أنه إذا قمت بتقديم عروض توضيحية في السياق من مهام متعددة ولكنها مختلطة في سياق واحد ، فيمكن لنموذجك حل مهام تنبؤ ICL متعددة في وقت واحد. (انظر ورقة كل شيء في كل مكان في وقت واحد.)

5.

TLDR.

- DeepSeek-OCR رائع

- ولكن يمكنك تحقيق معدل تخفيض أعلى للرمز المميز بمجرد ضبط LLMs على الرموز المميزة للنص المضغوط

- هناك المزيد من الأدلة على أن LLMs لا تستخدم بشكل كامل مساحة التضمين الكبيرة والكمية الهائلة من الحوسبة التي تدخل في وقت الاستدلال

- وهذا هو الأخذ الحقيقي الوحيد الذي يجب أن تأخذه

86K

تبدو DLLMs واعدة ... لكن التوليد الموازي ليس ممكنا دائما

يمكن أن تولد LLMs المستندة إلى الانتشار العديد من الرموز المميزة في مواضع مختلفة في وقت واحد ، بينما تولد معظم LLMs ذاتية الانحدار الرموز المميزة واحدا تلو الآخر.

هذا يجعل LLMs القائمة على الانتشار جذابة للغاية عندما نحتاج إلى توليد سريع مع حوسبة أقل.

السؤال الكبير هو ... هل التوليد المتوازي ممكن دون فقدان دقة النمذجة؟

الإجابة لا. هناك حدود أساسية على مقدار التوازي الذي يمكننا تحقيقه.

ضع في اعتبارك هذا المثال:

"اختر مدينة واحدة بشكل موحد بشكل عشوائي من المدن الأربع التالية:

نيويورك أو نيو أورلينز أو مكسيكو سيتي أو بنما سيتي."

ثم

P (Y₁ = جديد ، Y₂ = يورك) = 1/4 ،

P (Y₁ = جديد ، Y₂ = أورليانز) = 1/4 ، وهكذا.

وبالتالي ، P (Y₁ = جديد) = 1/2 ، P (Y₂ = مدينة) = 1/2.

إذا اخترت إنشاء Y₁ و Y₂ بالتوازي ، بغض النظر عن خوارزمية فك التشفير التي تستخدمها ...

محكوم عليك بتجربة "مدينة جديدة".

لا يمكن لأي من DLLMs اليوم إنشاء هاتين الكلمتين بشكل صحيح دون التخلي عن التوازي.

-----

لماذا هذا هو الحال؟

في الواقع ، نحن لا نقوم أبدا بتدريب LLMs على تعلم التوزيع المشترك على رموز متعددة في تكرار أمامي واحد.

نحن نعلم دائما توزيعا هامشيا أحادي الرمز المشروط بالسياق.

(الأمر نفسه ينطبق على نماذج الانحدار الذاتي أيضا.)

لذلك ، لا يمكن أخذ عينات من رموز متعددة في وقت واحد إلا عندما تكون هذه الرموز مستقلة بشكل متبادل بالنظر إلى السياق الحالي.

ويمكن إضفاء الطابع الرسمي على هذا القيد على أخذ العينات المتوازية بدقة.

يمكن للمرء أن يستمد حدا نظريا للمعلومات لا يحدد استراتيجية فك التشفير ، وكذلك اشتقاق حدود خاصة بالاستراتيجية.

-----

فهل DLLMs محكوم عليها بالفشل؟ لا!

لديهم إمكانات هائلة لتوفير الحوسبة والوقت.

لكن:

(1) نحن بحاجة إلى أن نكون على دراية بحدودها الأساسية، و

(2) نحن بحاجة إلى تصميم استراتيجيات تدريب وفك تشفير أفضل.

على وجه الخصوص ، هناك مجال كبير للتحسين في فك التشفير.

لماذا؟

من الناحية المثالية ، نريد أن يتحكم النموذج في درجة التوازي أثناء التوليد.

في الوقت نفسه ، يجب أن تختار مجموعة فرعية من الرموز المستقبلية التي تكون مستقلة بشكل متبادل تقريبا بالنظر إلى السياق الحالي.

هل استراتيجيات فك التشفير الحالية جيدة في هذا؟

من الصعب معرفة ذلك.

لم يتم اختبار الإجهاد لمعظم DLLMs من أبدا.

-----

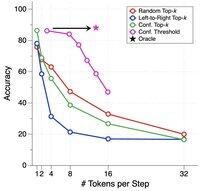

لهذا السبب قدمنا معيارا اصطناعيا لاختبار DLLMs لاختبار الإجهاد.

نسميها ParallelBench.

الفكرة بسيطة: هذه مهام لغة طبيعية ، ولكنها مصممة بعناية بحيث يكون التوليد الموازي صعبا بطبيعته.

(فكر في "مدينة جديدة" ، ولكن مهام أكثر طبيعية وحقيقية.)

ماذا توصلنا إلى ذلك؟

اختبرنا DLLMs الشائعة باستخدام خوارزميات فك تشفير مختلفة ، ولم يقترب أي منها من أداء "أوراكل" ، وهو الأداء المثالي الذي ستحصل عليه إذا كان بإمكان النموذج ضبط التوازي على النحو الأمثل أثناء فك التشفير.

-----

الوجبات الجاهزه:

(1) التوليد المتوازي غير ممكن دائما وتحقق من ورقتنا لمزيد من التفاصيل :)

(2) إذا كان بإمكانك تصميم DLLM يطابق أداء أوراكل على معيارنا ، حسنا ، من يدري ، قد تتلقى مكالمة من شخص ما في مينلو بارك. 😉

63.82K

الأفضل

المُتصدِّرة

التطبيقات المفضلة