Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kangwook Lee

UW Madison / KRAFTON AI

LLM sebagai hakim telah menjadi cara dominan untuk mengevaluasi seberapa baik model dalam menyelesaikan tugas, karena bekerja tanpa set tes dan menangani kasus-kasus di mana jawabannya tidak unik.

Tetapi terlepas dari seberapa luas ini digunakan, hampir semua hasil yang dilaporkan sangat bias.

Senang membagikan pracetak kami tentang cara menggunakan LLM dengan benar sebagai juri.

🧵

===

Jadi bagaimana orang benar-benar menggunakan LLM sebagai hakim?

Kebanyakan orang hanya menggunakan LLM sebagai evaluator dan melaporkan probabilitas empiris bahwa LLM mengatakan jawabannya terlihat benar.

Ketika LLM sempurna, ini bekerja dengan baik dan memberikan estimator yang tidak bias.

Jika LLM tidak sempurna, ini rusak.

Pertimbangkan kasus di mana LLM mengevaluasi dengan benar 80 persen dari waktu.

Lebih khusus lagi, jika jawabannya benar, LLM mengatakan "ini terlihat benar" dengan probabilitas 80 persen, dan 80 persen yang sama berlaku ketika jawabannya benar-benar salah.

Dalam situasi ini, Anda tidak boleh melaporkan probabilitas empiris, karena bias. Mengapa?

Biarkan probabilitas sebenarnya dari model yang diuji benar adalah p.

Kemudian probabilitas empiris bahwa LLM mengatakan "benar" (= q) adalah

q = 0.8p + 0.2(1 - p) = 0.2 + 0.6p

Jadi perkiraan yang tidak bias harus

(q - 0.2) / 0.6

Segalanya menjadi lebih menarik jika pola kesalahan asimetris atau jika Anda tidak mengetahui tingkat kesalahan ini secara apriori.

===

Jadi apa artinya ini?

Pertama, ikuti pedoman yang disarankan di pracetak kami.

Tidak ada makan siang gratis. Anda tidak dapat mengevaluasi seberapa baik model Anda kecuali LLM Anda sebagai juri dikenal sempurna dalam menilainya.

Tergantung pada seberapa dekat dengan evaluator yang sempurna, Anda memerlukan ukuran set pengujian yang cukup (= set kalibrasi) untuk memperkirakan tingkat kesalahan evaluator, dan kemudian Anda harus mengoreksinya.

Kedua, sangat disayangkan, banyak temuan yang telah kita lihat dalam makalah selama beberapa tahun terakhir perlu ditinjau kembali.

Kecuali dua makalah menggunakan LLM yang sama persis sebagai hakim, membandingkan hasil di antara mereka dapat menghasilkan klaim palsu. Peningkatan bisa saja datang dari sedikit mengubah saluran evaluasi. Studi meta yang ketat sangat dibutuhkan.

===

TLDR:

(1) Hampir semua evaluasi LLM-as-a-judge dalam beberapa tahun terakhir dilaporkan dengan estimator bias.

(2) Mudah diperbaiki, jadi tunggu pracetak lengkap kami.

(3) Banyak hasil LLM-as-a-judge harus diambil dengan butiran garam.

Pracetak lengkap akan hadir dalam beberapa hari, jadi nantikan!

Pekerjaan luar biasa oleh siswa dan kolaborator saya.

@chungpa_lee @tomzeng200 @jongwonjeong123 dan @jysohn1108

203,8K

Utas yang lebih serius tentang hype DeepSeek-OCR / salah tafsir serius yang terjadi.

1.

Pada pengurangan token melalui merepresentasikan teks dalam gambar, para peneliti dari Cambridge sebelumnya telah menunjukkan bahwa kompresi token prompt 500x dimungkinkan (ACL'25, Li, Su, dan Collier).

Tanpa menggunakan ide untuk mengubah teks menjadi gambar.

2.

Kita tidak boleh mengaitkan keberhasilan OCR DeepSeek dengan kekuatan representasi gambar.

Pada saat yang sama, tidak ada yang salah secara mendasar dengan representasi teks dengan tokenizer apa pun.

Faktanya, Anda dapat melakukan kebalikan dari apa yang dilakukan DeepSeek-OCR, yaitu, Anda dapat mewakili gambar sebagai urutan token teks (masing-masing mewakili nilai RGB-nya), dan semuanya akan berfungsi dengan baik. (Lihat makalah LIFT.)

3.

Satu-satunya kesimpulan yang benar adalah bahwa ruang penyematan saat ini yang digunakan oleh LLM sangat besar dan bahkan mungkin sangat boros.

Dan yang terpenting, kami belum memanfaatkannya sepenuhnya.

4.

Ada banyak bukti terbaru yang mendukung pesan yang sama.

Misalnya, ditunjukkan bahwa jika Anda memberikan demonstrasi konteks dari beberapa tugas tetapi dicampur dalam satu konteks, maka model Anda dapat menyelesaikan beberapa tugas prediksi ICL secara bersamaan. (Lihat makalah EVERYTHING EVERYWHERE ALL AT ONCE.)

5.

tldr;

- DeepSeek-OCR keren

- tetapi Anda dapat mencapai tingkat pengurangan token yang lebih tinggi hanya dengan menyempurnakan LLM pada token teks yang diperas

- ada lebih banyak bukti bahwa LLM tidak sepenuhnya memanfaatkan ruang penyematan yang besar dan sejumlah besar komputasi yang masuk pada waktu inferensi

- dan itulah satu-satunya hal nyata yang harus Anda ambil

85,96K

DLLM tampaknya menjanjikan... Tetapi generasi paralel tidak selalu mungkin

LLM berbasis difusi dapat menghasilkan banyak token pada posisi yang berbeda sekaligus, sementara sebagian besar LLM regresif otomatis menghasilkan token satu per satu.

Hal ini membuat LLM berbasis difusi sangat menarik ketika kita membutuhkan generasi cepat dengan komputasi yang lebih sedikit.

Pertanyaan besar adalah ... Apakah pembuatan paralel dimungkinkan tanpa kehilangan akurasi pemodelan?

Jawabannya tidak. Ada batasan mendasar pada seberapa banyak paralelisme yang dapat kita capai.

Pertimbangkan contoh ini:

"Pilih satu kota secara seragam secara acak dari empat kota berikut:

New York, New Orleans, Mexico City, atau Panama City."

Kemudian

P(Y₁ = Baru, Y₂ = York) = 1/4,

P(Y₁ = Baru, Y₂ = Orleans) = 1/4, dan seterusnya.

Jadi, P(Y₁ = Baru) = 1/2, P(Y₂ = Kota) = 1/2.

Jika Anda memilih untuk menghasilkan Y₁ dan Y₂ secara paralel, apa pun algoritme decoding yang Anda gunakan ...

Anda ditakdirkan untuk mencicipi "New City."

Tidak ada DLLM saat ini yang dapat menghasilkan dua kata ini dengan benar tanpa melepaskan paralelisme.

-----

Mengapa ini terjadi?

Faktanya, kami tidak pernah melatih LLM untuk mempelajari distribusi bersama melalui beberapa token dalam satu iterasi ke depan.

Kami selalu mengajarkan distribusi marjinal token tunggal yang dikondisikan pada konteks.

(Hal yang sama berlaku untuk model autoregresif juga.)

Oleh karena itu, pengambilan sampel beberapa token sekaligus hanya dimungkinkan jika token tersebut saling independen mengingat konteks saat ini.

Dan keterbatasan pengambilan sampel paralel ini dapat diformalkan dengan tepat.

Seseorang dapat memperoleh batas teori informasi yang agnostik strategi decoding, dan juga menurunkan batas khusus strategi.

-----

Jadi, apakah DLLM ditakdirkan? Tidak!

Mereka memiliki potensi besar untuk menghemat komputasi dan waktu.

Tapi:

(1) kita perlu menyadari keterbatasan mendasar mereka, dan

(2) kita perlu merancang strategi pelatihan dan decoding yang lebih baik.

Secara khusus, ada ruang besar untuk perbaikan dalam decoding.

Mengapa?

Idealnya, kami ingin model mengontrol tingkat paralelisme selama generasi.

Pada saat yang sama, ia harus memilih subset token masa depan yang hampir saling independen mengingat konteks saat ini.

Apakah strategi decoding saat ini bagus dalam hal ini?

Sulit untuk mengatakannya.

Sebagian besar DLLM tidak pernah diuji stres untuk itu.

-----

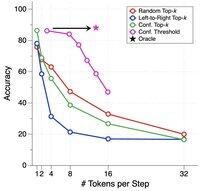

Itu sebabnya kami memperkenalkan tolok ukur sintetis untuk menguji stres DLLM.

Kami menyebutnya ParallelBench.

Idenya sederhana: ini adalah tugas bahasa alami, tetapi dirancang dengan hati-hati sehingga generasi paralel pada dasarnya sulit.

(Pikirkan "Kota Baru", tetapi tugas yang lebih alami dan nyata.)

Apa yang kami temukan?

Kami menguji DLLM populer dengan berbagai algoritme dekode, dan tidak ada yang mendekati kinerja "oracle", kinerja ideal yang akan Anda dapatkan jika model dapat menyesuaikan paralelismenya secara optimal selama decoding.

-----

Takeaway:

(1) Generasi paralel tidak selalu mungkin dan lihat makalah kami untuk detail lebih lanjut :)

(2) Jika Anda dapat merancang DLLM yang sesuai dengan kinerja oracle pada benchmark kami, yah, siapa tahu, Anda mungkin akan mendapatkan telepon dari seseorang di Menlo Park. 😉

63,71K

Teratas

Peringkat

Favorit