Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kangwook Lee

UW Madison / KRAFTON AI

El LLM como juez se ha convertido en una forma dominante de evaluar la calidad de un modelo para resolver una tarea, ya que funciona sin un conjunto de pruebas y maneja casos en los que las respuestas no son únicas.

Pero a pesar de lo ampliamente utilizado que se utiliza, casi todos los resultados reportados están muy sesgados.

Estoy emocionado de compartir nuestro preprint sobre cómo usar correctamente LLM como juez.

🧵

===

Entonces, ¿cómo es que la gente usa realmente LLM como juez?

La mayoría de la gente simplemente usa el LLM como evaluador y reporta la probabilidad empírica de que el LLM diga que la respuesta parece correcta.

Cuando el LLM es perfecto, esto funciona bien y proporciona un estimador imparcial.

Si el LLM no es perfecto, esto se rompe.

Consideremos un caso en el que el LLM evalúa correctamente el 80 por ciento de las veces.

Más concretamente, si la respuesta es correcta, el LLM dice "esto parece correcto" con un 80 por ciento de probabilidad, y el mismo 80 por ciento se aplica cuando la respuesta es realmente incorrecta.

En esta situación, no deberías informar de la probabilidad empírica, porque está sesgada. ¿Por qué?

Sea la probabilidad real de que el modelo probado sea correcto p.

Entonces, la probabilidad empírica de que el LLM diga "correcto" (= q) es

q = 0.8p + 0.2(1 - p) = 0.2 + 0.6p

Así que la estimación imparcial debería ser

(q - 0.2) / 0.6

Las cosas se ponen aún más interesantes si el patrón de error es asimétrico o si no conoces estas tasas de error a priori.

===

¿Y qué significa esto?

Primero, sigue la guía sugerida en nuestro preprint.

No hay comida gratis. No puedes evaluar lo bueno que es tu modelo a menos que tu LLM como juez sea conocido por ser perfecto para juzgarlo.

Dependiendo de lo cerca que esté de un evaluador perfecto, necesitas un conjunto de pruebas de tamaño suficiente (= conjunto de calibración) para estimar las tasas de error del evaluador, y luego debes corregirlas.

En segundo lugar, muy desafortunadamente, muchos de los hallazgos que hemos visto en los últimos años necesitan ser revisados.

A menos que dos periódicos usaran exactamente el mismo LLM que un juez, comparar resultados entre ellos podría haber producido afirmaciones falsas. La mejora podría venir simplemente de cambiar ligeramente la cadena de evaluación. Se necesita urgentemente un metaestudio riguroso.

===

Resumen:

(1) Casi todas las evaluaciones de LLM como juez en los últimos años se reportaron con un estimador sesgado.

(2) Es fácil de arreglar, así que espera nuestro preprint completo.

(3) Muchos resultados de LLM como juez deben tomarse con cautela.

Preprint completo llegará en unos días, ¡así que estad atentos!

Un trabajo increíble de mis estudiantes y colaboradores.

@chungpa_lee @tomzeng200 @jongwonjeong123 y @jysohn1108

203.82K

Un hilo más serio sobre la exageración de DeepSeek-OCR / grave mala interpretación en curso.

1.

En cuanto a la reducción de tokens mediante la representación de texto en imágenes, los investigadores de Cambridge han demostrado previamente que es posible la compresión de tokens de 500x (ACL'25, Li, Su y Collier).

Sin usar la idea de convertir texto en imágenes.

2.

No debemos atribuir el éxito de DeepSeek OCR al poder de la representación de imágenes.

Al mismo tiempo, no hay nada fundamentalmente malo en la representación de texto con cualquier tokenizador.

De hecho, puede hacer lo contrario de lo que hizo DeepSeek-OCR, es decir, puede representar imágenes como una secuencia de tokens de texto (cada uno de los cuales representa sus valores RGB), y las cosas funcionarán bien. (Ver el documento LIFT).

3.

La única conclusión correcta es que los espacios de incrustación actuales utilizados por los LLM son enormes y tal vez incluso muy derrochadores.

Y lo que es más importante, aún no los estamos utilizando al máximo.

4.

Hay mucha evidencia reciente que respalda el mismo mensaje.

Por ejemplo, se muestra que si proporciona demostraciones en contexto de múltiples tareas pero mezcladas en un solo contexto, entonces su modelo puede resolver múltiples tareas de predicción ICL simultáneamente. (Ver el documento EVERYTHING EVERYWHERE ALL AT ONCE).

5.

TLDR;

- DeepSeek-OCR es genial

- pero puede lograr una tasa de reducción de tokens más alta simplemente ajustando los LLM en tokens de texto comprimidos

- hay más evidencia de que los LLM no están utilizando completamente el gran espacio de incrustación y la gran cantidad de cómputo que entra en el momento de la inferencia

- Y esa es la única conclusión real que debes llevarte

85.98K

Los DLLM parecen prometedores... Pero la generación paralela no siempre es posible

Los LLM basados en difusión pueden generar muchos tokens en diferentes posiciones a la vez, mientras que la mayoría de los LLM autorregresivos generan tokens uno por uno.

Esto hace que los LLM basados en difusión sean muy atractivos cuando necesitamos una generación rápida con menos computación.

Una gran pregunta es ... ¿Es posible la generación paralela sin perder precisión de modelado?

La respuesta es no. Hay límites fundamentales sobre cuánto paralelismo podemos lograr.

Considere este ejemplo:

"Elija una ciudad uniformemente al azar de las siguientes cuatro ciudades:

Nueva York, Nueva Orleans, Ciudad de México o Ciudad de Panamá".

Entonces

P(Y₁ = Nuevo, Y₂ = York) = 1/4,

P(Y₁ = Nuevo, Y₂ = Orleans) = 1/4, y así sucesivamente.

Por lo tanto, P(Y₁ = Nuevo) = 1/2, P(Y₂ = Ciudad) = 1/2.

Si elige generar Y₁ e Y₂ en paralelo, sin importar qué algoritmo de decodificación use ...

Estás condenado a probar "New City".

Ninguno de los DLLM actuales puede generar estas dos palabras correctamente sin renunciar al paralelismo.

-----

¿Por qué es así?

De hecho, nunca entrenamos a los LLM para que aprendan la distribución conjunta en múltiples tokens en una iteración hacia adelante.

Siempre enseñamos una distribución marginal de un solo token condicionada por el contexto.

(Lo mismo ocurre con los modelos autorregresivos).

Por lo tanto, el muestreo de varios tokens a la vez solo es posible cuando esos tokens son mutuamente independientes dado el contexto actual.

Y esta limitación del muestreo paralelo se puede formalizar con precisión.

Se puede derivar un límite teórico de la información que es independiente de la estrategia de decodificación, y también derivar límites específicos de la estrategia.

-----

Entonces, ¿están condenados los DLLM? ¡No!

Tienen un enorme potencial para ahorrar computación y tiempo.

Pero:

(1) debemos ser conscientes de sus limitaciones fundamentales, y

(2) necesitamos diseñar mejores estrategias de entrenamiento y decodificación.

En particular, hay un gran margen de mejora en la decodificación.

¿Por qué?

Idealmente, queremos que el modelo controle el grado de paralelismo durante la generación.

Al mismo tiempo, debe elegir un subconjunto de tokens futuros que sean casi independientes entre sí dado el contexto actual.

¿Son buenas las estrategias de decodificación actuales en esto?

Difícil de decir.

La mayoría de los DLLM nunca fueron sometidos a pruebas de estrés.

-----

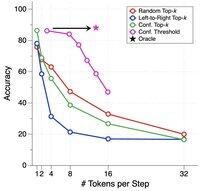

Es por eso que introdujimos un punto de referencia sintético para realizar pruebas de estrés DLLM.

Lo llamamos ParallelBench.

La idea es simple: estas son tareas de lenguaje natural, pero cuidadosamente diseñadas para que la generación paralela sea intrínsecamente difícil.

(Piense en "Ciudad Nueva", pero tareas más naturales y reales).

¿Qué se encontró?

Probamos DLLM populares con varios algoritmos de decodificación, y ninguno se acercó al rendimiento de "oráculo", el rendimiento ideal que obtendría si el modelo pudiera ajustar de manera óptima su paralelismo durante la decodificación.

-----

Llevar:

(1) La generación paralela no siempre es posible y consulte nuestro documento para obtener más detalles :)

(2) Si puede diseñar un DLLM que coincida con el rendimiento de Oracle en nuestro punto de referencia, bueno, quién sabe, es posible que reciba una llamada de alguien en Menlo Park. 😉

63.77K

Populares

Ranking

Favoritas