Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kangwook Lee

UW Madison / KRAFTON AI

LLM tuomarina on muodostunut hallitsevaksi tavaksi arvioida, kuinka hyvä malli on tehtävän ratkaisemisessa, koska se toimii ilman testijoukkoa ja käsittelee tapauksia, joissa vastaukset eivät ole ainutlaatuisia.

Mutta siitä huolimatta, kuinka laajasti tätä käytetään, lähes kaikki raportoidut tulokset ovat erittäin puolueellisia.

Olen innoissani voidessamme jakaa preprinttimme siitä, miten LLM:ää käytetään oikein tuomarina.

🧵

===

Joten miten ihmiset oikeasti käyttävät LLM:ää tuomarina?

Useimmat käyttävät LLM:ää arvioijana ja raportoivat empiirisen todennäköisyyden, että LLM sanoo vastauksen olevan oikea.

Kun LLM on täydellinen, tämä toimii hyvin ja antaa puolueettoman estimaattorin.

Jos LLM ei ole täydellinen, tämä menee rikki.

Otetaan esimerkiksi tilanne, jossa LLM arvioi oikein 80 prosenttia tapauksista.

Tarkemmin sanottuna, jos vastaus on oikea, LLM sanoo "tämä näyttää oikealta" 80 prosentin todennäköisyydellä, ja sama 80 prosenttia pätee, kun vastaus on oikeasti väärä.

Tässä tilanteessa sinun ei pitäisi raportoida empiiristä todennäköisyyttä, koska se on puolueellinen. Miksi?

Olkoon todellinen todennäköisyys, että testattu malli on oikea, p.

Silloin empiirinen todennäköisyys, että LLM sanoo "oikea" (= q), on

q = 0,8p + 0,2(1 - p) = 0,2 + 0,6p

Joten puolueeton arvio pitäisi olla

(q - 0.2) / 0.6

Tilanne muuttuu entistä mielenkiintoisemmaksi, jos virhekuvio on epäsymmetrinen tai jos et tiedä näitä virheprosentteja etukäteen.

===

Mitä tämä siis tarkoittaa?

Ensiksi noudata esipainoksessamme ehdotettua ohjetta.

Ilmaista lounasta ei ole. Et voi arvioida, kuinka hyvä mallisi on, ellei LLM:si tuomarina ole tunnettu täydellisenä arvioimaan.

Riippuen siitä, kuinka lähellä se on täydellistä arvioijaa, tarvitset riittävän koon testijoukon (= kalibrointisetin) arvioijan virheprosenttien arvioimiseksi, ja sen jälkeen sinun täytyy korjata ne.

Toiseksi, hyvin valitettavasti, monet löydökset, joita olemme viime vuosina nähneet artikkeleissa, täytyy tarkastella uudelleen.

Ellei kaksi lehteä käyttänyt täsmälleen samaa LLM:ää tuomarina, tulosten vertailu niiden välillä olisi voinut tuottaa vääriä väitteitä. Parannus voi johtua vain arvioinnin prosessia hieman muuttamisesta. Perusteellinen metatutkimus on kiireellisesti tarpeen.

===

Yhteenveto:

(1) Lähes kaikki viime vuosien LLM-tuomarina-arvioinnit raportoitiin puolueellisella estimaattorilla.

(2) Korjaaminen on helppoa, joten odota koko esipainoksemme.

(3) Monet LLM-tulokset tuomarina tulisi suhtautua varauksella.

Täysi esipainos tulee muutaman päivän päästä, joten pysykää kuulolla!

Upeaa työtä opiskelijoiltani ja yhteistyökumppaneiltani.

@chungpa_lee @tomzeng200 @jongwonjeong123 ja @jysohn1108

203,83K

Vakavampi lanka meneillään olevasta DeepSeek-OCR-hypestä / vakavasta väärintulkinnasta.

1.

Cambridgen tutkijat ovat aiemmin osoittaneet, että 500-kertainen kehotemerkkien pakkaus on mahdollista (ACL'25, Li, Su ja Collier).

Käyttämättä ajatusta tekstin muuntamisesta kuviksi.

2.

Meidän ei pitäisi katsoa DeepSeek OCR:n menestyksen johtuvan kuvan esittämisen voimasta.

Samaan aikaan ei ole mitään perustavanlaatuista vikaa tekstin esittämisessä millä tahansa tokenizerilla.

Itse asiassa voit tehdä päinvastoin kuin DeepSeek-OCR teki, eli voit esittää kuvia tekstimerkkien sarjana (joista jokainen edustaa RGB-arvojaan), ja asiat toimivat hyvin. (Katso LIFT-paperi.)

3.

Ainoa oikea johtopäätös on, että LLM:ien käyttämät nykyiset upotustilat ovat vain valtavia ja ehkä jopa erittäin tuhlaavia.

Ja mikä tärkeintä, emme hyödynnä niitä vielä täysimääräisesti.

4.

On paljon viimeaikaisia todisteita, jotka tukevat samaa sanomaa.

Esimerkiksi, että jos tarjoat kontekstissa esityksiä useista tehtävistä, mutta sekoitetaan yhteen kontekstiin, mallisi voi ratkaista useita ICL-ennustetehtäviä samanaikaisesti. (Katso EVERYTHING EVERYWHERE ALL AT ONCE-paperi.)

5.

TLDR;

- DeepSeek-OCR on siisti

- mutta voit saavuttaa korkeamman token-vähennysasteen vain hienosäätämällä LLM:iä puristetuissa tekstimerkeissä

- on enemmän todisteita siitä, että LLM:t eivät hyödynnä täysimääräisesti suurta upotustilaa ja valtavaa laskentamäärää, joka menee päättelyaikaan

- Ja se on ainoa todellinen take-away, joka sinun pitäisi ottaa pois

85,99K

DLLM:t vaikuttavat lupaavilta... Mutta rinnakkaistuotanto ei ole aina mahdollista

Diffuusiopohjaiset LLM:t voivat tuottaa useita tokeneita eri paikoissa kerralla, kun taas useimmat autoregressiiviset LLM:t tuottavat tokeneita yksitellen.

Tämä tekee diffuusiopohjaisista LLM:istä erittäin houkuttelevia, kun tarvitsemme nopeaa tuotantoa pienemmällä laskentamäärällä.

Suuri kysymys on... Onko rinnakkaistuotanto mahdollista menettämättä mallinnustarkkuutta?

Vastaus on ei. On olemassa perustavanlaatuiset rajat sille, kuinka paljon rinnakkaisuutta voimme saavuttaa.

Tarkastellaan tätä esimerkkiä:

"Valitse yksi kaupunki yhtenäisesti satunnaisesti seuraavista neljästä kaupungista:

New Yorkissa, New Orleansissa, Mexico Cityssä tai Panama Cityssä."

Sitten

P(Y₁ = uusi, Y₂ = York) = 1/4,

P(Y₁ = uusi, Y₂ = Orleans) = 1/4 ja niin edelleen.

Siten P(Y₁ = uusi) = 1/2, P(Y₂ = kaupunki) = 1/2.

Jos päätät luoda Y₁:n ja Y₂:n rinnakkain, riippumatta siitä, mitä dekoodausalgoritmia käytät...

Olet tuomittu näyttelemään "New Cityä".

Mikään nykypäivän DLLM:istä ei pysty luomaan näitä kahta sanaa oikein luopumatta rinnakkaisuudesta.

-----

Miksi näin on?

Itse asiassa emme koskaan kouluta LLM:iä oppimaan useiden tokenien yhteistä jakautumista yhdellä eteenpäin iteraatiolla.

Opetamme aina yhden tokenin marginaalijakauman, joka on ehdollinen kontekstin mukaan.

(Sama pätee myös autoregressiivisiin malleihin.)

Siksi useiden tokenien näytteenotto kerralla on mahdollista vain, jos nämä tokenit ovat toisistaan riippumattomia nykyisessä kontekstissa.

Ja tämä rinnakkaisnäytteenoton rajoitus voidaan virallistaa tarkasti.

Voidaan johtaa informaatioteoreettinen raja, joka on dekoodausstrategiasta riippumaton, ja myös johtaa strategiakohtaisia rajoja.

-----

Ovatko DLLM:t siis tuhoon tuomittuja? Ei!

Niillä on valtava potentiaali säästää laskentaa ja aikaa.

Mutta:

(1) meidän on oltava tietoisia niiden perustavanlaatuisista rajoituksista ja

(2) meidän on suunniteltava parempia koulutus- ja dekoodausstrategioita.

Erityisesti dekoodauksessa on valtavasti parantamisen varaa.

Miksi?

Ihannetapauksessa haluamme, että malli hallitsee rinnakkaisuuden astetta sukupolven aikana.

Samalla sen tulisi valita tulevien tokenien osajoukko, joka on lähes toisistaan riippumaton nykyisessä tilanteessa.

Ovatko nykyiset dekoodausstrategiat hyviä tässä?

Vaikea sanoa.

Useimpia DLLM:iä ei koskaan stressitestattu sen varalta.

-----

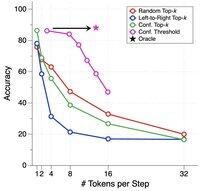

Siksi otimme käyttöön synteettisen vertailuarvon DLLM-järjestelmien stressitestaukseen.

Kutsumme sitä ParallelBenchiksi.

Idea on yksinkertainen: nämä ovat luonnollisen kielen tehtäviä, mutta huolellisesti suunniteltuja niin, että rinnakkaissukupolvi on luonnostaan vaikeaa.

(Ajattele "uutta kaupunkia", mutta luonnollisempia, todellisia tehtäviä.)

Mitä löysimme?

Testasimme suosittuja DLLM-tiedostoja erilaisilla dekoodausalgoritmeilla, eikä yksikään päässyt lähellekään "oraakkelin" suorituskykyä, ihanteellista suorituskykyä, jonka saisit, jos malli pystyisi säätämään optimaalisesti rinnakkaisuuttaan dekoodauksen aikana.

-----

Takeaway:

(1) Rinnakkaistuotanto ei ole aina mahdollista ja katso lisätietoja artikkelistamme :)

(2) Jos pystyt suunnittelemaan DLLM:n, joka vastaa oraakkelin suorituskykyä vertailuarvossamme, kuka tietää, saatat saada puhelun joltakulta Menlo Parkista. 😉

63,82K

Johtavat

Rankkaus

Suosikit