Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kangwook Lee

UW Madison / KRAFTON KI

LLM als Richter ist zu einer dominierenden Methode geworden, um zu bewerten, wie gut ein Modell eine Aufgabe löst, da es ohne einen Testdatensatz funktioniert und Fälle behandelt, in denen Antworten nicht eindeutig sind.

Aber trotz der weit verbreiteten Nutzung sind fast alle berichteten Ergebnisse stark verzerrt.

Ich freue mich, unser Preprint darüber zu teilen, wie man LLM richtig als Richter verwendet.

🧵

===

Wie verwenden die Leute LLM tatsächlich als Richter?

Die meisten Menschen verwenden das LLM einfach als Evaluator und berichten über die empirische Wahrscheinlichkeit, dass das LLM sagt, die Antwort sieht korrekt aus.

Wenn das LLM perfekt ist, funktioniert das gut und liefert einen unverzerrten Schätzer.

Wenn das LLM nicht perfekt ist, bricht das zusammen.

Betrachten Sie einen Fall, in dem das LLM 80 Prozent der Zeit korrekt bewertet.

Genauer gesagt, wenn die Antwort korrekt ist, sagt das LLM mit 80 Prozent Wahrscheinlichkeit: "Das sieht korrekt aus", und dieselben 80 Prozent gelten, wenn die Antwort tatsächlich inkorrekt ist.

In dieser Situation sollten Sie die empirische Wahrscheinlichkeit nicht berichten, da sie verzerrt ist. Warum?

Lassen Sie die wahre Wahrscheinlichkeit, dass das getestete Modell korrekt ist, p sein.

Dann ist die empirische Wahrscheinlichkeit, dass das LLM "korrekt" sagt (= q),

q = 0.8p + 0.2(1 - p) = 0.2 + 0.6p

Der unverzerrte Schätzer sollte also sein

(q - 0.2) / 0.6

Die Dinge werden noch interessanter, wenn das Fehlerverhalten asymmetrisch ist oder wenn Sie diese Fehlerquoten a priori nicht kennen.

===

Was bedeutet das?

Zuerst folgen Sie den vorgeschlagenen Richtlinien in unserem Preprint.

Es gibt kein kostenloses Mittagessen. Sie können nicht bewerten, wie gut Ihr Modell ist, es sei denn, Ihr LLM als Richter ist bekannt dafür, perfekt zu urteilen.

Je nachdem, wie nah es an einem perfekten Evaluator ist, benötigen Sie eine ausreichende Größe des Testdatensatzes (= Kalibrierungsdatensatz), um die Fehlerquoten des Evaluators zu schätzen, und dann müssen Sie diese korrigieren.

Zweitens müssen leider viele Ergebnisse, die wir in den letzten Jahren in Artikeln gesehen haben, überarbeitet werden.

Es sei denn, zwei Artikel verwendeten genau dasselbe LLM als Richter, könnten Vergleiche zwischen ihnen falsche Behauptungen hervorgebracht haben. Die Verbesserung könnte einfach aus einer leichten Änderung der Evaluierungspipeline resultieren. Eine rigorose Metastudie ist dringend erforderlich.

===

tldr:

(1) Fast alle LLM-als-Richter-Bewertungen in den letzten Jahren wurden mit einem verzerrten Schätzer berichtet.

(2) Es ist einfach zu beheben, also warten Sie auf unser vollständiges Preprint.

(3) Viele LLM-als-Richter-Ergebnisse sollten mit Vorsicht betrachtet werden.

Vollständiges Preprint kommt in ein paar Tagen, also bleiben Sie dran!

Fantastische Arbeit von meinen Studenten und Mitarbeitern.

@chungpa_lee @tomzeng200 @jongwonjeong123 und @jysohn1108

203,82K

Ein ernsthafterer Thread über den DeepSeek-OCR-Hype / ernsthafte Fehlinterpretationen, die im Gange sind.

1.

Bei der Token-Reduktion durch die Darstellung von Text in Bildern haben Forscher aus Cambridge zuvor gezeigt, dass eine 500-fache Kompression der Prompt-Token möglich ist (ACL'25, Li, Su und Collier).

Ohne die Idee zu verwenden, Text in Bilder umzuwandeln.

2.

Wir sollten den Erfolg von DeepSeek OCR nicht der Kraft der Bilddarstellung zuschreiben.

Gleichzeitig ist nichts grundsätzlich falsch mit der Textdarstellung mit welchem Tokenizer auch immer.

Tatsächlich kann man das Gegenteil von dem tun, was DeepSeek-OCR gemacht hat, d.h. man kann Bilder als eine Sequenz von Text-Token darstellen (jeder repräsentiert seine RGB-Werte), und es wird einfach gut funktionieren. (Siehe das LIFT-Papier.)

3.

Die einzige richtige Erkenntnis ist, dass die aktuellen Einbettungsräume, die von LLMs verwendet werden, einfach riesig und vielleicht sogar sehr verschwenderisch sind.

Und wichtig ist, dass wir sie noch nicht vollständig nutzen.

4.

Es gibt viele aktuelle Beweise, die dieselbe Botschaft unterstützen.

Zum Beispiel wird gezeigt, dass, wenn Sie kontextuelle Demonstrationen aus mehreren Aufgaben bereitstellen, aber in einem einzigen Kontext gemischt, Ihr Modell mehrere ICL-Vorhersageaufgaben gleichzeitig lösen kann. (Siehe das EVERYTHING EVERYWHERE ALL AT ONCE-Papier.)

5.

tldr;

- DeepSeek-OCR ist cool

- aber Sie können eine höhere Token-Reduktionsrate erreichen, indem Sie einfach LLMs auf komprimierte Text-Token feinabstimmen

- es gibt mehr Beweise dafür, dass LLMs den großen Einbettungsraum und die enorme Rechenleistung, die zur Inferenzzeit benötigt wird, nicht vollständig nutzen

- und das ist die einzige echte Erkenntnis, die Sie mitnehmen sollten.

85,99K

DLLMs scheinen vielversprechend zu sein... aber parallele Generierung ist nicht immer möglich

Diffusionsbasierte LLMs können viele Tokens an verschiedenen Positionen gleichzeitig generieren, während die meisten autoregressiven LLMs Tokens nacheinander generieren.

Das macht diffusionsbasierte LLMs sehr attraktiv, wenn wir eine schnelle Generierung mit weniger Rechenaufwand benötigen.

Eine große Frage ist … ist parallele Generierung möglich, ohne die Modellierungsgenauigkeit zu verlieren?

Die Antwort ist nein. Es gibt grundlegende Grenzen dafür, wie viel Parallelität wir erreichen können.

Betrachten Sie dieses Beispiel:

„Wählen Sie eine Stadt gleichmäßig zufällig aus den folgenden vier Städten:

New York, New Orleans, Mexiko-Stadt oder Panama-Stadt.“

Dann,

P(Y₁ = New, Y₂ = York) = 1/4,

P(Y₁ = New, Y₂ = Orleans) = 1/4, und so weiter.

Daher ist P(Y₁ = New) = 1/2, P(Y₂ = City) = 1/2.

Wenn Sie sich entscheiden, Y₁ und Y₂ parallel zu generieren, egal welchen Decodierungsalgorithmus Sie verwenden …

Sie sind dazu verurteilt, „New City“ zu sampeln.

Keines der heutigen DLLMs kann diese beiden Wörter korrekt generieren, ohne die Parallelität aufzugeben.

-----

Warum ist das so?

Tatsächlich trainieren wir LLMs nie, um die gemeinsame Verteilung über mehrere Tokens in einer Vorwärtsiteration zu lernen.

Wir lehren immer eine marginale Verteilung für ein einzelnes Token, die vom Kontext abhängt.

(Das gilt auch für autoregressive Modelle.)

Daher ist das Sampling mehrerer Tokens auf einmal nur möglich, wenn diese Tokens gegebenenfalls unabhängig sind, basierend auf dem aktuellen Kontext.

Und diese Einschränkung des parallelen Samplings kann präzise formalisiert werden.

Man kann eine informationstheoretische Grenze ableiten, die decodierungsstrategieunabhängig ist, und auch strategiespezifische Grenzen ableiten.

-----

Sind DLLMs also zum Scheitern verurteilt? Nein!

Sie haben ein enormes Potenzial, Rechenaufwand und Zeit zu sparen.

Aber:

(1) wir müssen uns ihrer grundlegenden Einschränkungen bewusst sein, und

(2) wir müssen bessere Trainings- und Decodierungsstrategien entwerfen.

Insbesondere gibt es großen Spielraum für Verbesserungen bei der Decodierung.

Warum?

Idealerweise möchten wir, dass das Modell den Grad der Parallelität während der Generierung steuert.

Gleichzeitig sollte es eine Teilmenge zukünftiger Tokens auswählen, die fast gegenseitig unabhängig sind, basierend auf dem aktuellen Kontext.

Sind die aktuellen Decodierungsstrategien gut darin?

Schwer zu sagen.

Die meisten DLLMs wurden dafür nie auf die Probe gestellt.

-----

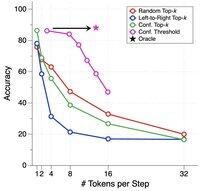

Deshalb haben wir einen synthetischen Benchmark eingeführt, um DLLMs auf die Probe zu stellen.

Wir nennen es ParallelBench.

Die Idee ist einfach: Dies sind Aufgaben in natürlicher Sprache, aber sorgfältig so gestaltet, dass parallele Generierung von Natur aus schwierig ist.

(Denken Sie an „New City“, aber an natürlichere, reale Aufgaben.)

Was haben wir herausgefunden?

Wir haben beliebte DLLMs mit verschiedenen Decodierungsalgorithmen getestet, und keiner kam der „Oracle“-Leistung nahe, der idealen Leistung, die Sie erhalten würden, wenn das Modell seine Parallelität während der Decodierung optimal anpassen könnte.

-----

Fazit:

(1) Parallele Generierung ist nicht immer möglich, und schauen Sie sich unser Papier für weitere Details an :)

(2) Wenn Sie ein DLLM entwerfen können, das die Oracle-Leistung in unserem Benchmark erreicht, nun, wer weiß, vielleicht erhalten Sie einen Anruf von jemandem in Menlo Park. 😉

63,8K

Top

Ranking

Favoriten