Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GPT-OSS використовує квантування MXFP4 (яке тепер підтримує MLX).

Зараз циркулюють два формати FP4: MXFP4 і NVFP4 (NV для Nvidia).

Судячи з того, як GPT-OSS використовує MXFP4, це дещо неоптимально. Я думаю, що NVFP4 буде більш часто використовуваним форматом у майбутньому.

Детальніше нижче:

Обидва формати кількісно квантують ваги до 4-бітної плаваючої коми (e2 m1) з унікальною шкалою для кожної групи.

Різниця полягає в розмірі групи та способі кодування шкали для кожної групи.

- MXFP4 використовує шкалу e8m0 (з фіксованою точкою, 8 біт) з розміром групи 32. Його підвищують до степеня 2 перед множенням ваги.

- NVFP4 використовує шкалу e4m3 (fp8) з розміром групи 16. Вона множиться безпосередньо на вагу

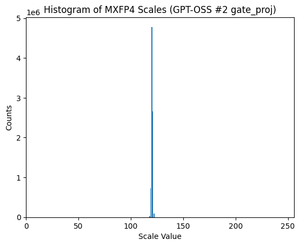

Кодування шкали в MXFP4 досить неоптимальне, оскільки воно не має представлень для багатьох значень у потрібному нам діапазоні.

Насправді, якщо подивитися на розподіл шкал для GPT-OSS, то він надзвичайно сконцентрований навколо всього пари значень. Наприклад, для другого шару MoE я дивлюся лише на 8/256 можливих значень. (Див. Сюжет).

17,42K

Найкращі

Рейтинг

Вибране