トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

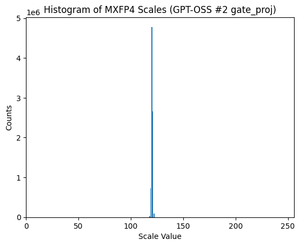

GPT-OSS は MXFP4 量子化を使用します (MLX は現在サポートしています)。

現在流通しているFP4フォーマットは、MXFP4とNVFP4(Nvidiaの場合はNV)の2つです。

GPT-OSS が MXFP4 をどのように使用しているかを見ると、やや最適とは言えません。将来的にはNVFP4がより一般的に使用される形式になると思います。

詳細は以下をご覧ください。

どちらの形式も、グループごとに一意のスケールで重みを 4 ビット浮動小数点 (e2 m1) に量子化します。

違いは、グループのサイズと、各グループのスケールのエンコード方法です。

- MXFP4 は、グループ サイズが 32 の e8m0 スケール (固定小数点、8 ビット) を使用します。重みを掛ける前に2乗に上げる。

- NVFP4 は、グループ サイズが 16 の e4m3 (fp8) スケールを使用します。重みに直接掛けられます

MXFP4のスケールエンコーディングは、必要な範囲内の多くの値の表現がないため、かなり最適ではありません。

実際、GPT-OSSのスケールの分布を見ると、わずか数個の値に非常に集中しています。たとえば、私が見ている2番目のMoEレイヤーでは、8/256の可能な値しか使用されていません。(プロットを参照)。

17.34K

トップ

ランキング

お気に入り