Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GPT-OSS menggunakan kuantisasi MXFP4 (yang sekarang didukung MLX).

Ada dua format FP4 yang beredar saat ini: MXFP4 dan NVFP4 (NV untuk Nvidia).

Dari melihat bagaimana GPT-OSS menggunakan MXFP4, itu agak tidak optimal. Saya pikir NVFP4 akan menjadi format yang lebih umum digunakan di masa depan.

Detail lebih lanjut di bawah ini:

Kedua format mengkuantisasi bobot ke floating point 4-bit (e2 m1) dengan skala unik per grup.

Perbedaannya adalah ukuran grup dan bagaimana skala untuk setiap grup dikodekan.

- MXFP4 menggunakan skala e8m0 (titik tetap, 8-bit) dengan ukuran grup 32. Itu dinaikkan menjadi pangkat 2 sebelum mengalikan bobot.

- NVFP4 menggunakan skala e4m3 (fp8) dengan ukuran grup 16. Itu dikalikan dengan berat secara langsung

Pengkodean skala di MXFP4 cukup suboptimal karena tidak memiliki representasi untuk banyak nilai dalam rentang yang kita butuhkan.

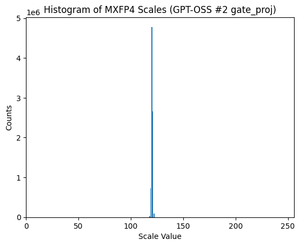

Faktanya, jika Anda melihat distribusi skala untuk GPT-OSS, itu sangat terkonsentrasi hanya di sekitar beberapa nilai. Misalnya, untuk lapisan MoE kedua saya melihat hanya 8/256 nilai yang mungkin bahkan digunakan. (Lihat plot).

17,32K

Teratas

Peringkat

Favorit