Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GPT-OSS používá kvantizaci MXFP4 (kterou MLX nyní podporuje).

V současné době jsou v oběhu dva formáty FP4: MXFP4 a NVFP4 (NV pro Nvidii).

Z pohledu na to, jak GPT-OSS využívá MXFP4, je poněkud suboptimální. Myslím, že NVFP4 bude v budoucnu běžněji používaným formátem.

Více podrobností níže:

Oba formáty kvantifikují váhy na 4bitovou plovoucí desetinnou čárku (e2 m1) s jedinečným měřítkem pro každou skupinu.

Rozdíl je ve velikosti skupiny a v tom, jak je zakódováno měřítko pro každou skupinu.

- MXFP4 používá stupnici e8m0 (s pevnou řádovou čárkou, 8 bitů) s velikostí skupiny 32. Zvýší se na mocninu 2 před vynásobením váhy.

- NVFP4 používá stupnici e4m3 (fp8) s velikostí skupiny 16. Násobí se přímo hmotností

Kódování měřítka v MXFP4 není optimální, protože nemá reprezentace pro mnoho hodnot v rozsahu, který potřebujeme.

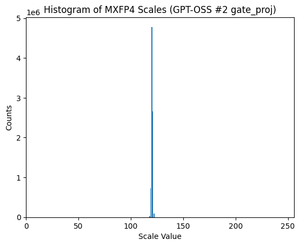

Ve skutečnosti, pokud se podíváte na rozložení stupnic pro GPT-OSS, je extrémně soustředěno jen kolem několika hodnot. Například u druhé vrstvy MoE se dívám jen na 8/256 možných hodnot, které jsou dokonce použity. (Viz zápletka).

17,46K

Top

Hodnocení

Oblíbené