Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Технологічні гіганти щодня використовують Multimodal RAG у виробництві!

- Spotify використовує його для відповідей на музичні запити

- YouTube використовує його, щоб перетворювати підказки на треки

- Amazon Music використовує його для створення списку відтворення з prompt

Давайте дізнаємося, як побудувати мультимодальний агентський RAG (з кодом):

Сьогодні ми створимо мультимодальний Agentic RAG, який може запитувати документи та аудіофайли за допомогою мови користувача.

Технологічний стек:

- @AssemblyAI для транскрипції.

- @milvusio як векторна БД.

- @beam_cloud для розгортання.

- @crewAIInc Потоки для оркестровки.

Давайте його побудуємо!

Ось робочий процес:

- Введені користувачем дані (аудіо + документація).

- AssemblyAI транскрибує аудіофайли.

- Транскрибований текст і документи вбудовуються в векторну базу даних Milvus.

- Research Agent отримує інформацію з запиту користувача.

- Агент реагування використовує його для створення відповіді.

Перевірте це👇

1️⃣ Прийом даних всередину

Для початку користувач надає текстові та аудіо вхідні дані в каталозі даних.

CrewAI Flow реалізує логіку для виявлення файлів і підготовки їх до подальшої обробки.

Перевірте це👇

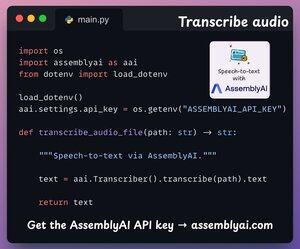

2️⃣ Транскрибування аудіо

Далі ми транскрибуємо аудіовхід користувача за допомогою платформи Speech-to-text від AssemblyAI.

AssemblyAI не має відкритого вихідного коду, але він надає достатньо безкоштовних кредитів для використання своїх моделей транскрипції SOTA, яких більш ніж достатньо для цієї демонстрації.

Перевірте це👇

3️⃣ Вбудовування вхідних даних

Рухаючись далі, транскрибовані вхідні дані з вищезазначеного кроку та вхідні текстові дані вбудовуються та зберігаються у векторній базі даних Milvus.

Ось як ми це 👇 робимо

4️⃣ Запит користувача

Прийом всередину закінчено.

Тепер ми переходимо до фази умовиводу!

Далі користувач вводить голосовий запит, який транскрибується AssemblyAI.

Перевірте це👇

5️⃣ Отримання контексту

Далі ми генеруємо вкладення для запиту та витягуємо найбільш релевантні фрагменти з векторної БД Milvus.

Ось як ми це 👇 робимо

6️⃣ Згенерувати відповідь

Як тільки ми отримуємо відповідний контекст, наш екіпаж викликається для створення чіткої та цитованої відповіді для користувача.

Перевірте це 👇

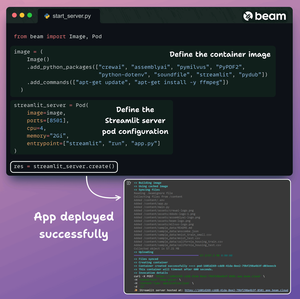

Нарешті, ми загортаємо все в чистий інтерфейс Streamlit і розгортаємо додаток у безсерверному контейнері за допомогою Beam.

Ми імпортуємо необхідні залежності Python і вказуємо обчислювальні специфікації для контейнера.

А потім ми розгортаємо додаток у кілька рядків коду👇

Після розгортання ми отримуємо 100% приватне розгортання для щойно створеного нами робочого процесу Multimodal RAG Agentic.

Перегляньте цю демонстрацію 👇

Ось який робочий процес ми впровадили:

- Дані надані користувачем (аудіо + документація)

- AssemblyAI транскрибував аудіофайли

- Транскрибовані дані вбудовуються у векторну БД

- Research Agent отримав інформацію за запитом користувача

- Агент реагування використовував його для створення відповіді

Перевірте це👇

Якщо ви вважаєте її корисною, надішліть запит у свою мережу.

Знайди мене → @akshay_pachaar ✔️

Щоб отримати більше інформації та навчальних посібників про LLM, агентів штучного інтелекту та машинне навчання!

5 серп., 20:30

Технологічні гіганти щодня використовують Multimodal RAG у виробництві!

- Spotify використовує його для відповідей на музичні запити

- YouTube використовує його, щоб перетворювати підказки на треки

- Amazon Music використовує його для створення списку відтворення з prompt

Давайте дізнаємося, як побудувати мультимодальний агентський RAG (з кодом):

106,51K

Найкращі

Рейтинг

Вибране