トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

テクノロジー大手は、本番環境で毎日マルチモーダル RAG を使用しています。

- Spotify はこれを使用して音楽のクエリに答えます

- YouTube はこれを使用してプロンプトをトラックに変換します

- Amazon Musicはこれを使用してプロンプトからプレイリストを作成します

マルチモーダル エージェント RAG の構築方法を (コード付き) 学びましょう。

今日は、ユーザーの音声を使用してドキュメントと音声ファイルをクエリできるマルチモーダルな Agentic RAG を構築します。

技術スタック:

- 文字起こしの@AssemblyAI。

- ベクトルDBとして@milvusioします。

- 展開の@beam_cloud。

- @crewAIInc オーケストレーション用のフロー。

構築しましょう!

ワークフローは次のとおりです。

- ユーザーがデータを入力する(音声+ドキュメント)。

- AssemblyAI は音声ファイルを文字起こしします。

- 文字起こしされたテキストとドキュメントは、Milvus ベクター DB に埋め込まれています。

- リサーチエージェントは、ユーザークエリから情報を取得します。

- Response Agent はこれを使用して応答を作成します。

これを👇チェックしてください

1️⃣ データ取り込み

まず、ユーザーはデータディレクトリにテキストと音声の入力データを提供します。

CrewAI Flowは、ファイルを検出し、さらなる処理の準備を整えるロジックを実装します。

これを👇チェックしてください

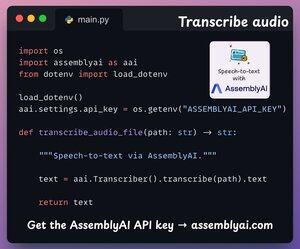

2️⃣ 音声を文字起こしする

次に、AssemblyAI の音声テキスト変換プラットフォームを使用して、ユーザーの音声入力を文字起こしします。

AssemblyAI はオープンソースではありませんが、SOTA 文字起こしモデルを使用するための十分な無料クレジットが提供されており、このデモには十分すぎるほどです。

これを👇チェックしてください

3️⃣ 入力データを埋め込む

次に、上記のステップで文字起こしされた入力データと入力テキストデータをMilvusベクトルDBに埋め込んで格納します。

その方法👇は次のとおりです

4️⃣ ユーザークエリ

取り込みは終了しました。

次に、推論フェーズに移ります。

次に、ユーザーが音声クエリを入力すると、AssemblyAI によって文字起こしされます。

これを👇チェックしてください

5️⃣ コンテキストの取得

次に、クエリの埋め込みを生成し、Milvus ベクトル DB から最も関連性の高いチャンクをプルします。

これが私たちのやり👇方です

6️⃣ 回答を生成する

関連するコンテキストを取得すると、Crew が呼び出され、ユーザーに対して明確で引用された応答が生成されます。

これを👇チェックしてください

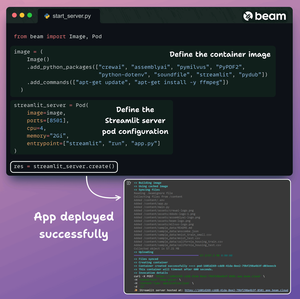

最後に、すべてをクリーンなStreamlitインターフェースにまとめ、Beamを使ってサーバーレスコンテナにアプリをデプロイします。

必要な Python の依存関係をインポートし、コンテナのコンピューティング仕様を指定します。

次に、数行のコード👇でアプリをデプロイします

デプロイされると、ビルドしたばかりのマルチモーダル RAG エージェント ワークフローの 100% プライベート デプロイが得られます。

このデモ👇をチェック

実装したワークフローは次のとおりです。

- ユーザーが提供したデータ(音声+ドキュメント)

- AssemblyAI が音声ファイルを文字起こししました

- 文字起こしされたデータはベクトルDBに埋め込まれる

- リサーチエージェントがユーザークエリから情報を取得

- Response Agent はそれを使用して応答を作成しました

これを👇チェックしてください

洞察力に富んだものを見つけた場合は、ネットワークと再共有してください。

お探し→ @akshay_pachaar ✔️

LLM、AIエージェント、機械学習に関するその他の洞察とチュートリアルについては、こちらをご覧ください。

8月5日 20:30

テクノロジー大手は、本番環境で毎日マルチモーダル RAG を使用しています。

- Spotify はこれを使用して音楽のクエリに答えます

- YouTube はこれを使用してプロンプトをトラックに変換します

- Amazon Musicはこれを使用してプロンプトからプレイリストを作成します

マルチモーダル エージェント RAG の構築方法を (コード付き) 学びましょう。

106.5K

トップ

ランキング

お気に入り