Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Technologiegiganten nutzen jeden Tag Multimodal RAG in der Produktion!

- Spotify nutzt es, um Musikfragen zu beantworten

- YouTube nutzt es, um Eingaben in Tracks umzuwandeln

- Amazon Music nutzt es, um Playlists aus Eingaben zu erstellen

Lass uns lernen, wie man einen Multimodal Agentic RAG (mit Code) aufbaut:

Heute werden wir einen multimodalen Agentic RAG erstellen, der Dokumente und Audiodateien mithilfe der Sprache des Benutzers abfragen kann.

Technologiestack:

- @AssemblyAI für die Transkription.

- @milvusio als die Vektor-Datenbank.

- @beam_cloud für die Bereitstellung.

- @crewAIInc Flows für die Orchestrierung.

Lass uns anfangen!

Hier ist der Arbeitsablauf:

- Der Benutzer gibt Daten ein (Audio + Dokumente).

- AssemblyAI transkribiert die Audiodateien.

- Der transkribierte Text und die Dokumente werden in der Milvus-Vektor-Datenbank eingebettet.

- Der Forschungsagent ruft Informationen aus der Benutzeranfrage ab.

- Der Antwortagent verwendet diese Informationen, um eine Antwort zu formulieren.

Überprüfen Sie das👇

1️⃣ Datenaufnahme

Zunächst stellt der Benutzer die Text- und Audioeingabedaten im Datenverzeichnis bereit.

CrewAI Flow implementiert die Logik, um die Dateien zu entdecken und sie für die weitere Verarbeitung vorzubereiten.

Überprüfen Sie dies👇

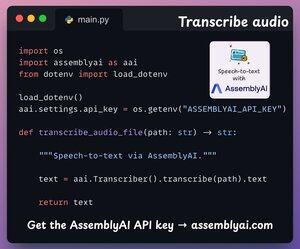

2️⃣ Transkribiere Audio

Als Nächstes transkribieren wir die Audioeingabe des Benutzers mit der Speech-to-Text-Plattform von AssemblyAI.

AssemblyAI ist nicht Open Source, bietet jedoch ausreichend kostenlose Credits, um ihre SOTA-Transkriptionsmodelle zu nutzen, die für dieses Demo mehr als ausreichend sind.

Siehe das👇

3️⃣ Eingabedaten einbetten

Als Nächstes werden die transkribierten Eingabedaten aus dem obigen Schritt und die Eingabetextdaten eingebettet und im Milvus-Vektor-DB gespeichert.

So machen wir das 👇

4️⃣ Benutzeranfrage

Die Eingabe ist abgeschlossen.

Jetzt gehen wir zur Inferenzphase über!

Als Nächstes gibt der Benutzer eine Sprachabfrage ein, die von AssemblyAI transkribiert wird.

Überprüfen Sie dies👇

5️⃣ Kontext abrufen

Als Nächstes generieren wir ein Embedding für die Abfrage und ziehen die relevantesten Teile aus der Milvus-Vektor-Datenbank.

So machen wir das 👇

6️⃣ Eine Antwort generieren

Sobald wir den relevanten Kontext haben, wird unser Team aufgerufen, um eine klare und zitierte Antwort für den Benutzer zu generieren.

Überprüfen Sie dies 👇

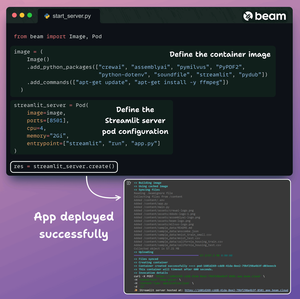

Schließlich fassen wir alles in einer sauberen Streamlit-Oberfläche zusammen und setzen die App in einem serverlosen Container mit Beam ein.

Wir importieren die notwendigen Python-Abhängigkeiten und geben die Rechenanforderungen für den Container an.

Und dann setzen wir die App in ein paar Codezeilen ein👇

Sobald bereitgestellt, erhalten wir eine 100% private Bereitstellung für den Multimodal RAG Agentic Workflow, den wir gerade erstellt haben.

Überprüfen Sie diese Demo 👇

Hier ist der Workflow, den wir implementiert haben:

- Benutzer gab Daten (Audio + Dokumente) an

- AssemblyAI hat die Audiodateien transkribiert

- Die transkribierten Daten sind in der Vektor-DB eingebettet

- Der Forschungsagent hat Informationen aus der Benutzeranfrage abgerufen

- Der Antwortagent hat diese verwendet, um eine Antwort zu formulieren

Überprüfe das👇

Wenn Sie es aufschlussreich fanden, teilen Sie es erneut mit Ihrem Netzwerk.

Finde mich → @akshay_pachaar ✔️

Für weitere Einblicke und Tutorials zu LLMs, KI-Agenten und maschinellem Lernen!

5. Aug., 20:30

Technologiegiganten nutzen jeden Tag Multimodal RAG in der Produktion!

- Spotify nutzt es, um Musikfragen zu beantworten

- YouTube nutzt es, um Eingaben in Tracks umzuwandeln

- Amazon Music nutzt es, um Playlists aus Eingaben zu erstellen

Lass uns lernen, wie man einen Multimodal Agentic RAG (mit Code) aufbaut:

106,57K

Top

Ranking

Favoriten