Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Teknologigiganter bruker Multimodal RAG hver dag i produksjonen!

- Spotify bruker den til å svare på musikkspørsmål

- YouTube bruker den til å gjøre forespørsler om til spor

- Amazon Music bruker den til å lage spilleliste fra ledeteksten

La oss lære hvordan du bygger en Multimodal Agentic RAG (med kode):

I dag skal vi bygge en multimodal Agentic RAG som kan spørre etter dokumenter og lydfiler ved hjelp av brukerens tale.

Teknisk stabel:

- @AssemblyAI for transkripsjon.

- @milvusio som vektoren DB.

- @beam_cloud for distribusjon.

- @crewAIInc Flyter for orkestrering.

La oss bygge det!

Her er arbeidsflyten:

- Bruker legger inn data (lyd + dokumenter).

- AssemblyAI transkriberer lydfilene.

- Transkribert tekst og dokumenter er innebygd i Milvus-vektoren DB.

- Research Agent henter informasjon fra brukerspørring.

- Response Agent bruker den til å lage et svar.

Sjekk dette👇

1️⃣ Datainntak

Til å begynne med oppgir brukeren tekst- og lydinndatadataene i datakatalogen.

CrewAI Flow implementerer logikken for å oppdage filene og gjøre dem klare for videre behandling.

Sjekk dette👇

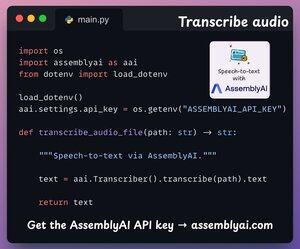

2️⃣ Transkriber lyd

Deretter transkriberer vi brukerens lydinngang ved hjelp av AssemblyAIs tale-til-tekst-plattform.

AssemblyAI er ikke åpen kildekode, men det gir rikelig med gratis kreditter for å bruke deres SOTA-transkripsjonsmodeller, som er mer enn tilstrekkelig for denne demoen.

Sjekk dette👇

3️⃣ Bygg inn inndata

Når vi går videre, blir de transkriberte inngangsdataene fra trinnet ovenfor og inndatatekstdataene innebygd og lagret i Milvus vektor DB.

Slik gjør vi det 👇

4️⃣ Brukerens forespørsel

Svelging er over.

Nå går vi til slutningsfasen!

Deretter legger brukeren inn en talespørring, som transkriberes av AssemblyAI.

Sjekk dette👇

5️⃣ Hent kontekst

Deretter genererer vi en innebygging for spørringen og henter de mest relevante bitene fra Milvus-vektordatabasen.

Slik gjør vi det 👇

6️⃣ Generer et svar

Når vi har den relevante konteksten, påkalles mannskapet vårt for å generere et klart og sitert svar for brukeren.

Sjekk dette 👇

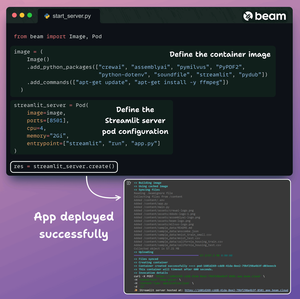

Til slutt pakker vi alt inn i et rent Streamlit-grensesnitt og distribuerer appen til en serverløs beholder ved hjelp av Beam.

Vi importerer de nødvendige Python-avhengighetene og spesifiserer databehandlingsspesifikasjonene for beholderen.

Og så distribuerer vi appen i noen få linjer med kode👇

Når den er distribuert, får vi en 100 % privat distribusjon for den multimodale RAG Agentic-arbeidsflyten som vi nettopp har bygget.

Sjekk denne demoen 👇

Her er arbeidsflyten vi implementerte:

- Bruker ga data (lyd + dokumenter)

- AssemblyAI transkriberte lydfilene

- Transkriberte data er innebygd i vektor DB

- Forskningsagent hentet informasjon fra brukerspørring

- Responsagenten brukte den til å lage et svar

Sjekk dette👇

Hvis du syntes det var innsiktsfullt, kan du dele det med nettverket ditt.

Finn meg → @akshay_pachaar ✔️

For mer innsikt og opplæringer om LLM-er, AI-agenter og maskinlæring!

5. aug., 20:30

Teknologigiganter bruker Multimodal RAG hver dag i produksjonen!

- Spotify bruker den til å svare på musikkspørsmål

- YouTube bruker den til å gjøre forespørsler om til spor

- Amazon Music bruker den til å lage spilleliste fra ledeteksten

La oss lære hvordan du bygger en Multimodal Agentic RAG (med kode):

102,71K

Topp

Rangering

Favoritter