Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

I giganti della tecnologia utilizzano il Multimodal RAG ogni giorno in produzione!

- Spotify lo utilizza per rispondere a domande sulla musica

- YouTube lo utilizza per trasformare i prompt in tracce

- Amazon Music lo utilizza per creare playlist a partire da un prompt

Impariamo a costruire un Multimodal Agentic RAG (con codice):

Oggi costruiremo un RAG Agentic multimodale che può interrogare documenti e file audio utilizzando il discorso dell'utente.

Stack tecnologico:

- @AssemblyAI per la trascrizione.

- @milvusio come DB vettoriale.

- @beam_cloud per il deployment.

- @crewAIInc Flows per l'orchestrazione.

Costruiamolo!

Ecco il flusso di lavoro:

- L'utente inserisce i dati (audio + documenti).

- AssemblyAI trascrive i file audio.

- Il testo trascritto e i documenti vengono incorporati nel database vettoriale Milvus.

- L'Agente di Ricerca recupera informazioni dalla query dell'utente.

- L'Agente di Risposta lo utilizza per formulare una risposta.

Controlla questo👇

1️⃣ Acquisizione dei Dati

Per iniziare, l'utente fornisce i dati di input testuali e audio nella directory dei dati.

CrewAI Flow implementa la logica per scoprire i file e prepararli per ulteriori elaborazioni.

Controlla questo👇

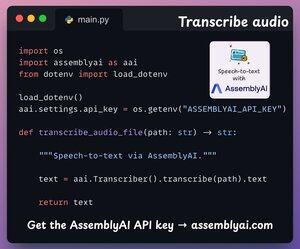

2️⃣ Trascrivi audio

Successivamente, trascriviamo l'input audio dell'utente utilizzando la piattaforma di riconoscimento vocale di AssemblyAI.

AssemblyAI non è open source, ma offre ampi crediti gratuiti per utilizzare i loro modelli di trascrizione SOTA, che sono più che sufficienti per questa demo.

Controlla questo👇

3️⃣ Incorpora i dati di input

Procedendo, i dati di input trascritti dal passaggio precedente e i dati di testo di input vengono incorporati e memorizzati nel database vettoriale Milvus.

Ecco come lo facciamo 👇

4️⃣ Richiesta dell'utente

L'ingestione è completata.

Ora passiamo alla fase di inferenza!

Successivamente, l'utente inserisce una richiesta vocale, che viene trascritta da AssemblyAI.

Controlla questo👇

5️⃣ Recupera il contesto

Successivamente, generiamo un embedding per la query e estraiamo i chunk più rilevanti dal database vettoriale Milvus.

Ecco come lo facciamo 👇

6️⃣ Genera una risposta

Una volta che abbiamo il contesto rilevante, il nostro Team viene convocato per generare una risposta chiara e citata per l'utente.

Controlla questo 👇

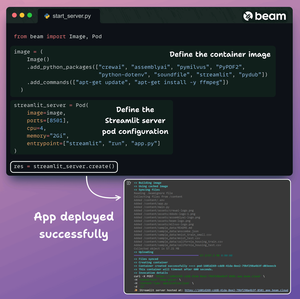

Infine, raggruppiamo tutto in un'interfaccia Streamlit pulita e distribuiamo l'app in un contenitore serverless utilizzando Beam.

Importiamo le dipendenze Python necessarie e specifichiamo le specifiche di calcolo per il contenitore.

E poi distribuiamo l'app in poche righe di codice👇

Una volta implementato, otteniamo un'implementazione 100% privata per il flusso di lavoro Multimodal RAG Agentic che abbiamo appena costruito.

Guarda questa demo 👇

Ecco il flusso di lavoro che abbiamo implementato:

- L'utente ha fornito dati (audio + documenti)

- AssemblyAI ha trascritto i file audio

- I dati trascritti sono stati incorporati nel database vettoriale

- L'agente di ricerca ha recuperato informazioni dalla query dell'utente

- L'agente di risposta le ha utilizzate per formulare una risposta

Controlla questo👇

Se l'hai trovato interessante, condividilo nuovamente con la tua rete.

Trovami → @akshay_pachaar ✔️

Per ulteriori approfondimenti e tutorial su LLM, agenti di intelligenza artificiale e apprendimento automatico!

5 ago, 20:30

I giganti della tecnologia utilizzano il Multimodal RAG ogni giorno in produzione!

- Spotify lo utilizza per rispondere a domande sulla musica

- YouTube lo utilizza per trasformare i prompt in tracce

- Amazon Music lo utilizza per creare playlist a partire da un prompt

Impariamo a costruire un Multimodal Agentic RAG (con codice):

106,5K

Principali

Ranking

Preferiti