Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeffrey Emanuel

Неокогнітрон був значно попереду свого часу. Фукусіма не отримує достатньо визнання. Чудове ім'я теж.

Сподіваюся, він хоча б відомий у Японії.

Jürgen Schmidhuber2 груд., 23:20

Відео Фукусіми (1986) показує CNN, який розпізнає рукописні цифри [3], за три роки до відео ЛеКуна (1989).

Хронологія CNN взята з [5]:

★ 1969: Куніхіко Фукусіма опублікував ректифіковані лінійні одиниці або ReLU [1], які нині широко використовуються в CNN.

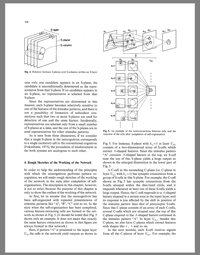

★ 1979: Фукусіма опублікувала базову архітектуру CNN з шарами згортки та шарами зменшення дискретизації [2]. Він назвав це неокогнітроном. Вона тренувалася за правилами навчання без нагляду. Обчислення були в 100 разів дорожчими, ніж у 1989 році, і в мільярд разів дорожчими, ніж сьогодні.

★ 1986: відео Фукусіми про розпізнавання рукописних цифр [3].

★ 1988: Вей Чжан та співавт. провели перший «сучасний» двовимірний CNN, навчений за допомогою зворотного поширення, а також застосували його до розпізнавання символів [4]. Обчислення були приблизно в 10 мільйонів разів дорожчими, ніж сьогодні.

★ 1989-: пізніші роботи інших [5].

ДЖЕРЕЛА (детальніше у [5])

[1] К. Фукусіма (1969). Візуальне вилучення ознак багатошаровою мережею аналогових порогових елементів. IEEE Transactions on Systems Science and Cybernetics. 5 (4): 322-333. Ця робота запровадила ректифіковані лінійні одиниці або ReLU, які нині широко використовуються в CNN та інших нейронних мережах.

[2] К. Фукусіма (1979). Модель нейронної мережі для механізму розпізнавання шаблонів, не зачепленого зміною положення — Неокогнітрон. Транс. IECE, т. J62-A, No 10, с. 658-665, 1979. Перша глибока згорткова нейронна мережа архітектура з чергуванням згорткових шарів і шарами зменшення дискретизації. Японською. Англійська версія: 1980.

[3] Фільм, створений К. Фукусімою, С. Міяке та Т. Іто (NHK Науково-технічні дослідницькі лабораторії) у 1986 році. YouTube:

[4] В. Чжан, Дж. Таніда, К. Іто, Й. Ічіока. Нейронна мережа з розпізнаванням шаблонів і її оптична архітектура. Щорічна конференція Японського товариства прикладної фізики, 1988. Перший «сучасний» двовимірний CNN, навчений зворотній поширенням, застосований до розпізнавання символів.

[5] Й. Шмідхубер (AI Blog, 2025). Хто винайшов згорткові нейронні мережі?

10,86K

Найкращі

Рейтинг

Вибране