Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeffrey Emanuel

L'équipe de gemini-cli doit vraiment maîtriser ces modes de défaillance catastrophiques des boucles de harnais d'agent. Ils se produisent constamment.

J'apprécie à quel point ils l'ont rapidement amélioré, passant de inutile à pas mal, mais Claude Code et Codex n'ont tout simplement pas ces problèmes.

5,28K

Wow, on peut vraiment voir clairement quand j'ai créé MCP Agent Mail et que j'ai soudainement eu la capacité d'exploiter de manière productive beaucoup plus d'agents de codage à la fois (ainsi que tous mes autres nouveaux outils qui ont permis ces nouveaux flux de travail).

Je n'ai sorti qu'une petite fraction de ce que j'ai construit !

7,92K

Le Neocognitron était tellement en avance sur son temps. Fukushima n'a pas assez de reconnaissance. Super nom, aussi.

J'espère qu'il est au moins célèbre au Japon.

Jürgen Schmidhuber2 déc., 23:20

La vidéo de Fukushima (1986) montre un CNN qui reconnaît les chiffres manuscrits [3], trois ans avant la vidéo de LeCun (1989).

Chronologie des CNN tirée de [5] :

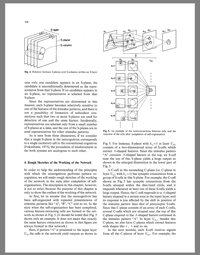

★ 1969 : Kunihiko Fukushima a publié des unités linéaires rectifiées ou ReLUs [1] qui sont maintenant largement utilisées dans les CNN.

★ 1979 : Fukushima a publié l'architecture de base des CNN avec des couches de convolution et des couches de sous-échantillonnage [2]. Il l'a appelée neocognitron. Elle a été entraînée par des règles d'apprentissage non supervisé. Le calcul coûtait 100 fois plus cher qu'en 1989, et un milliard de fois plus cher qu'aujourd'hui.

★ 1986 : La vidéo de Fukushima sur la reconnaissance des chiffres manuscrits [3].

★ 1988 : Wei Zhang et al. ont eu le premier CNN 2D "moderne" entraîné par rétropropagation, et l'ont également appliqué à la reconnaissance de caractères [4]. Le calcul coûtait environ 10 millions de fois plus cher qu'aujourd'hui.

★ 1989- : travaux ultérieurs par d'autres [5].

RÉFÉRENCES (plus dans [5])

[1] K. Fukushima (1969). Extraction de caractéristiques visuelles par un réseau multicouche d'éléments seuils analogiques. IEEE Transactions on Systems Science and Cybernetics. 5 (4) : 322-333. Ce travail a introduit les unités linéaires rectifiées ou ReLUs, maintenant largement utilisées dans les CNN et d'autres réseaux neuronaux.

[2] K. Fukushima (1979). Modèle de réseau neuronal pour un mécanisme de reconnaissance de motifs non affecté par un déplacement de position—Neocognitron. Trans. IECE, vol. J62-A, no. 10, pp. 658-665, 1979. La première architecture de réseau neuronal convolutif profond, avec des couches de convolution alternées et des couches de sous-échantillonnage. En japonais. Version anglaise : 1980.

[3] Film produit par K. Fukushima, S. Miyake et T. Ito (Laboratoires de recherche scientifique et technique NHK), en 1986. YouTube :

[4] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka. Réseau neuronal de reconnaissance de motifs invariant au déplacement et son architecture optique. Proc. Conférence annuelle de la Japan Society of Applied Physics, 1988. Premier CNN 2D "moderne" entraîné par rétropropagation, appliqué à la reconnaissance de caractères.

[5] J. Schmidhuber (AI Blog, 2025). Qui a inventé les réseaux neuronaux convolutifs ?

10,87K

Meilleurs

Classement

Favoris