Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeffrey Emanuel

Wow, man kann wirklich klar sehen, als ich MCP Agent Mail erstellt habe und plötzlich die Fähigkeit bekam, viel mehr Codierungsagenten gleichzeitig produktiv zu nutzen (sowie all meine anderen neuen Werkzeuge, die diese neuen Arbeitsabläufe ermöglicht haben).

Ich habe nur einen kleinen Bruchteil von dem veröffentlicht, was ich gebaut habe!

7,9K

Der Neocognitron war seiner Zeit so weit voraus. Fukushima erhält nicht genug Anerkennung. Auch ein großartiger Name.

Ich hoffe, er ist zumindest in Japan berühmt.

Jürgen Schmidhuber2. Dez., 23:20

Das Video von Fukushima (1986) zeigt ein CNN, das handgeschriebene Ziffern erkennt [3], drei Jahre bevor das Video von LeCun (1989) veröffentlicht wurde.

Die Zeitachse der CNNs stammt aus [5]:

★ 1969: Kunihiko Fukushima veröffentlichte rectified linear units oder ReLUs [1], die jetzt umfangreich in CNNs verwendet werden.

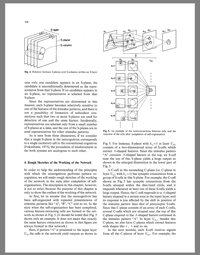

★ 1979: Fukushima veröffentlichte die grundlegende CNN-Architektur mit Faltungsschichten und Downsampling-Schichten [2]. Er nannte es Neocognitron. Es wurde durch unüberwachtes Lernen trainiert. Die Rechenleistung war 100 Mal teurer als 1989 und eine Milliarde Mal teurer als heute.

★ 1986: Fukushimas Video zur Erkennung handgeschriebener Ziffern [3].

★ 1988: Wei Zhang et al. hatten das erste "moderne" 2-dimensionale CNN, das durch Rückpropagation trainiert wurde, und wandten es auch auf die Zeichenerkennung an [4]. Die Rechenleistung war etwa 10 Millionen Mal teurer als heute.

★ 1989-: spätere Arbeiten von anderen [5].

REFERENZEN (mehr in [5])

[1] K. Fukushima (1969). Visuelle Merkmalsextraktion durch ein mehrschichtiges Netzwerk von analogen Schwellenwert-Elementen. IEEE Transactions on Systems Science and Cybernetics. 5 (4): 322-333. Diese Arbeit führte rectified linear units oder ReLUs ein, die jetzt weit verbreitet in CNNs und anderen neuronalen Netzen verwendet werden.

[2] K. Fukushima (1979). Neuronales Netzwerkmodell für einen Mechanismus der Mustererkennung, der nicht von Positionsverschiebungen betroffen ist—Neocognitron. Trans. IECE, vol. J62-A, no. 10, pp. 658-665, 1979. Die erste tiefe Faltungsneuronale Netzwerkarchitektur mit abwechselnden Faltungsschichten und Downsampling-Schichten. Auf Japanisch. Englische Version: 1980.

[3] Film produziert von K. Fukushima, S. Miyake und T. Ito (NHK Wissenschafts- und Technologieforschungsinstitute), 1986. YouTube:

[4] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka. Shift-invariant pattern recognition neural network und seine optische Architektur. Proc. Annual Conference of the Japan Society of Applied Physics, 1988. Erstes "modernes" durch Rückpropagation trainiertes 2-dimensionales CNN, angewendet auf die Zeichenerkennung.

[5] J. Schmidhuber (AI Blog, 2025). Wer hat die Faltungsneuronalen Netzwerke erfunden?

10,86K

Top

Ranking

Favoriten