Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

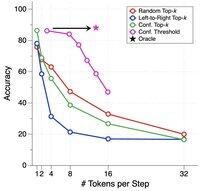

DLLM:er verkar lovande ... Men parallellgenerering är inte alltid möjlig

Diffusionsbaserade LLM:er kan generera många tokens på olika positioner samtidigt, medan de flesta autoregressiva LLM:er genererar tokens en efter en.

Detta gör diffusionsbaserade LLM:er mycket attraktiva när vi behöver snabb generering med mindre beräkning.

En stor fråga är ... Är parallell generering möjlig utan att förlora modelleringsnoggrannhet?

Svaret är nej. Det finns fundamentala gränser för hur mycket parallellitet vi kan uppnå.

Tänk på det här exemplet:

"Välj en stad enhetligt och slumpmässigt från följande fyra städer:

New York, New Orleans, Mexico City eller Panama City."

Då

P(Y₁ = Ny, Y₂ = York) = 1/4,

P(Y₁ = Ny, Y₂ = Orleans) = 1/4, och så vidare.

Således är P(Y₁ = Ny) = 1/2, P(Y₂ = Stad) = 1/2.

Om du väljer att generera Y₁ och Y₂ parallellt, oavsett vilken avkodningsalgoritm du använder ...

Du är dömd att prova "New City".

Ingen av dagens DLLM:er kan generera dessa två ord korrekt utan att ge upp parallellitet.

-----

Varför är det så?...

Topp

Rankning

Favoriter