Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

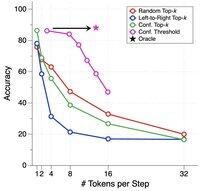

Os DLLMs parecem promissores... mas a geração paralela nem sempre é possível

Os LLMs baseados em difusão podem gerar muitos tokens em diferentes posições ao mesmo tempo, enquanto a maioria dos LLMs autoregressivos gera tokens um por um.

Isso torna os LLMs baseados em difusão altamente atraentes quando precisamos de geração rápida com menos computação.

Uma grande questão é... a geração paralela é possível sem perder a precisão do modelo?

A resposta é não. Existem limites fundamentais sobre quanto paralelismo podemos alcançar.

Considere este exemplo:

"Escolha uma cidade uniformemente ao acaso entre as seguintes quatro cidades:

Nova Iorque, Nova Orleans, Cidade do México ou Cidade do Panamá."

Então,

P(Y₁ = Nova, Y₂ = Iorque) = 1/4,

P(Y₁ = Nova, Y₂ = Orleans) = 1/4, e assim por diante.

Assim, P(Y₁ = Nova) = 1/2, P(Y₂ = Cidade) = 1/2.

Se você optar por gerar Y₁ e Y₂ em paralelo, não importa qual algoritmo de decodificação você use...

Você está fadado a amostrar "Nova Cidade."

Nenhum dos DLLMs de hoje pode gerar essas duas palavras corretamente sem abrir mão do paralelismo.

-----

Por que isso acontece?...

Top

Classificação

Favoritos