Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

DLLM-y wydają się obiecujące... ale generacja równoległa nie zawsze jest możliwa

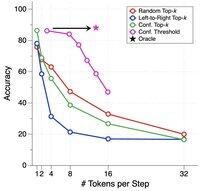

LLM-y oparte na dyfuzji mogą generować wiele tokenów w różnych pozycjach jednocześnie, podczas gdy większość autoregresywnych LLM-ów generuje tokeny jeden po drugim.

To sprawia, że LLM-y oparte na dyfuzji są bardzo atrakcyjne, gdy potrzebujemy szybkiej generacji przy mniejszym zużyciu mocy obliczeniowej.

Wielkim pytaniem jest... czy generacja równoległa jest możliwa bez utraty dokładności modelowania?

Odpowiedź brzmi nie. Istnieją fundamentalne ograniczenia dotyczące tego, ile równoległości możemy osiągnąć.

Rozważ ten przykład:

„Wybierz jedno miasto losowo z następujących czterech miast:

Nowy Jork, Nowy Orlean, Meksyk lub Panama City.”

Wtedy,

P(Y₁ = Nowy, Y₂ = Jork) = 1/4,

P(Y₁ = Nowy, Y₂ = Orlean) = 1/4, i tak dalej.

Zatem P(Y₁ = Nowy) = 1/2, P(Y₂ = Miasto) = 1/2.

Jeśli zdecydujesz się generować Y₁ i Y₂ równolegle, niezależnie od tego, jaki algorytm dekodowania użyjesz...

Jesteś skazany na próbkowanie „Nowe Miasto.”

Żaden z dzisiejszych DLLM-ów nie potrafi poprawnie wygenerować tych dwóch słów bez rezygnacji z równoległości.

-----

Dlaczego tak się dzieje?...

Najlepsze

Ranking

Ulubione