Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Întreprinderile construiesc RAG peste 100 de surse de date, nu una!

- Microsoft îl livrează în produsele M365.

- Google îl livrează în Vertex AI Search.

- AWS îl livrează în Amazon Q Business.

Să construim un RAG alimentat de MCP peste 200+ surse (100% locale):

Datele întreprinderii sunt împrăștiate în mai multe surse.

Astăzi, vom construi un server MCP unificat care poate interoga 200+ surse dintr-o singură interfață.

Stiva tehnologică:

- @mcpuse pentru a construi un client MCP local

- @MindsDB pentru a vă conecta la surse de date

- @ollama pentru a servi GPT-oss local

Să începem!

Iată fluxul de lucru:

- Utilizatorul trimite o interogare.

- Agentul se conectează la serverul MindsDB MCP pentru a găsi instrumente.

- Selectează instrumentul adecvat pe baza interogării utilizatorului și îl invocă

- În cele din urmă, returnează un răspuns relevant din punct de vedere contextual

Acum, să ne scufundăm în cod!

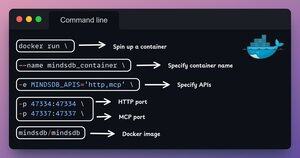

1️⃣ Configurare Docker

MindsDB oferă imagini Docker care pot fi rulate în containere Docker.

Instalați MindsDB local folosind imaginea Docker rulând comanda în terminal.

Verifică 👇 asta

2️⃣ Porniți interfața grafică MindsDB

După instalarea imaginii Docker, accesați portul localhost 47334 din browser pentru a accesa editorul MindsDB.

Prin această interfață, vă puteți conecta la peste 200 de surse de date și puteți rula interogări SQL împotriva acestora.

Verifică 👇 asta

3️⃣ Integrați sursele de date

Să începem să construim motorul nostru de interogare federativă conectând sursele noastre de date la MindsDB.

Folosim Slack, Gmail, GitHub și Hacker News ca surse de date federative.

Verifică 👇 asta

4️⃣ Configurarea serverului MCP

După construirea motorului de interogare federativ, să ne unificăm sursele de date conectându-le la serverul MCP al MindsDB.

Adăugați configurația serverului MCP la un fișier JSON, așa cum se arată mai jos.

Verifică 👇 asta

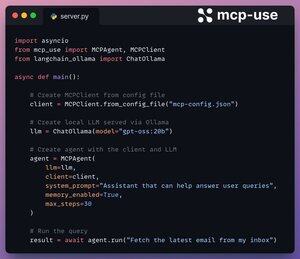

5️⃣ Conectați clientul la server

Am configurat clientul nostru local prin mcp-use și l-am conectat la serverul MCP cu doar 4 linii de cod.

1. Inițializați clientul MCP dintr-un fișier de configurare.

2. Conectați LLM local prin Ollama.

3. Creați Agent folosind LLM și Client.

4. Rulați interogarea.

Verificați acest lucru 👇

Făcut!

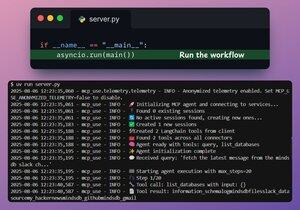

Serverul nostru MindsDB MCP este acum conectat la un client local prin mcp-use!

Oferă două instrumente:

- list_databases: Listează toate sursele de date conectate la MindsDB.

- interogare: Răspunde la interogările utilizatorilor cu privire la datele federative.

Verificați acest lucru 👇

În cele din urmă, ne împachetăm configurația într-o interfață Streamlit, unde putem schimba dinamic configurația MCP și putem discuta direct cu agentul.

Verificați această demonstrație👇

Asta e o încheiere!

Dacă ți s-a părut util, redistribui-l rețelei tale.

Găsește-mă → @_avichawla

În fiecare zi, împărtășesc tutoriale și informații despre DS, ML, LLM-uri și RAG.

8 aug., 14:33

Întreprinderile construiesc RAG peste 100 de surse de date, nu una!

- Microsoft îl livrează în produsele M365.

- Google îl livrează în Vertex AI Search.

- AWS îl livrează în Amazon Q Business.

Să construim un RAG alimentat de MCP peste 200+ surse (100% locale):

105,1K

Limită superioară

Clasament

Favorite