Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ondernemingen bouwen RAG over honderden gegevensbronnen, niet één!

- Microsoft levert het in M365-producten.

- Google levert het in zijn Vertex AI Search.

- AWS levert het in zijn Amazon Q Business.

Laten we een MCP-gestuurde RAG bouwen over 200+ bronnen (100% lokaal):

Bedrijfsdata is verspreid over veel bronnen.

Vandaag gaan we een uniforme MCP-server bouwen die meer dan 200 bronnen vanuit één interface kan opvragen.

Technologische stack:

- @mcpuse om een lokale MCP-client te bouwen

- @MindsDB om verbinding te maken met databronnen

- @ollama om GPT-oss lokaal te bedienen

Laten we beginnen!

Hier is de workflow:

- Gebruiker dient een vraag in.

- Agent maakt verbinding met de MindsDB MCP-server om tools te vinden.

- Selecteert de juiste tool op basis van de vraag van de gebruiker en roept deze aan.

- Ten slotte retourneert het een contextueel relevante reactie.

Laten we nu in de code duiken!

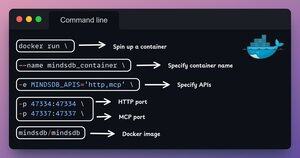

1️⃣ Docker-configuratie

MindsDB biedt Docker-images die in Docker-containers kunnen worden uitgevoerd.

Installeer MindsDB lokaal met behulp van de Docker-image door de opdracht in je terminal uit te voeren.

Bekijk dit 👇

2️⃣ Start MindsDB GUI

Na het installeren van de Docker-image, ga naar localhost poort 47334 in je browser om de MindsDB-editor te openen.

Via deze interface kun je verbinding maken met meer dan 200 gegevensbronnen en SQL-query's tegen hen uitvoeren.

Bekijk dit 👇

3️⃣ Integreer gegevensbronnen

Laten we beginnen met het bouwen van onze gefedereerde query-engine door onze gegevensbronnen te verbinden met MindsDB.

We gebruiken Slack, Gmail, GitHub en Hacker News als onze gefedereerde gegevensbronnen.

Bekijk dit 👇

4️⃣ MCP serverconfiguratie

Na het bouwen van de gefedereerde query-engine, laten we onze gegevensbronnen verenigen door ze te verbinden met de MCP-server van MindsDB.

Voeg de MCP-serverconfiguratie toe aan een JSON-bestand zoals hieronder weergegeven.

Bekijk dit 👇

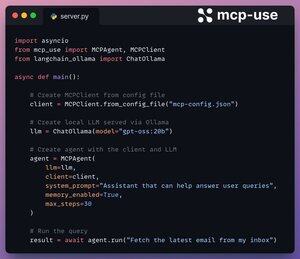

5️⃣ Verbind de client met de server

We stellen onze lokale client in via mcp-use en verbinden deze met de MCP-server met slechts 4 regels code.

1. Initialiseer de MCP-client vanuit een configuratiebestand.

2. Verbind lokale LLM via Ollama.

3. Maak een Agent met LLM en Client.

4. Voer de query uit.

Controleer dit 👇

Klaar!

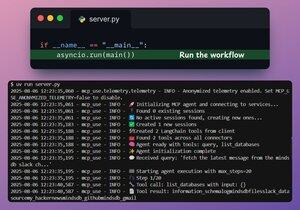

Onze MindsDB MCP-server is nu verbonden met een lokale client via mcp-use!

Het biedt twee tools:

- list_databases: Lijst alle gegevensbronnen die verbonden zijn met MindsDB.

- query: Beantwoordt gebruikersvragen over de gefedereerde gegevens.

Bekijk dit 👇

Ten slotte verpakken we onze setup in een Streamlit-interface, waar we de MCP-configuratie dynamisch kunnen wijzigen en direct met de agent kunnen chatten.

Bekijk deze demo👇

Dat is een wrap!

Als je het waardevol vond, deel het dan opnieuw met je netwerk.

Vind me → @_avichawla

Elke dag deel ik tutorials en inzichten over DS, ML, LLM's en RAG's.

8 aug, 14:33

Ondernemingen bouwen RAG over honderden gegevensbronnen, niet één!

- Microsoft levert het in M365-producten.

- Google levert het in zijn Vertex AI Search.

- AWS levert het in zijn Amazon Q Business.

Laten we een MCP-gestuurde RAG bouwen over 200+ bronnen (100% lokaal):

105,02K

Boven

Positie

Favorieten