トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

企業は、1 つではなく、100 を超える RAG データ ソースを構築しています。

- Microsoft は M365 製品で出荷します。

- Google は Vertex AI Search でこれを出荷します。

- AWS は Amazon Q Business で出荷します。

200 +ソース(100%ローカル)を超えるMCPを利用したRAGを構築しましょう。

エンタープライズ データは、多くのソースに散在しています。

今日は、1つのインターフェイスから200 +ソースをクエリできる統合MCPサーバーを構築します。

技術スタック:

- ローカルMCPクライアントを構築するための@mcpuse

- データソースに接続する@MindsDB

- GPT-ossをローカルで提供する@ollama

さあ、始めましょう!

ワークフローは次のとおりです。

- ユーザーがクエリを送信します。

- エージェントは MindsDB MCP サーバーに接続してツールを検索します。

- ユーザーのクエリに基づいて適切なツールを選択し、それを呼び出します

- 最後に、コンテキストに関連する応答を返します

それでは、コードに飛び込みましょう!

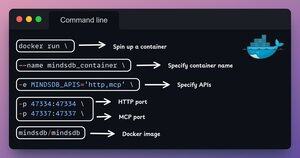

1️⃣ Docker のセットアップ

MindsDBは、Dockerコンテナで実行できるDockerイメージを提供します。

ターミナルでコマンドを実行し、Docker イメージを使用して MindsDB をローカルにインストールします。

これがいいと思います 👇

2️⃣ MindsDB GUI を起動する

Docker イメージをインストールしたら、ブラウザーで localhost ポート 47334 に移動して、MindsDB エディターにアクセスします。

このインターフェイスを介して、200を超えるデータソースに接続し、それらに対してSQLクエリを実行できます。

これがいいと思います 👇

3️⃣ データソースの統合

データソースをMindsDBに接続して、フェデレーションクエリエンジンの構築を開始しましょう。

Slack、Gmail、GitHub、Hacker News をフェデレーションデータソースとして使用しています。

これがいいと思います 👇

4️⃣ MCP サーバー構成

フェデレーションクエリエンジンを構築したら、データソースをMindsDBのMCPサーバーに接続して統合しましょう。

以下に示すように、MCP サーバー構成を JSON ファイルに追加します。

これがいいと思います 👇

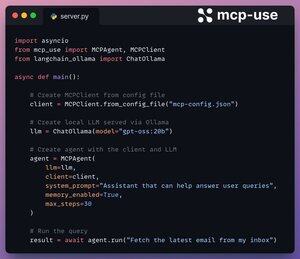

5️⃣ クライアントをサーバーに接続する

mcp-useを介してローカルクライアントをセットアップし、わずか4行のコードでMCPサーバーに接続します。

1. 構成ファイルから MCP クライアントを初期化します。

2. Ollama 経由でローカル LLM を接続します。

3. LLMとクライアントを使用してエージェントを作成します。

4. クエリを実行します。

これを👇チェックしてください

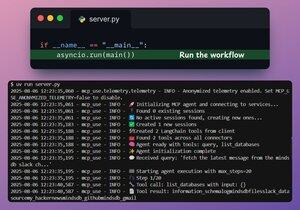

完成です!

これで、MindsDB MCPサーバーがmcp-useを介してローカルクライアントに接続されました。

次の 2 つのツールを提供します。

- list_databases: MindsDBに接続されているすべてのデータソースを一覧表示します。

- query: フェデレーテッド・データに関するユーザーのクエリに回答します。

これを👇チェックしてください

最後に、Streamlitインターフェースでセットアップをラップし、MCP設定を動的に変更し、エージェントと直接チャットすることができます。

このデモ👇をチェック

これでおしまいです!

洞察力に富んでいると感じた場合は、ネットワークで再共有してください。

→ @_avichawla探して

私は毎日、DS、ML、LLM、RA に関するチュートリアルと洞察を共有しています。

8月8日 14:33

企業は、1 つではなく、100 を超える RAG データ ソースを構築しています。

- Microsoft は M365 製品で出荷します。

- Google は Vertex AI Search でこれを出荷します。

- AWS は Amazon Q Business で出荷します。

200 +ソース(100%ローカル)を超えるMCPを利用したRAGを構築しましょう。

105.03K

トップ

ランキング

お気に入り