Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

As empresas constroem RAG sobre centenas de fontes de dados, não apenas uma!

- A Microsoft inclui isso nos produtos M365.

- O Google inclui isso na sua Pesquisa Vertex AI.

- A AWS inclui isso no seu Amazon Q Business.

Vamos construir um RAG alimentado por MCP sobre mais de 200 fontes (100% local):

Os dados empresariais estão dispersos por muitas fontes.

Hoje, vamos construir um servidor MCP unificado que pode consultar mais de 200 fontes a partir de uma única interface.

Stack tecnológico:

- @mcpuse para construir um cliente MCP local

- @MindsDB para conectar a fontes de dados

- @ollama para servir o GPT-oss localmente

Vamos começar!

Aqui está o fluxo de trabalho:

- O utilizador submete uma consulta.

- O agente conecta-se ao servidor MindsDB MCP para encontrar ferramentas.

- Seleciona a ferramenta apropriada com base na consulta do utilizador e a invoca.

- Finalmente, retorna uma resposta contextualmente relevante.

Agora, vamos mergulhar no código!

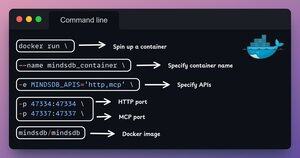

1️⃣ Configuração do Docker

O MindsDB fornece imagens Docker que podem ser executadas em contêineres Docker.

Instale o MindsDB localmente usando a imagem Docker executando o comando no seu terminal.

Confira isto 👇

2️⃣ Iniciar a GUI do MindsDB

Após instalar a imagem do Docker, vá para o localhost na porta 47334 no seu navegador para acessar o editor do MindsDB.

Através desta interface, você pode conectar-se a mais de 200 fontes de dados e executar consultas SQL contra elas.

Confira isto 👇

3️⃣ Integrar fontes de dados

Vamos começar a construir nosso motor de consulta federado conectando nossas fontes de dados ao MindsDB.

Usamos Slack, Gmail, GitHub e Hacker News como nossas fontes de dados federadas.

Veja isto 👇

4️⃣ Configuração do servidor MCP

Após construir o motor de consulta federado, vamos unificar nossas fontes de dados conectando-as ao servidor MCP da MindsDB.

Adicione a configuração do servidor MCP a um arquivo JSON como mostrado abaixo.

Confira isto 👇

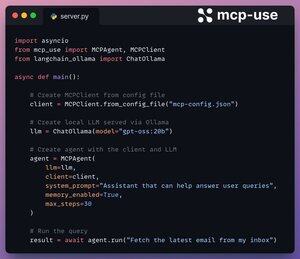

5️⃣ Conectar cliente ao servidor

Configuramos nosso cliente local via mcp-use e o conectamos ao servidor MCP com apenas 4 linhas de código.

1. Inicializar o cliente MCP a partir de um arquivo de configuração.

2. Conectar LLM local via Ollama.

3. Criar Agente usando LLM e Cliente.

4. Executar a consulta.

Verifique isto 👇

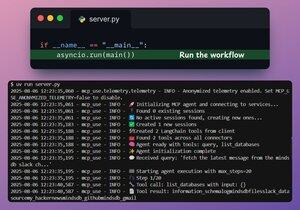

Feito!

O nosso servidor MindsDB MCP está agora conectado a um cliente local via mcp-use!

Oferece duas ferramentas:

- list_databases: Lista todas as fontes de dados conectadas ao MindsDB.

- query: Responde a consultas dos utilizadores sobre os dados federados.

Verifique isto 👇

Por último, envolvemos a nossa configuração numa interface Streamlit, onde podemos alterar dinamicamente a configuração do MCP e conversar diretamente com o agente.

Veja esta demonstração👇

É isso!

Se achou útil, partilhe com a sua rede.

Encontre-me → @_avichawla

Todos os dias, partilho tutoriais e insights sobre DS, ML, LLMs e RAGs.

8/08, 14:33

As empresas constroem RAG sobre centenas de fontes de dados, não apenas uma!

- A Microsoft inclui isso nos produtos M365.

- O Google inclui isso na sua Pesquisa Vertex AI.

- A AWS inclui isso no seu Amazon Q Business.

Vamos construir um RAG alimentado por MCP sobre mais de 200 fontes (100% local):

105,02K

Top

Classificação

Favoritos