Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 fasi di addestramento dei LLM da zero, spiegate chiaramente (con immagini):

Oggi stiamo coprendo le 4 fasi della creazione di LLM da zero per renderli applicabili ai casi d'uso del mondo reale.

Tratteremo:

- Pre-allenamento

- Messa a punto delle istruzioni

- Messa a punto delle preferenze

- Messa a punto del ragionamento

L'oggetto visivo riepiloga queste tecniche.

Tuffiamoci!

0️⃣ LLM inizializzato in modo casuale

A questo punto, il modello non sa nulla.

Gli chiedi "Che cos'è un LLM?" e ricevi parole senza senso come "prova peter hand e ciao 448Sn".

Non ha ancora visto alcun dato e possiede solo pesi casuali.

Controlla questo 👇

1️⃣ Pre-allenamento

Questa fase insegna all'LLM le basi del linguaggio addestrandolo su enormi corpora per prevedere il token successivo. In questo modo, assorbe la grammatica, i fatti del mondo, ecc.

Ma non è bravo nella conversazione perché, quando richiesto, continua semplicemente il testo.

Controlla questo 👇

2️⃣ Istruzioni per la messa a punto

Per renderlo colloquiale, eseguiamo la messa a punto delle istruzioni attraverso la formazione sulle coppie istruzione-risposta. Questo lo aiuta a imparare a seguire le istruzioni e formattare le risposte.

Ora può:

- Rispondi alle domande

- Riassumi il contenuto

- Scrivi codice, ecc.

Controlla questo 👇

A questo punto, abbiamo probabilmente:

- Utilizzato l'intero archivio e la conoscenza grezza di Internet.

- Il budget per i dati di risposta alle istruzioni etichettati dall'uomo.

Quindi cosa possiamo fare per migliorare ulteriormente il modello?

Entriamo nel territorio dell'apprendimento per rinforzo (RL).

Impariamo dopo 👇

3️⃣ Regolazione fine delle preferenze (PFT)

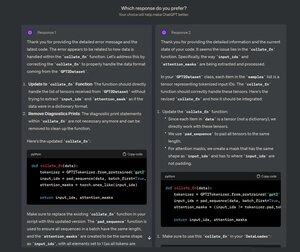

Devi aver visto questa schermata su ChatGPT dove chiede: Quale risposta preferisci?

Non si tratta solo di feedback, ma di preziosi dati sulle preferenze umane.

OpenAI lo utilizza per mettere a punto i propri modelli utilizzando la messa a punto delle preferenze.

Controlla questo 👇

In PFT:

L'utente sceglie tra 2 risposte per produrre dati sulle preferenze umane.

Un modello di ricompensa viene quindi addestrato per prevedere le preferenze umane e l'LLM viene aggiornato utilizzando RL.

Controlla questo 👇

Il processo di cui sopra è chiamato RLHF (Reinforcement Learning with Human Feedback) e l'algoritmo utilizzato per aggiornare i pesi del modello è chiamato PPO.

Insegna all'LLM ad allinearsi con gli esseri umani anche quando non c'è una risposta "corretta".

Ma possiamo migliorare ancora di più l'LLM.

Impariamo dopo👇

4️⃣ Messa a punto del ragionamento

Nei compiti di ragionamento (matematica, logica, ecc.), di solito c'è solo una risposta corretta e una serie definita di passaggi per ottenere la risposta.

Quindi non abbiamo bisogno delle preferenze umane e possiamo usare la correttezza come segnale.

Questo è chiamato fine-tuning👇 del ragionamento

Passi:

- Il modello genera una risposta a un prompt.

- La risposta viene confrontata con la risposta corretta nota.

- In base alla correttezza, assegniamo una ricompensa.

Questo è chiamato Apprendimento per Rinforzo con Ricompense Verificabili.

GRPO di DeepSeek è una tecnica popolare.

Controlla questo👇

Queste erano le 4 fasi della formazione di un LLM da zero.

- Iniziare con un modello inizializzato in modo casuale.

- Pre-addestralo su corpora su larga scala.

- Usa la messa a punto delle istruzioni per fargli seguire i comandi.

- Usa la regolazione fine delle preferenze e del ragionamento per affinare le risposte.

Controlla questo 👇

Se l'hai trovato interessante, condividilo nuovamente con la tua rete.

Trovami → @_avichawla

Ogni giorno condivido tutorial e approfondimenti su DS, ML, LLM e RAG.

21 lug 2025

4 fasi di addestramento dei LLM da zero, spiegate chiaramente (con immagini):

@tasiorek27 Messa a punto del rinforzo:

Messa a punto delle istruzioni: (Non si tratta di addestramento di per sé, ma piuttosto di generare un set di dati di messa a punto delle istruzioni)

6 mag 2025

Generiamo il nostro set di dati di messa a punto LLM (100% locale):

714,07K

Principali

Ranking

Preferiti