Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 tahap pelatihan LLM dari awal, dijelaskan dengan jelas (dengan visual):

Hari ini, kami membahas 4 tahap membangun LLM dari awal untuk membuatnya dapat diterapkan untuk kasus penggunaan dunia nyata.

Kami akan membahas:

- Pra-pelatihan

- Penyetelan instruksi

- Penyetelan preferensi

- Penyempurnaan penalaran

Visual merangkum teknik ini.

Mari selam!

0️⃣ LLM yang diinisialisasi secara acak

Pada titik ini, model tidak tahu apa-apa.

Anda bertanya "Apa itu LLM?" dan mendapatkan omong kosong seperti "coba tangan peter dan halo 448Sn".

Itu belum melihat data apa pun dan hanya memiliki bobot acak.

Periksa ini 👇

1️⃣ Pra-pelatihan

Tahap ini mengajarkan LLM dasar-dasar bahasa dengan melatihnya pada korpus besar untuk memprediksi token berikutnya. Dengan cara ini, ia menyerap tata bahasa, fakta dunia, dll.

Tapi itu tidak baik dalam percakapan karena ketika diminta, itu hanya melanjutkan teks.

Periksa ini 👇

2️⃣ Penyetelan instruksi

Untuk membuatnya percakapan, kami melakukan Penyempurnaan Instruksi dengan melatih pasangan instruksi-respons. Ini membantunya mempelajari cara mengikuti petunjuk dan memformat balasan.

Sekarang bisa:

- Menjawab pertanyaan

- Merangkum konten

- Tulis kode, dll.

Periksa ini 👇

Pada titik ini, kita kemungkinan:

- Memanfaatkan seluruh arsip dan pengetahuan internet mentah.

- Anggaran untuk data respons instruksi berlabel manusia.

Jadi apa yang dapat kita lakukan untuk lebih meningkatkan model?

Kami memasuki wilayah Reinforcement Learning (RL).

Mari kita pelajari selanjutnya 👇

3️⃣ Penyetelan halus preferensi (PFT)

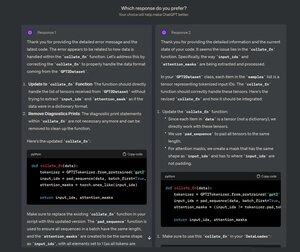

Anda pasti pernah melihat layar ini di ChatGPT di mana ia bertanya: Tanggapan mana yang Anda sukai?

Itu bukan hanya untuk umpan balik tetapi juga data preferensi manusia yang berharga.

OpenAI menggunakan ini untuk menyempurnakan model mereka menggunakan penyempurnaan preferensi.

Periksa ini 👇

Dalam PFT:

Pengguna memilih di antara 2 respons untuk menghasilkan data preferensi manusia.

Model hadiah kemudian dilatih untuk memprediksi preferensi manusia dan LLM diperbarui menggunakan RL.

Periksa ini 👇

Proses di atas disebut RLHF (Reinforcement Learning with Human Feedback) dan algoritma yang digunakan untuk memperbarui bobot model disebut PPO.

Ini mengajarkan LLM untuk menyelaraskan dengan manusia bahkan ketika tidak ada jawaban yang "benar".

Tapi kita bisa meningkatkan LLM lebih banyak lagi.

Mari kita pelajari selanjutnya👇

4️⃣ Penyempurnaan penalaran

Dalam tugas penalaran (matematika, logika, dll.), Biasanya hanya ada satu respons yang benar dan serangkaian langkah yang ditentukan untuk mendapatkan jawabannya.

Jadi kita tidak membutuhkan preferensi manusia, dan kita dapat menggunakan kebenaran sebagai sinyal.

Ini disebut penalaran fine-tuning👇

Langkah:

- Model menghasilkan jawaban atas perintah.

- Jawabannya dibandingkan dengan jawaban yang benar yang diketahui.

- Berdasarkan kebenaran, kami menetapkan hadiah.

Ini disebut Reinforcement Learning dengan Reward yang Dapat Diverifikasi.

GRPO oleh DeepSeek adalah teknik yang populer.

Periksa ini👇

Itulah 4 tahap pelatihan LLM dari awal.

- Mulailah dengan model yang diinisialisasi secara acak.

- Pra-latihnya pada corpora skala besar.

- Gunakan penyempurnaan instruksi untuk membuatnya mengikuti perintah.

- Gunakan penyempurnaan preferensi & penalaran untuk mempertajam tanggapan.

Periksa ini 👇

Jika Anda merasa berwawasan luas, bagikan kembali dengan jaringan Anda.

Temukan saya → @_avichawla

Setiap hari, saya berbagi tutorial dan wawasan tentang DS, ML, LLM, dan RAG.

21 Jul 2025

4 tahap pelatihan LLM dari awal, dijelaskan dengan jelas (dengan visual):

@tasiorek27 Penyempurnaan penguatan:

Penyempurnaan instruksi: (Ini bukan tentang pelatihan itu sendiri dengan melainkan tentang menghasilkan set data penyempurnaan instruksi)

6 Mei 2025

Mari kita buat dataset penyempurnaan LLM kita sendiri (100% lokal):

714,07K

Teratas

Peringkat

Favorit