Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 Phasen des Trainings von LLMs von Grund auf, klar erklärt (mit Visualisierungen):

Heute behandeln wir die 4 Phasen des Aufbaus von LLMs von Grund auf, um sie für reale Anwendungsfälle nutzbar zu machen.

Wir werden behandeln:

- Vortraining

- Anweisungsfeinabstimmung

- Präferenzfeinabstimmung

- Denkfeinabstimmung

Die Visualisierung fasst diese Techniken zusammen.

Lass uns eintauchen!

0️⃣ Zufällig initialisiertes LLM

An diesem Punkt weiß das Modell nichts.

Sie fragen es: „Was ist ein LLM?“ und erhalten Kauderwelsch wie „versuchen Sie Peter Hand und hallo 448Sn“.

Es hat noch keine Daten gesehen und besitzt nur zufällige Gewichte.

Überprüfen Sie dies 👇

1️⃣ Vortraining

Diese Phase lehrt das LLM die Grundlagen der Sprache, indem es auf massiven Korpora trainiert wird, um das nächste Token vorherzusagen. Auf diese Weise absorbiert es Grammatik, Weltwissen usw.

Aber es ist nicht gut im Gespräch, denn wenn es aufgefordert wird, setzt es einfach den Text fort.

Überprüfen Sie dies 👇

2️⃣ Anweisungsfeinabstimmung

Um es gesprächiger zu machen, führen wir eine Anweisungsfeinabstimmung durch, indem wir mit Anweisungs-Antwort-Paaren trainieren. Dies hilft ihm, zu lernen, wie man Aufforderungen folgt und Antworten formatiert.

Jetzt kann es:

- Fragen beantworten

- Inhalte zusammenfassen

- Code schreiben, usw.

Überprüfen Sie das 👇

An diesem Punkt haben wir wahrscheinlich:

- Das gesamte Rohdatenarchiv und Wissen des Internets genutzt.

- Das Budget für menschlich gekennzeichnete Antwortdaten für Anweisungen.

Was können wir also tun, um das Modell weiter zu verbessern?

Wir betreten das Gebiet des Reinforcement Learning (RL).

Lass uns als Nächstes lernen 👇

3️⃣ Präferenz-Fine-Tuning (PFT)

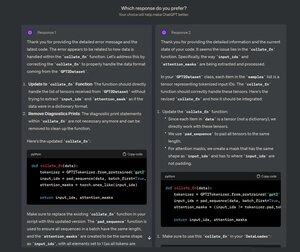

Sie haben diesen Bildschirm bei ChatGPT gesehen, auf dem gefragt wird: Welche Antwort bevorzugen Sie?

Das dient nicht nur als Feedback, sondern ist wertvolle Daten zu menschlichen Präferenzen.

OpenAI nutzt dies, um ihre Modelle mit Präferenz-Fine-Tuning zu optimieren.

Überprüfen Sie das 👇

In PFT:

Der Benutzer wählt zwischen 2 Antworten, um Daten zur menschlichen Präferenz zu erzeugen.

Ein Belohnungsmodell wird dann trainiert, um die menschliche Präferenz vorherzusagen, und das LLM wird mithilfe von RL aktualisiert.

Überprüfen Sie dies 👇

Der oben beschriebene Prozess wird als RLHF (Reinforcement Learning with Human Feedback) bezeichnet, und der Algorithmus, der zur Aktualisierung der Modellgewichte verwendet wird, heißt PPO.

Er lehrt das LLM, sich an Menschen anzupassen, selbst wenn es keine "richtige" Antwort gibt.

Aber wir können das LLM noch weiter verbessern.

Lass uns als Nächstes lernen👇

4️⃣ Feinabstimmung des Denkens

Bei Denkaufgaben (Mathematik, Logik usw.) gibt es normalerweise nur eine richtige Antwort und eine definierte Reihe von Schritten, um die Antwort zu erhalten.

Daher benötigen wir keine menschlichen Präferenzen, und wir können die Richtigkeit als Signal verwenden.

Dies wird als Feinabstimmung des Denkens bezeichnet👇

Schritte:

- Das Modell generiert eine Antwort auf eine Eingabeaufforderung.

- Die Antwort wird mit der bekannten korrekten Antwort verglichen.

- Basierend auf der Richtigkeit vergeben wir eine Belohnung.

Dies wird als Verstärkendes Lernen mit überprüfbaren Belohnungen bezeichnet.

GRPO von DeepSeek ist eine beliebte Technik.

Überprüfen Sie dies👇

Das waren die 4 Stufen der Ausbildung eines LLM von Grund auf.

- Beginnen Sie mit einem zufällig initialisierten Modell.

- Trainieren Sie es vor großen Korpora.

- Verwenden Sie die Feinabstimmung der Anweisungen, damit sie Befehlen folgen.

- Nutzen Sie die Feinabstimmung von Präferenzen und Argumentationen, um die Antworten zu schärfen.

Überprüfen Sie dies 👇

Wenn Sie es aufschlussreich fanden, teilen Sie es erneut mit Ihrem Netzwerk.

Finde mich → @_avichawla

Jeden Tag teile ich Tutorials und Einblicke in DS, ML, LLMs und RAGs.

21. Juli 2025

4 Phasen des Trainings von LLMs von Grund auf, klar erklärt (mit Visualisierungen):

@tasiorek27 Feinabstimmung der Verstärkung:

Instruktionsfeinabstimmung: (Hier geht es nicht um das Training an sich, sondern um die Generierung eines Instruktionsfeinabstimmungsdatensatzes)

6. Mai 2025

Generieren wir unseren eigenen LLM-Feinabstimmungsdatensatz (100% lokal):

714,14K

Top

Ranking

Favoriten