Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 etapas de entrenamiento de LLMs desde cero, explicadas claramente (con visuales):

Hoy, cubriremos las 4 etapas de la construcción de LLMs desde cero para hacerlos aplicables a casos de uso del mundo real.

Cubriremos:

- Pre-entrenamiento

- Ajuste fino de instrucciones

- Ajuste fino de preferencias

- Ajuste fino de razonamiento

La visualización resume estas técnicas.

¡Vamos a sumergirnos!

0️⃣ LLM inicializado aleatoriamente

En este punto, el modelo no sabe nada.

Le preguntas "¿Qué es un LLM?" y obtienes un galimatías como "intenta peter hand y hello 448Sn".

No ha visto ningún dato aún y posee solo pesos aleatorios.

Mira esto 👇

1️⃣ Pre-entrenamiento

Esta etapa enseña al LLM los conceptos básicos del lenguaje entrenándolo en grandes corpus para predecir el siguiente token. De esta manera, absorbe gramática, hechos del mundo, etc.

Pero no es bueno en conversaciones porque, cuando se le solicita, simplemente continúa el texto.

Mira esto 👇

2️⃣ Ajuste fino de instrucciones

Para hacerlo conversacional, realizamos un ajuste fino de instrucciones entrenando con pares de instrucciones-respuestas. Esto ayuda a que aprenda a seguir indicaciones y a formatear respuestas.

Ahora puede:

- Responder preguntas

- Resumir contenido

- Escribir código, etc.

Mira esto 👇

En este punto, probablemente hemos:

- Utilizado todo el archivo de internet en bruto y el conocimiento.

- El presupuesto para datos de respuesta a instrucciones etiquetados por humanos.

Entonces, ¿qué podemos hacer para mejorar aún más el modelo?

Entramos en el territorio del Aprendizaje por Refuerzo (RL).

Aprendamos a continuación 👇

3️⃣ Ajuste fino de preferencias (PFT)

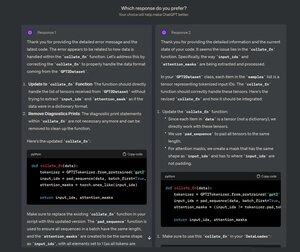

Debes haber visto esta pantalla en ChatGPT donde pregunta: ¿Cuál respuesta prefieres?

Eso no es solo para obtener retroalimentación, sino que es valiosa información sobre las preferencias humanas.

OpenAI utiliza esto para ajustar sus modelos mediante el ajuste fino de preferencias.

Mira esto 👇

En PFT:

El usuario elige entre 2 respuestas para producir datos de preferencia humana.

Luego se entrena un modelo de recompensa para predecir la preferencia humana y se actualiza el LLM utilizando RL.

Mira esto 👇

El proceso anterior se llama RLHF (Aprendizaje por Refuerzo con Retroalimentación Humana) y el algoritmo utilizado para actualizar los pesos del modelo se llama PPO.

Enseña al LLM a alinearse con los humanos incluso cuando no hay una respuesta "correcta".

Pero podemos mejorar aún más el LLM.

Aprendamos a continuación👇

4️⃣ Ajuste fino del razonamiento

En tareas de razonamiento (matemáticas, lógica, etc.), generalmente hay una sola respuesta correcta y una serie definida de pasos para obtener la respuesta.

Así que no necesitamos preferencias humanas, y podemos usar la corrección como señal.

Esto se llama ajuste fino del razonamiento👇

Pasos:

- El modelo genera una respuesta a un aviso.

- La respuesta se compara con la respuesta correcta conocida.

- Según la corrección, asignamos una recompensa.

Esto se llama Aprendizaje por Refuerzo con Recompensas Verificables.

GRPO de DeepSeek es una técnica popular.

Revisa esto👇

Esas fueron las 4 etapas de entrenar un LLM desde cero.

- Comience con un modelo inicializado aleatoriamente.

- Pre-entrénalo en corpus a gran escala.

- Utilice el ajuste fino de instrucciones para que siga los comandos.

- Utilice el ajuste fino de preferencias y razonamientos para afinar las respuestas.

Mira esto 👇

Si te ha resultado interesante, vuelve a compartirlo con tu red.

Encuéntrame → @_avichawla

Todos los días, comparto tutoriales e ideas sobre DS, ML, LLM y RAG.

21 jul 2025

4 etapas de entrenamiento de LLMs desde cero, explicadas claramente (con visuales):

@tasiorek27 Ajuste fino de refuerzos:

Ajuste fino de instrucciones: (No se trata de entrenamiento per se sino de generar un conjunto de datos de ajuste fino de instrucciones)

6 may 2025

Let's generate our own LLM fine-tuning dataset (100% local):

714,23K

Parte superior

Clasificación

Favoritos