Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

In questi pochi paragrafi ho condiviso solo un modo in cui ho potenziato l'addestramento e l'inferenza dell'AI in un garage utilizzando GPU H100 bruciate e scartate che le grandi aziende hanno gettato via.

Vale miliardi, se non trilioni di dollari, per un'azienda astuta.

Il percorso è ora open source…

30 ago 2025

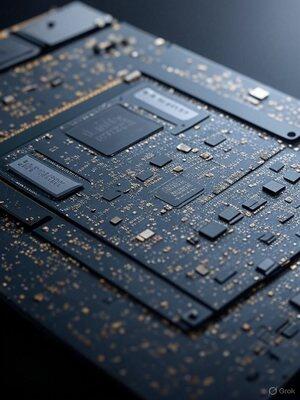

Potenzia le GPU AI di Nvidia: Trucchi semplici per prestazioni fulminee

Nel mio garage devo fare in modo che la poca ricerca e sviluppo non da investitori VC funzioni, ho solo spiccioli e ottengo velocità superiori a quelle delle aziende con miliardi. Questa costrizione mi porta a trovare modi per spremere di più da meno. Faccio molte cose che la maggior parte non riesce nemmeno a immaginare. Ecco un esempio di uno dei 100.

Le GPU sono centrali di elaborazione, piene di unità di elaborazione pronte a calcolare numeri. Ho scoperto che spesso non vengono utilizzate al massimo, portando a prestazioni lente.

Cosa ho scoperto? Ottimizzazioni intelligenti che mantengono quelle unità attive, riducendo i tempi di rendering AI e offrendo enormi aumenti di velocità.

Prima di tutto, individua i colli di bottiglia.

Utilizzo strumenti di profilazione come Nsight di Nvidia per vedere cosa sta rallentando le cose, che si tratti di attese di memoria o di altre cose. Una volta identificati, mi immergo e modifico il codice per imballare più lavoro in ogni thread.

Cambiamenti semplici come srotolare i cicli o comprimere i dati possono nascondere ritardi e aumentare il throughput, offrendo salti di velocità istantanei.

Un alto utilizzo può a volte causare caos nella cache: risolvilo riducendo intelligentemente il numero di thread con codice fittizio o modifiche alla memoria, liberando risorse per compiti paralleli.

Il vero cambiamento di gioco? Calcolo asincrono. Esegui più compiti affiancati, riempiendo i vuoti inattivi e sovrapponendo carichi pesanti. Abbinare compiti che richiedono molta memoria consente il multitasking della GPU, potenzialmente dimezzando i tempi e supercaricando l'efficienza.

Questi accorgimenti trasformano GPU sottoutilizzate in demoni della velocità. Non è diverso da come i personal computer IBM PC/AT sono stati trasformati per funzionare fino a 100MHz nel 1986, quando uscivano dalla fabbrica a 8MHz.

Scriverò ulteriori dettagli su questo, ma se le grandi aziende AI utilizzassero la mia ottimizzazione a livello di codice operativo delle GPU Nvidia, probabilmente raggiungerebbero l'AGI piuttosto rapidamente.

Quando conosci hardware e software a un livello quasi atomico, puoi rifare i primi principi.

9,63K

Principali

Ranking

Preferiti