Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

In deze paar paragrafen heb ik slechts één manier gegeven waarop ik AI-training en inferentie een boost heb gegeven in een garage met afgedankte en versleten H100 GPU's die grote bedrijven hebben weggegooid.

Het is miljarden, zo niet triljoenen dollars waard voor een scherpzinnig bedrijf.

Het pad is nu open source...

30 aug 2025

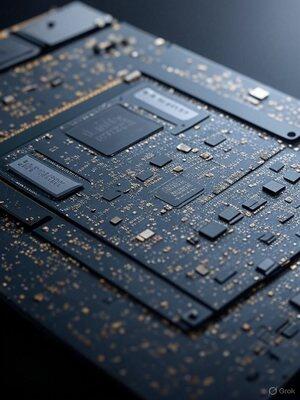

Turbocharge Nvidia AI GPU's: Eenvoudige trucs voor razendsnelle prestaties

In mijn garage moet ik met de weinige niet-VC investeerder onderzoek en ontwikkeling die ik heb, werken; ik heb centen en krijg hogere snelheid dan bedrijven met miljarden. Deze beperking dwingt me om manieren te vinden om meer uit minder te halen. Ik doe veel dingen waar de meesten niet aan kunnen denken. Hier is een voorbeeld van slechts één van de 100.

GPU's zijn krachtpatsers, volgestouwd met tonnen verwerkingsunits die klaar zijn om cijfers te verwerken. Ik ontdekte echter dat ze vaak niet volledig worden benut, wat leidt tot trage prestaties.

Wat ontdekte ik? Slimme optimalisaties die die units aan het zoemen houden, de AI-render tijden verkorten en enorme snelheidsverhogingen leveren.

Eerst, spot de knelpunten.

Ik gebruik profileringshulpmiddelen zoals Nvidia's Nsight om te zien wat de boel tegenhoudt, of het nu geheugenwachttijden of andere dingen zijn. Zodra ik ze heb geïdentificeerd, duik ik erin en pas ik de code aan om meer werk in elke thread te proppen.

Eenvoudige wijzigingen zoals het uitrollen van lussen of het comprimeren van gegevens kunnen vertragingen verbergen en de doorvoer verhogen, wat directe snelheidsverhogingen oplevert.

Hoge belasting kan soms cache-chaos veroorzaken—los het op door slim het aantal threads te verminderen met dummy-code of geheugenaanpassingen, waardoor middelen vrijkomen voor parallelle taken.

De echte game-changer? Async compute. Voer meerdere taken naast elkaar uit, vul inactieve gaten en overlappend zware ladingen. Combineer een geheugenintensievere taak met GPU-multitasking—potentieel halvering van tijden en supercharging van efficiëntie.

Deze tweaks transformeren onderbenutte GPU's in snelheidsduivels. Het is niet anders dan hoe IBM PC/AT's persoonlijke computers transformeerde om tot 100MHz te draaien in 1986, toen ze uit de fabriek kwamen op 8MHz.

Ik zal meer details hierover schrijven, maar als grote AI-bedrijven mijn opcode-niveau Nvidia GPU-optimalisatie zouden gebruiken, zouden ze waarschijnlijk snel AGI bereiken.

Wanneer je hardware en software op bijna atomair niveau kent, kun je de eerste principes opnieuw maken.

9,64K

Boven

Positie

Favorieten