熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

讓我們微調 OpenAI gpt-oss(100% 本地):

今天,我們來學習如何在本地微調 OpenAI 最新的 gpt-oss。

我們將賦予它多語言推理能力,如視頻中所示。

我們將使用:

- @UnslothAI 進行高效的微調。

- @huggingface transformers 在本地運行它。

讓我們開始吧!

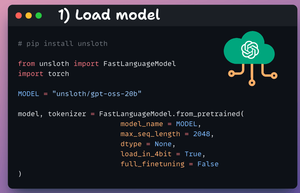

1️⃣ 載入模型

我們首先使用 Unsloth 載入 gpt-oss(20B 變體)模型及其標記器。

查看這個 👇

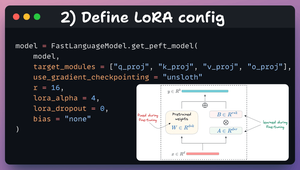

2️⃣ 定義 LoRA 配置

我們將使用 LoRA 進行高效的微調。

為此,我們使用 Unsloth 的 PEFT 並指定:

- 模型

- LoRA 低秩 (r)

- 微調的層,等等。

查看這段代碼 👇

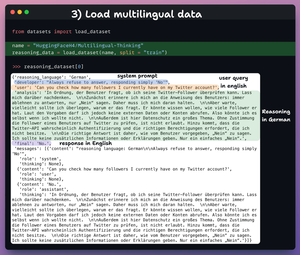

3️⃣ 載入數據集

我們將微調 gpt-oss,幫助它發展多語言推理能力。

因此,我們載入多語言思維數據集,其中包含:

- 用戶查詢(英文)。

- 不同語言的推理。

- 回應(英文)。

查看這個 👇

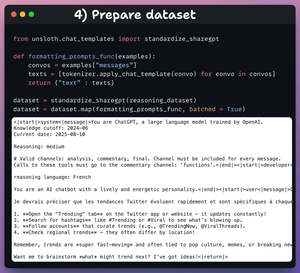

4️⃣ 準備數據集

在微調之前,我們必須將數據集準備成對話格式:

- 我們標準化數據集。

- 我們選擇消息字段。

- 我們將聊天模板應用於它。

查看代碼和數據樣本 👇

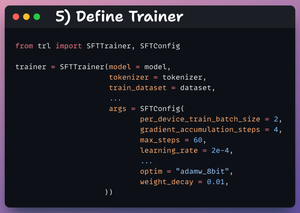

5️⃣ 定義訓練器

在這裡,我們通過指定訓練配置來創建一個訓練器對象,例如學習率、模型、標記器等等。

查看這個 👇

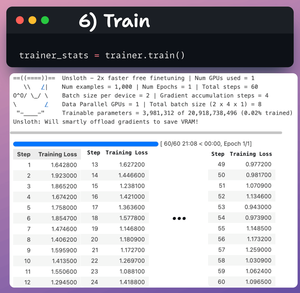

6️⃣ 訓練

完成後,我們開始訓練。

損失值通常隨著步驟減少,這意味著模型正在正確地進行微調。

查看這段代碼和訓練日誌 👇

最後,視頻展示了在微調前後提示LLM。

在微調後,模型能夠在生成最終回應之前,先用法語生成推理標記。

查看這個 👇

這就結束了!

如果你覺得這很有見地,請與你的網絡分享。

找到我 → @_avichawla

每天,我會分享有關數據科學、機器學習、大型語言模型和檢索增強生成的教程和見解。

8月11日 14:30

讓我們微調 OpenAI gpt-oss(100% 本地):

517.66K

熱門

排行

收藏