Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Affiniamo OpenAI gpt-oss (100% localmente):

Oggi, impariamo come ottimizzare localmente l'ultima versione di gpt-oss di OpenAI.

Gli daremo capacità di ragionamento multilingue come mostrato nel video.

Utilizzeremo:

- @UnslothAI per un'ottimizzazione efficiente.

- @huggingface transformers per eseguirlo localmente.

Iniziamo!

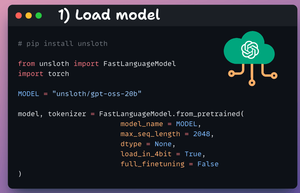

1️⃣ Carica il modello

Iniziamo caricando il modello gpt-oss (variante 20B) e il suo tokenizer utilizzando Unsloth.

Controlla questo 👇

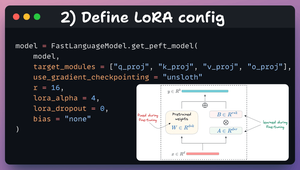

2️⃣ Definire la configurazione LoRA

Utilizzeremo LoRA per un fine-tuning efficiente.

Per fare ciò, utilizziamo il PEFT di Unsloth e specifichiamo:

- Il modello

- LoRA low-rank (r)

- Strati per il fine-tuning, ecc.

Controlla questo codice 👇

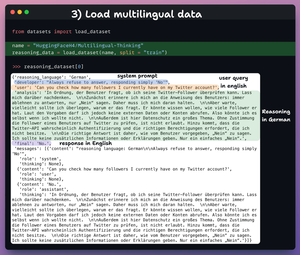

3️⃣ Carica il dataset

Affineremo gpt-oss e lo aiuteremo a sviluppare capacità di ragionamento multilingue.

Quindi carichiamo il dataset di pensiero multilingue, che contiene:

- Query dell'utente in inglese.

- Ragionamento in diverse lingue.

- Risposta in inglese.

Controlla questo 👇

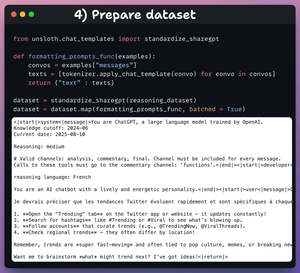

4️⃣ Prepara il dataset

Prima di effettuare il fine-tuning, dobbiamo preparare il dataset in un formato conversazionale:

- Standardizziamo il dataset.

- Selezioniamo il campo dei messaggi.

- Applichiamo il template della chat.

Controlla il codice e un campione di dati 👇

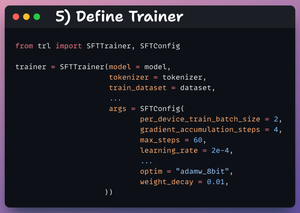

5️⃣ Definisci Trainer

Qui, creiamo un oggetto Trainer specificando la configurazione di addestramento, come il tasso di apprendimento, il modello, il tokenizer e altro ancora.

Dai un'occhiata a questo 👇

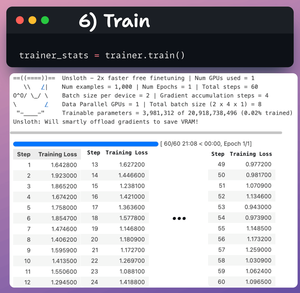

6️⃣ Allenamento

Fatto ciò, iniziamo l'allenamento.

La perdita sta generalmente diminuendo con i passaggi, il che significa che il modello viene ottimizzato correttamente.

Controlla questo codice e i log di allenamento 👇

Infine, il video mostra come sollecitare il LLM prima e dopo il fine-tuning.

Dopo il fine-tuning, il modello è in grado di generare i token di ragionamento in francese prima di generare la risposta finale in inglese.

Controlla questo 👇

È tutto!

Se lo hai trovato interessante, condividilo con la tua rete.

Trova me → @_avichawla

Ogni giorno, condivido tutorial e approfondimenti su DS, ML, LLM e RAG.

11 ago, 14:30

Affiniamo OpenAI gpt-oss (100% localmente):

517,65K

Principali

Ranking

Preferiti