Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

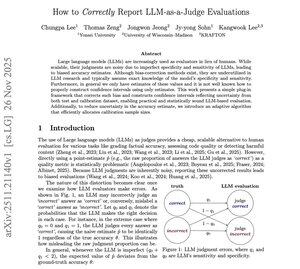

Această lucrare m-a 🤯 șocat

Toată lumea de pe X se laudă mereu cu "LLM-ca-judecător" ca și cum ar fi un oracol magic al adevărului.

Dar această lucrare arată ceva nebunesc:

Majoritatea evaluărilor LLM pe care le-ai văzut sunt părtinitoare de design nu pentru că modelele sunt proaste, ci pentru că judecătorul însuși denaturează discret scorul.

Iată partea ciudată:

Dacă un judecător este puțin slab la a detecta răspunsurile greșite (specificitate scăzută), acest lucru crește acuratețea.

Dacă nu recunoaște răspunsurile corecte (sensibilitate scăzută), îi scade acuratețea.

Același model. Aceleași ieșiri.

Dar ai doi judecători diferiți = două "acuratețe" diferite.

Autorii arată matematica, curbele de eroare și exact momentul în care judecătorul începe să te mintă fără să vrea.

Așa că au construit o soluție:

Un estimator plug-in care ajustează scorul judecat înapoi la scorul real folosind date de calibrare.

Plus un interval de încredere care reflectă în final incertitudinea atât a setului de evaluare, cât și a setului de calibrare.

Iată ce m-a șocat:

Chiar arată cum să aloci eșantioane de calibrare eficient ca să nu irosești bugetul, ceva despre care nimeni nu vorbește în evaluarea LLM.

...

Limită superioară

Clasament

Favorite