Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Den här artikeln chockade mig 🤯

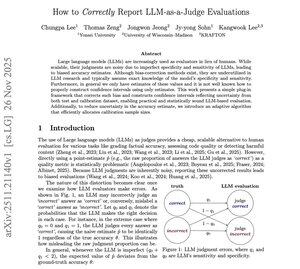

Alla på X skryter om "LLM-som-domare" som om det vore någon magisk sanningsorakel.

Men den här artikeln visar något galet:

De flesta LLM-utvärderingar du sett är avsiktligt partiska inte för att modellerna är dåliga, utan för att domaren själv tyst felrepresenterar poängen.

Här kommer den vilda delen:

Om en domare är lite dålig på att upptäcka felaktiga svar (låg specificitet) blåser det upp noggrannheten.

Om den är lite dålig på att känna igen korrekta svar (låg känslighet) minskar den noggrannheten.

Samma modell. Samma utgångar.

Men du får två olika domare = två olika "noggrannheter".

Författarna visar matematiken, felkurvorna och den exakta punkt där domaren börjar ljuga för dig utan att mena det.

Så de byggde en lösning:

En plug-in-skattare som justerar den bedömda poängen tillbaka till den verkliga poängen med hjälp av kalibreringsdata.

Plus ett konfidensintervall som slutligen speglar osäkerhet från både utvärderingsmängden och kalibreringsmängden.

Här är vad som chockade mig:

De visar till och med hur man effektivt fördelar kalibreringsprov så att man inte slösar budget, något som ingen inom LLM-utvärdering pratar om.

...

Topp

Rankning

Favoriter