Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

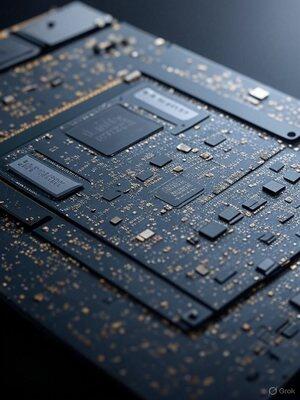

Turbo GPU-uri Nvidia AI: trucuri simple pentru performanțe ultra-rapide

În garajul meu trebuie să fac puțină cercetare și dezvoltare a investitorilor non-VC, să lucrez, să am bănuți și să obțin o viteză mai mare decât companiile cu miliarde. Această constrângere mă face să găsesc modalități de a stoarce mai mult din mai puțin. Fac multe lucruri la care majoritatea nu se pot gândi. Iată un exemplu de doar unul din 100.

GPU-urile sunt puteri, pline de tone de unități de procesare gata să calculeze. Am descoperit Dar de multe ori, nu sunt pe deplin utilizate, ceea ce duce la performanțe lente.

Ce am descoperit? Optimizări inteligente care mențin aceste unități în mișcare, reducând timpii de randare AI și oferind creșteri masive de viteză.

Mai întâi, identificați blocajele.

Folosesc instrumente de profilare precum Nsight de la Nvidia pentru a vedea ce reține lucrurile, fie că este vorba de așteptări de memorie sau alte lucruri. Odată identificat, mă scufund și modific codul pentru a împacheta mai multă muncă în fiecare subiect.

Modificările simple, cum ar fi derularea buclelor sau comprimarea datelor, pot ascunde întârzierile și pot crește debitul, oferind salturi instantanee de viteză.

Utilizarea ridicată poate provoca uneori haos în memoria cache - remediați-l prin reducerea inteligentă a numărului de fire de execuție cu cod fictiv sau modificări de memorie, eliberând resurse pentru sarcini paralele.

Adevăratul schimbător de joc? Calcul asincron. Rulați mai multe sarcini una lângă alta, umplând golurile inactive și suprapunând sarcini grele. Asocierea unei sarcini înfometate de memorie produce multitasking GPU - potențial înjumătățire a timpilor și eficiență de supraalimentare.

Aceste modificări transformă GPU-urile subutilizate în demoni ai vitezei. Nu este diferit de modul în care au transformat computerele personale IBM PC/AT pentru a rula până la 100MHz în 1986, când au ieșit din fabrică la 8MHz.

Voi scrie mai multe detalii despre asta, dar dacă companiile mari de inteligență artificială ar folosi optimizarea GPU Nvidia la nivel de cod operațional, probabil că ar ajunge la AGI, destul de repede.

Când cunoști hardware și software la un nivel aproape atomic, poți reface primele principii.

Limită superioară

Clasament

Favorite