Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

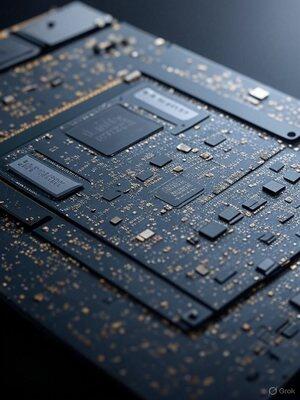

Turbine as GPUs Nvidia AI: truques simples para um desempenho extremamente rápido

Na minha garagem, tenho que fazer o pouco de pesquisa e desenvolvimento de investidores não-VC, funcionar, tenho centavos e obtenho maior velocidade do que empresas com bilhões. Essa restrição me faz encontrar maneiras de extrair mais de menos. Eu faço muitas coisas que a maioria não consegue pensar. Aqui está um exemplo de apenas um dos 100s.

As GPUs são potências, repletas de toneladas de unidades de processamento prontas para processar números. Eu descobri Mas muitas vezes, eles não são totalmente utilizados, levando a um desempenho lento.

O que eu descobri? Otimizações inteligentes que mantêm essas unidades zumbindo, reduzindo os tempos de renderização da IA e proporcionando grandes aumentos de velocidade.

Primeiro, identifique os gargalos.

Eu uso ferramentas de criação de perfil como o Nsight da Nvidia para ver o que está impedindo as coisas, sejam esperas de memória ou outras coisas. Uma vez identificado, eu mergulho e ajusto o código para incluir mais trabalho em cada thread.

Alterações simples, como desenrolar loops ou compactar dados, podem ocultar atrasos e aumentar a taxa de transferência, proporcionando saltos de velocidade instantâneos.

Às vezes, o alto uso pode causar caos no cache - corrija-o reduzindo de forma inteligente a contagem de threads com código fictício ou ajustes de memória, liberando recursos para tarefas paralelas.

A verdadeira virada de jogo? Computação assíncrona. Execute várias tarefas lado a lado, preenchendo lacunas ociosas e sobrepondo cargas pesadas. Emparelhar tarefas que consomem muita memória produz multitarefa da GPU - potencialmente reduzindo pela metade os tempos e aumentando a eficiência.

Esses ajustes transformam GPUs subutilizadas em demônios da velocidade. Não é diferente de como transformou os computadores pessoais IBM PC / ATs para rodar até 100 MHz em 1986, quando saíram da fábrica a 8 MHz.

Vou escrever mais detalhes sobre isso, mas se grandes empresas de IA usassem minha otimização de GPU Nvidia de nível de código operacional, elas provavelmente alcançariam a AGI rapidamente.

Quando você conhece hardware e software em um nível quase atômico, pode refazer os primeiros princípios.

Melhores

Classificação

Favoritos