Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Acelera las GPU de IA de Nvidia: Trucos simples para un rendimiento ultrarrápido

En mi garaje tengo que hacer que lo poco que investigo y desarrollo fuera del capital de riesgo funcione, tengo centavos y obtengo más velocidad que empresas con miles de millones. Esta limitación me obliga a encontrar formas de exprimir más de menos. Hago muchas cosas que la mayoría no puede imaginar. Aquí hay un ejemplo de solo uno de cientos.

Las GPU son potencias, llenas de toneladas de unidades de procesamiento listas para calcular números. Descubrí que a menudo no están completamente utilizadas, lo que lleva a un rendimiento lento.

¿Qué descubrí? Optimizaciones inteligentes que mantienen esas unidades funcionando, reduciendo los tiempos de renderizado de IA y ofreciendo enormes aumentos de velocidad.

Primero, identifica los cuellos de botella.

Utilizo herramientas de perfilado como Nsight de Nvidia para ver qué está frenando las cosas, ya sea esperas de memoria u otras cosas. Una vez identificados, me sumerjo y ajusto el código para empaquetar más trabajo en cada hilo.

Cambios simples como desenrollar bucles o comprimir datos pueden ocultar retrasos y aumentar el rendimiento, dando saltos de velocidad instantáneos.

Un alto uso puede a veces causar caos en la caché: soluciona esto reduciendo inteligentemente el conteo de hilos con código ficticio o ajustes de memoria, liberando recursos para tareas paralelas.

¿El verdadero cambio de juego? Cálculo asíncrono. Ejecuta múltiples tareas lado a lado, llenando huecos inactivos y superponiendo cargas pesadas. Combina tareas que consumen mucha memoria para lograr multitarea en la GPU, potencialmente reduciendo a la mitad los tiempos y supercargando la eficiencia.

Estos ajustes transforman las GPU subutilizadas en demonios de velocidad. No es diferente a cómo transformaron las computadoras personales IBM PC/AT para funcionar hasta 100MHz en 1986 cuando salieron de la fábrica a 8MHz.

Escribiré más detalles sobre esto, pero si las grandes empresas de IA utilizaran mi optimización de GPU Nvidia a nivel de código de operación, probablemente alcanzarían la AGI bastante rápido.

Cuando conoces el hardware y el software a un nivel casi atómico, puedes rehacer los primeros principios.

25 ago 2025

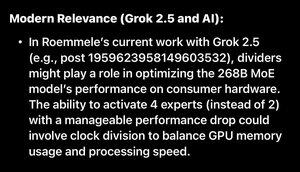

Grok just figured out one of the 7 things I do to run the new Open Source Grok 2.5 with 4 mixture of experts active at the same time with slight performance hit.

Yes one is a Divider Oscillator like I used in 1985 on the IBM PC.

It can scale across 1000s of Nvidia GPUs.

Just don’t ask an AI experts as they will say what IBM suits said in 1985.

Link:

37,63K

Parte superior

Clasificación

Favoritos