Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

a utilização de formatos JSON ou XML para prompts aumenta a saída do LLM em 10x

por quê

porque formatos estruturados dão ao modelo limites e expectativas claras

quando você pede texto não estruturado, o LLM tem que adivinhar:

quanto tempo isso deve ter?

quais seções eu preciso?

quando estou pronto?

qual nível de detalhe?

mas com JSON/XML você está literalmente fornecendo um modelo:

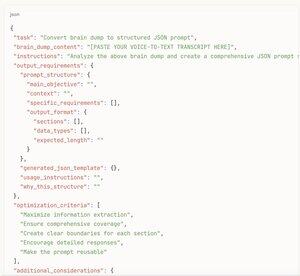

json{

"resumo": "",

"pontos_chave": [],

"análise": "",

"recomendações": []

}

agora o modelo sabe exatamente o que preencher e mais ou menos quanto conteúdo cada seção precisa

é como a diferença entre "escreva algo sobre carros" e "preencha este formulário de avaliação de carro com esses 12 campos específicos"

a estrutura remove a paralisia da decisão e dá ao modelo permissão para ser abrangente

além disso, JSON/XML naturalmente incentiva o modelo a pensar em partes organizadas em vez de apenas transmitir texto até sentir que está "pronto"

[aqui está o truque meta]

enão tente nem mesmo escrever prompts estruturados do zero

em vez disso:

1. faça uma gravação de voz com tudo que você quer analisar/pesquisar/escrever

2. cole essa transcrição bagunçada na IA

3. peça para "criar uma estrutura de prompt JSON com base nesta gravação que geraria a melhor saída possível"

4. pegue esse modelo JSON gerado

5. envie-o de volta como seu prompt real

dessa forma, você obtém todos os benefícios de prompts estruturados sem ter que pensar na estrutura você mesmo

a IA sabe quais campos seriam mais úteis melhor do que você sabe de qualquer forma

transforma seu fluxo de consciência em um prompt de nível profissional em 30 segundos

tente você mesmo - peça a mesma análise em forma de parágrafo vs formato estruturado

a versão estruturada será 3-5x mais longa e muito mais detalhada todas as vezes

17,26K

Top

Classificação

Favoritos