トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

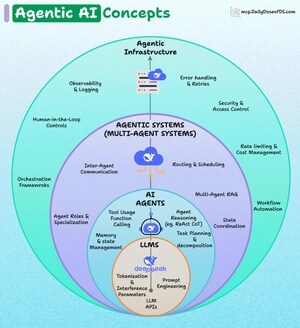

Agentic AI の主要な概念の階層化された概要。

それを層ごとに理解しましょう。

1) LLM (基盤層)

中核となるのは、GPT、DeepSeek などの LLM です。

ここでの核となるアイデア:

- トークン化と推論パラメータ: テキストがトークンに分割され、モデルによって処理される方法。

- プロンプトエンジニアリング:より良い出力を得るために入力を設計します。

- LLM API: モデルと対話するためのプログラム インターフェイス。

これは、他のすべてに動力を供給するエンジンです。

2) AI エージェント (LLM 上に構築)

エージェントは LLM を包み込み、自律的に行動する能力を与えます。

主な責任:

- ツールの使用と関数呼び出し: LLM を外部 API/ツールに接続します。

- エージェント推論:ReAct(推論+行為)やChain-of-Thoughtなどの推論方法。

- タスクの計画と分解: 大きなタスクを小さなタスクに分割します。

- メモリ管理: 履歴、コンテキスト、長期情報を追跡します。

エージェントは、LLM を現実世界のワークフローで役立たせる頭脳です。

3) エージェントシステム(マルチエージェントシステム)

複数のエージェントを組み合わせると、エージェントシステムが得られます。

顔立ち:

- エージェント間通信: エージェント同士が通信し、必要に応じて ACP、A2A などのプロトコルを利用します。

- ルーティングとスケジューリング: どのエージェントがいつ何を処理するかを決定します。

- 状態の調整: 複数のエージェントがコラボレーションする際の一貫性を確保します。

- マルチエージェント RAG: エージェント間で検索拡張生成を使用します。

- エージェントの役割と専門化: 独自の目的を持つエージェント

- オーケストレーションフレームワーク:ワークフローを構築するためのツール(CrewAIなど)。

この層は、エージェント間のコラボレーションと調整に関するものです。

4) エージェントインフラストラクチャ

最上層は、これらのシステムの堅牢性、拡張性、安全性を保証します。

これも:

- オブザーバビリティとロギング: パフォーマンスと出力を追跡します (DeepEval などのフレームワークを使用)。

- エラー処理と再試行: 障害に対する回復力。

- セキュリティとアクセス制御: エージェントが越えないようにします。

- レート制限とコスト管理: リソース使用量を制御します。

- ワークフローの自動化: エージェントをより広範なパイプラインに統合します。

- ヒューマン・イン・ザ・ループ制御: 人間の監視と介入を可能にします。

このレイヤーは、エンタープライズ/本番環境の信頼性、安全性、およびスケーラビリティを保証します。

エージェント AI には全体として、スタック アーキテクチャが含まれており、各外層が内層に信頼性、調整、ガバナンスを追加します。

73.05K

トップ

ランキング

お気に入り