Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kto wynalazł konwolucyjne sieci neuronowe (CNN)?

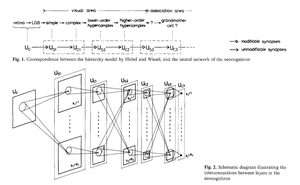

1969: Fukushima miał ReLU związane z CNN [2].

1979: Fukushima miał podstawową architekturę CNN z warstwami konwolucyjnymi i warstwami redukcji wymiarów [1]. Obliczenia były 100 razy droższe niż w 1989 roku, a miliard razy droższe niż dzisiaj.

1987: Waibel zastosował wagi dzielone w TDNN z jednowymiarowymi konwolucjami, korzystając z wstecznej propagacji Linnainmaa z 1970 roku [3] [4].

1988: Wei Zhang i in. zastosowali "nowoczesne" CNN trenowane wsteczną propagacją do rozpoznawania znaków [5].

Wszystko powyższe zostało opublikowane w Japonii w latach 1979-1988.

1989: LeCun i in. ponownie zastosowali CNN do rozpoznawania znaków (kodów pocztowych) [6,10].

1990-93: Redukcja wymiarów Fukushimy oparta na uśrednianiu przestrzennym [1] została zastąpiona przez max-pooling dla 1-D TDNN (Yamaguchi i in.) [7] oraz 2-D CNN (Weng i in.) [8].

2011: Dużo później, mój zespół z Danem Ciresanem sprawił, że max-pooling CNN stały się naprawdę szybkie na GPU NVIDIA. W 2011 roku DanNet osiągnął pierwszy superludzki wynik w rozpoznawaniu wzorców [9]. Przez pewien czas cieszył się monopolem: od maja 2011 do września 2012 DanNet wygrał każde wyzwanie w rozpoznawaniu obrazów, w tym 4 z rzędu. Należy jednak przyznać, że w dużej mierze chodziło o inżynierię i skalowanie podstawowych spostrzeżeń z poprzedniego tysiąclecia, korzystając z dużo szybszego sprzętu.

Niektórzy "eksperci AI" twierdzą, że "sprawienie, by CNN działały" (np. [5,6,9]) było tak samo ważne, jak ich wynalezienie. Ale "sprawienie, by działały" w dużej mierze zależało od tego, czy twoje laboratorium było wystarczająco bogate, aby kupić najnowsze komputery potrzebne do skalowania oryginalnej pracy. To samo dotyczy dzisiaj. Podstawowe badania vs inżynieria/rozwój - R vs D w R&D.

REFERENCJE

[1] K. Fukushima (1979). Model sieci neuronowej dla mechanizmu rozpoznawania wzorców, niepodlegającego przesunięciu pozycji — Neocognitron. Trans. IECE, vol. J62-A, nr 10, s. 658-665, 1979.

[2] K. Fukushima (1969). Ekstrakcja cech wizualnych przez sieć z wieloma warstwami elementów progowych analogowych. IEEE Transactions on Systems Science and Cybernetics. 5 (4): 322-333. Ta praca wprowadziła prostokątne jednostki liniowe (ReLU), obecnie używane w wielu CNN.

[3] S. Linnainmaa (1970). Praca magisterska, Uniwersytet w Helsinkach, 1970. Pierwsza publikacja na temat "nowoczesnej" wstecznej propagacji, znanej również jako odwrotna metoda automatycznej różnicowania. (Zobacz znany przegląd wstecznej propagacji Schmidhubera: "Kto wynalazł wsteczną propagację?")

[4] A. Waibel. Rozpoznawanie fonemów przy użyciu sieci neuronowych z opóźnieniem czasowym. Spotkanie IEICE, Tokio, Japonia, 1987. Wsteczna propagacja dla TDNN z wagami dzielonymi z jednowymiarowymi konwolucjami.

[5] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka. Sieć neuronowa do rozpoznawania wzorców niezmiennych na przesunięcie i jej optyczna architektura. Proc. Annual Conference of the Japan Society of Applied Physics, 1988. Pierwsze CNN trenowane wsteczną propagacją w 2 wymiarach, z zastosowaniami do rozpoznawania znaków angielskich.

[6] Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, L. D. Jackel: Wsteczna propagacja zastosowana do rozpoznawania odręcznych kodów pocztowych, Neural Computation, 1(4):541-551, 1989. Zobacz także sekcję 3 [10].

[7] K. Yamaguchi, K. Sakamoto, A. Kenji, T. Akabane, Y. Fujimoto. Sieć neuronowa do rozpoznawania izolowanych słów niezależnych od mówcy. Pierwsza Międzynarodowa Konferencja na temat Przetwarzania Języka Mówionego (ICSLP 90), Kobe, Japonia, listopad 1990. Jednowymiarowy TDNN z konwolucjami używającymi Max-Poolingu zamiast uśredniania przestrzennego Fukushimy [1].

[8] Weng, J., Ahuja, N., i Huang, T. S. (1993). Uczenie rozpoznawania i segmentacji obiektów 3D z obrazów 2D. Proc. 4th Intl. Conf. Computer Vision, Berlin, s. 121-128. Dwuwymiarowe CNN, których warstwy redukcji wymiarów używają Max-Poolingu (który stał się bardzo popularny) zamiast uśredniania przestrzennego Fukushimy [1].

[9] W 2011 roku szybkie i głębokie CNN oparte na GPU, zwane DanNet (7+ warstw), osiągnęły pierwszy superludzki wynik w konkursie wizji komputerowej. Zobacz przegląd: "2011: DanNet wywołuje rewolucję głębokich CNN."

[10] Jak 3 laureatów nagrody Turinga opublikowało kluczowe metody i pomysły, których twórców nie uznali. Raport techniczny IDSIA-23-23, Szwajcarskie Laboratorium AI IDSIA, 14 grudnia 2023. Zobacz także film na YouTube z ceremonii wręczenia nagrody Bower 2021: J. Schmidhuber chwali Kunihiko Fukushimę.

346,79K

Najlepsze

Ranking

Ulubione