熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

好奇 SFT 在上下文學習中的表現如何。

ICL 感覺像黑魔法——模型確實以人類樣本效率獲取了一堆隱性信息。

如果微調能接近這一點,也許你可以拼湊出一些感覺像是持續學習的東西?

這是一個幼稚的想法:內循環,對會話摘要進行 SFT。外循環,長時間範圍的強化學習,模型必須利用在會話之間傳遞的技能和知識。外循環基本上將 SFT 視為工具調用,激勵模型儘可能傳遞儘可能多的重要信息。

我很好奇,像這樣拼湊現有技術的東西是否足以實現持續學習,或者我們是否需要一個全新的範式。

我用 ChatGPT 做了一個有趣的費米估算,以便對這個問題有一些直覺。

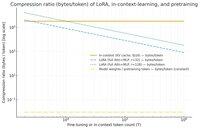

你可以問的問題是,SFT(通過 LoRA)相對於上下文學習壓縮了多少信息?並且為了好玩,和預訓練進行比較。

如果存在巨大的差異(即 KV 緩存使用的字節數與 LoRA 權重相比多出很多倍),那麼這 *可能* 表明 LoRA 很難像 ICL 那樣豐富和樣本高效。

再說一次,這只是個超級模糊的下午兔子洞,不是嚴肅的調查。僅僅因為它使用的內存少得多,並不一定意味著它更笨,等等。

這個圖是針對 Llama 3 70 b(預訓練於 15 萬億個標記)。

一旦我們達到單個千個標記,LoRA(其大小不會隨著你微調的標記數量而變化)開始需要比 ICL 更密集地壓縮。

一旦你有 100k 個標記,通過一個秩為 32 的 LoRA 的標記被壓縮的程度是如果它們在上下文中被關注(通過 KV 緩存)時的 37 倍。

附帶說明:預訓練的每個訓練標記的字節數非常低!(在這種情況下為 0.009)。

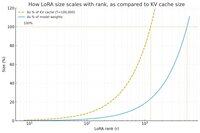

又做了個圖,這次將標記數量保持在 100k,並改變 LoRA 的秩。

幼稚地說,秩應該足夠小,以至於它僅占總模型權重的一小部分(否則,為什麼要使用 LoRA?),但也要足夠大,以包含 KV 緩存中存儲的相當數量的信息。所以你可以看到那個甜蜜點可能在哪裡。

無論如何,這些圖並沒有得出任何結論。請原諒任何尷尬的錯誤或誤解。

渴望獲得關於將 SFT 和 RL 拼湊在一起在會話之間實現我們在上下文學習中看到的持續學習的效果的實際高層次看法。

40.85K

熱門

排行

收藏