熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

Jürgen Schmidhuber

發明瞭元學習 (1987)、GAN (1990)、Transformers (1991)、非常深度學習 (1991) 等的原理。我們的 AI 每天被使用數十億次。

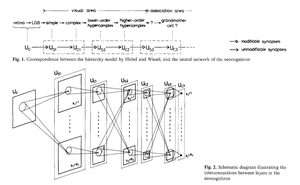

誰發明了卷積神經網絡(CNN)?

1969年:福島提出了與CNN相關的ReLU。

1979年:福島擁有基本的CNN架構,包括卷積層和下採樣層。當時的計算成本是1989年的100倍,今天的10億倍。

1987年:瓦伊貝爾將林奈馬的1970年反向傳播應用於具有一維卷積的權重共享TDNN。

1988年:張偉等人將“現代”反向傳播訓練的二維CNN應用於字符識別。

以上所有內容均於1979年至1988年在日本發表。

1989年:LeCun等人再次將CNN應用於字符識別(郵政編碼)。

1990-93年:福島基於空間平均的下採樣被最大池化取代,應用於一維TDNN(山口等人)和二維CNN(翁等人)。

2011年:更晚些時候,我的團隊與丹·西雷森一起使最大池化CNN在NVIDIA GPU上變得非常快速。2011年,DanNet實現了首個超人類模式識別結果。曾經一度,它享有壟斷地位:從2011年5月到2012年9月,DanNet贏得了它參加的每一個圖像識別挑戰,連續贏得4次。誠然,這主要是關於工程和擴展前千年的基本見解,並從更快的硬件中獲利。

一些“AI專家”聲稱“使CNN運作”(例如,參見[5,6,9])與發明它們一樣重要。但“使它們運作”在很大程度上取決於你的實驗室是否有足夠的資金購買最新的計算機,以擴展原始工作。這與今天是相同的。基礎研究與工程/開發 - 研發中的R與D。

參考文獻

[1] K. Fukushima (1979)。一種不受位置變化影響的模式識別機制的神經網絡模型 - Neocognitron。IECE轉載,第J62-A卷,第10期,第658-665頁,1979年。

[2] K. Fukushima (1969)。通過多層網絡的視覺特徵提取 - 類比閾值元件。IEEE系統科學與控制論學報。5 (4):322-333。這項工作引入了修正線性單元(ReLU),現在在許多CNN中使用。

[3] S. Linnainmaa (1970)。碩士論文,赫爾辛基大學,1970年。第一篇關於“現代”反向傳播的出版物,也稱為自動微分的反向模式。(參見施密德胡伯的著名反向傳播概述:“誰發明了反向傳播?”)

[4] A. Waibel。使用時間延遲神經網絡的音素識別。IEICE會議,東京,日本,1987年。對具有一維卷積的權重共享TDNN的反向傳播。

[5] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka。平移不變模式識別神經網絡及其光學架構。日本應用物理學會年會論文集,1988年。第一個反向傳播訓練的二維CNN,應用於英文字母識別。

[6] Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, L. D. Jackel:反向傳播應用於手寫郵政編碼識別,神經計算,1(4):541-551,1989年。另見[10]的第3節。

[7] K. Yamaguchi, K. Sakamoto, A. Kenji, T. Akabane, Y. Fujimoto。獨立於說話者的孤立詞識別神經網絡。第一屆國際語音處理會議(ICSLP 90),日本神戶,1990年。使用最大池化而非福島的空間平均的1維卷積TDNN。

[8] Weng, J., Ahuja, N., 和 Huang, T. S. (1993)。從2D圖像學習3D物體的識別和分割。第4屆國際計算機視覺會議論文集,柏林,第121-128頁。使用最大池化的二維CNN,其下採樣層取代了福島的空間平均。

[9] 2011年,快速且深度的基於GPU的CNN DanNet(7層以上)在計算機視覺比賽中實現了首個超人類性能。參見概述:“2011年:DanNet引發深度CNN革命。”

[10] 三位圖靈獎得主如何重新發表關鍵方法和思想,而未能給予創造者應有的信譽。技術報告IDSIA-23-23,瑞士人工智慧實驗室IDSIA,2023年12月14日。另見2021年Bower獎頒獎典禮的YouTube視頻:J. Schmidhuber讚揚福島邦彦。

346.8K

誰發明了反向傳播(BP)?其現代版本(也稱為自動微分的反向模式)於1970年由芬蘭碩士生Seppo Linnainmaa首次發表。BP的前身由Henry J. Kelley於1960年發表。BP在神經網絡中的首次具體應用由Paul Werbos於1982年描述(但並未在他1974年的論文中提及,這一點有時會被誤傳)。

有些人問:"反向傳播不就是萊布尼茨(1676)的鏈式法則嗎?"不,這是將鏈式法則有效應用於具有可微節點的大型網絡的方式。(也有許多低效的做法。)直到1970年才發表。

請參見反向傳播概述網頁以獲取更多詳細信息:

另請參見《現代人工智慧與深度學習的註釋歷史》(2022):

34.52K

10年前,即 2015 年 5 月,我們發佈了第一個具有數百層(以前的 FNN 最多有幾十層)的基於梯度的非常深的前饋神經網路 (FNN)。為了克服梯度消失問題,我們的 Highway Networks 使用 @HochreiterSepp 於 1991 年首次引入的殘差連接來實現遞歸 NN (RNN) 中的恆定誤差流,通過類似於我們非常深的 LSTM RNN 的遺忘門(Gers et al., 1999)的乘法門進行門控。高速公路 NN 是通過我以前的博士生 @rupspace 和 Klaus Greff 的工作實現的。將 Highway NN gates 設置為 1.0 實際上會得到 7 個月後發布的 ResNet。

深度學習就是關於 NN 深度的。LSTM 為遞迴 NN 帶來了基本上無限的深度;Highway Nets 將其帶到前饋 NN。

20.77K

1991 年:第一次神經網络蒸餾 [1-3]。那時我稱之為 「崩潰」,而不是 「蒸餾」。。

引用

[1] J. Schmidhuber (1991 年)。神經序列分塊器。技術報告 FKI-148-91,慕尼克科技大學。第3.2.2節。& Sec. 4是關於將神經網路的知識“摺疊”或“蒸餾”或“壓縮”到另一個神經網络中。

[2] JS (1992 年)。使用歷史壓縮原理學習複雜的擴展序列。神經計算,4(2):234-242,1992 年。基於 [1]。

[3] JS(AI 博客,2021 年,2025 年更新)。1991年:第一個採用無監督預訓練的非常深入的學習。第一個神經網路蒸餾。

16.25K

AGI?有一天,但還沒有。目前唯一運行良好的 AI 是螢幕後面的 AI [12-17]。但是,與現實世界中真實機器人的 Real AI 相比,通過螢幕后的圖靈測試 [9] 很容易。目前沒有人工智慧驅動的機器人可以被認證為水管工 [13-17]。因此,圖靈測試不是衡量智力的好方法(智商也不是)。而沒有掌握物理世界的 AGI 就不是 AGI。這就是為什麼我在 2004 年創建了用於學習機器人的 TUM CogBotLab [5],在 2014 年與他人共同創立了一家物理世界人工智慧公司 [6],並在 TUM、IDSIA 和現在的 KAUST 組建了團隊,致力於開發嬰兒機器人 [4,10-11,18]。這種軟體機器人不僅僅是盲目地模仿人類,它們也不像 LLM/VLM 那樣僅僅通過下載網路來工作。相反,他們利用人工好奇心的原理來改進他們的神經世界模型(我在 1990 年使用了這兩個術語 [1-4])。這些機器人使用大量感測器工作,但只有較弱的致動器,因此當它們通過設計和運行自己發明的實驗來收集有用的數據時,它們不會輕易傷害自己[18]。

值得注意的是,自 1970 年代以來,許多人取笑我的舊目標,即建立一個比我更聰明的自我提升的 AGI,然後退休。然而,最近,許多人終於開始認真對待這個問題,現在他們中的一些人突然變得過於樂觀了。這些人往往沒有意識到我們必須解決的剩餘挑戰才能實現真正的 AI。我的 2024 年 TED 演講 [15] 總結了其中的一些內容。

參考資料(在網上很容易找到):

[1] J. Schmidhuber。使世界可微分:關於在非平穩環境中使用完全遞歸的自我監督神經網路 (NN) 進行動態強化學習和規劃。TR FKI-126-90,TUM,1990 年 2 月,1990 年 11 月修訂。本文還通過生成對抗網路引入了人工好奇心和內在動機,其中生成器 NN 在最小極大遊戲中與預測器 NN 戰鬥。

[2] J. S.在模型構建神經控制器中實現好奇心和無聊的可能性。在 J. A. Meyer 和 SW Wilson 主編的《適應性行為類比國際會議論文集:從動物到動畫》中,第 222-227 頁。麻省理工學院出版社/布拉德福德圖書公司,1991 年。基於 [1]。

[3] JS AI 博客 (2020)。1990年:使用迴圈世界模型和人工好奇心進行規劃和強化學習。總結了 [1][2] 和許多後來的論文,包括 [7][8]。

[4] J.S. AI 博客 (2021):自 1990 年以來的人工好奇心和創造力。總結了 [1][2] 和許多後來的論文,包括 [7][8]。

[5] J.S. TU Munich CogBotLab 學習機器人實驗室 (2004-2009)

[6] NNAISENSE,成立於 2014 年,致力於物理世界的 AI

[7] JS (2015 年)。關於學會思考:強化學習 (RL) 控制器和遞歸神經世界模型新組合的演算法資訊論。arXiv 1210.0118。第 5.3 節描述了一個 RL 提示工程師,它學習查詢其模型以進行抽象推理、規劃和決策。今天,這被稱為 「思維鏈」。。

[8] JS (2018 年)。一張大網萬物。arXiv 1802.08864。另請參見專利US11853886B2和我的 DeepSeek 推文:DeepSeek 使用了 2015 年強化學習提示工程師 [7] 及其 2018 年改進 [8] 的元素,它將 RL 機器和世界模型 [7] 摺疊成一個網络。這使用了我 1991 年的神經網路蒸餾程式:一個提煉的思維鏈系統。

[9] J.S. 圖靈超賣。不過,這不是圖靈的錯。AI 博客(2021 年,在 Hacker News 上是 #1)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein.(智慧機器人會對生活著迷。F.A.Z.,2015 年

[11] J.S. 在 Falling Walls:人工智慧的過去、現在和未來。科學美國人,觀察,2017 年。

[12] J.S. KI ist eine Riesenchance für Deutschland.(AI 對德國來說是一個巨大的機會。F.A.Z.,2018 年

[13] H. 鐘斯。J.S. 說他畢生的工作不會導致反烏托邦。福布斯雜誌,2023年。

[14] J.S. Jazzyear 訪談,上海,2024 年。

[15] J.S. TED 在維也納 TED AI 上的演講(2024 年):為什麼 2042 年將是 AI 的重要一年。請參閱隨附的視頻剪輯。

[16] J.S. Baut den KI-gesteuerten Allzweckroboter!(構建 AI 控制的通用機器人!F.A.Z., 2024 年

[17] J.S. 1995-2025:德國和日本的衰落與美國和中國的對比。通用機器人能否推動捲土重來?AI 博客,2025 年 1 月,基於 [16]。

[18] M. Alhakami, DR Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber.邁向具有豐富交互能力的極其健壯的嬰兒機器人,適用於先進的機器學習演算法。預印本 arxiv 2404.08093,2024 年。

67.28K

熱門

排行

收藏

鏈上熱點

X 熱門榜

近期融資

最受認可