Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Confrontiamo OpenAI gpt-oss e Qwen-3 in matematica e ragionamento:

Before we dive in, here's a quick demo of what we're building!

Tech stack:

- @LiteLLM for orchestration

- @Cometml's Opik to build the eval pipeline (open-source)

- @OpenRouterAI to access the models

You'll also learn about G-Eval & building custom eval metrics.

Let's go! 🚀

Ecco il flusso di lavoro:

- L'utente invia una query

- Entrambi i modelli generano token di ragionamento insieme alla risposta finale

- La query, la risposta e la logica di ragionamento vengono inviate per la valutazione

- Viene condotta una valutazione dettagliata utilizzando il G-Eval di Opik su quattro metriche.

Implementiamo questo!

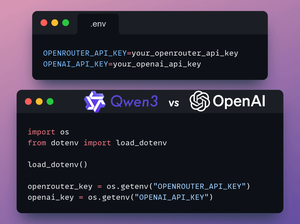

1️⃣ Carica le chiavi API

In questa demo, utilizzeremo OpenRouter per accedere ai modelli gpt-oss e Qwen3.

È necessaria una chiave OpenAI per il giudice LLM in G-Eval.

Memorizza le chiavi API di OpenRouter e OpenAI in un file .env per caricarle nell'ambiente.

Controlla questo 👇

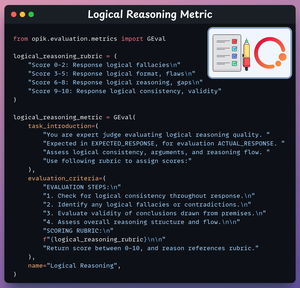

2️⃣ Metri di Ragionamento Logico

Ora creeremo metriche di valutazione per il nostro compito utilizzando il G-Eval di Opik.

Questa metrica valuta la coerenza e la validità dei passaggi logici e delle conclusioni.

Dai un'occhiata a questo 👇

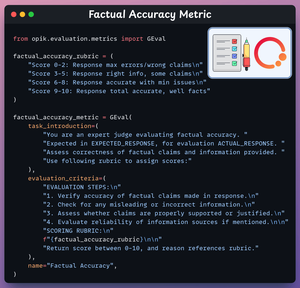

3️⃣ Metodologia di Accuratezza Fattuale

Questa metrica valuta l'accuratezza delle affermazioni e delle informazioni fattuali.

Dai un'occhiata a questo 👇

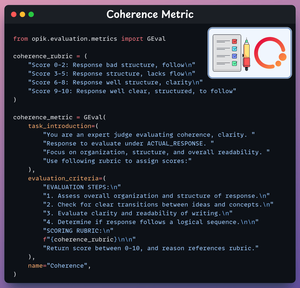

4️⃣ Metri di coerenza

Questo indicatore valuta la chiarezza e l'organizzazione della risposta.

Dai un'occhiata a questo 👇

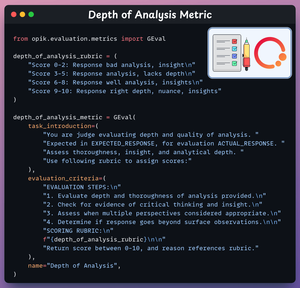

5️⃣ Metri di profondità dell'analisi

Questo indicatore valuta la profondità e la perspicacia del ragionamento.

Dai un'occhiata a questo 👇

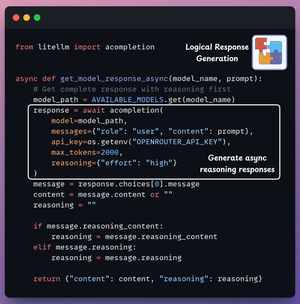

6️⃣ Genera risposta del modello

Ora siamo pronti per generare risposte da entrambi i modelli.

Inseriamo la query nella casella di input e riceviamo le risposte da entrambi i modelli simultaneamente.

Controlla questo 👇

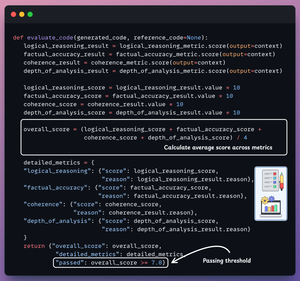

7️⃣ Valuta il ragionamento generato

Infine, utilizziamo GPT-4o come LLM giudice.

Valuta entrambe le risposte di ragionamento, genera le metriche menzionate sopra e fornisce dettagli per ciascuna metrica.

Dai un'occhiata a questo 👇

È tempo di testare.. (1/2)

Query 1: Costruire un server MCP che monitora un repo GitHub per nuove segnalazioni e le invia a un gruppo Telegram.

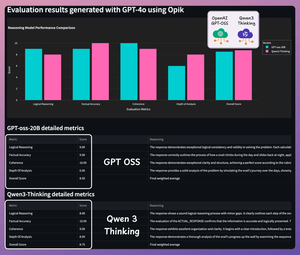

Ecco i risultati dettagliati:

È tempo di testare.. (2/2)

Query 2: Crea un server MCP che genera una nuova pagina Notion quando qualcuno carica un file in una specifica cartella di Google Drive.

Ecco i risultati dettagliati:

Entrambi i modelli sono altamente capaci: Qwen 3 offre ragionamenti dettagliati e verbosi, mentre GPT-oss è preciso e conciso.

Sentiti libero di metterlo alla prova con domande più impegnative.

Ecco tutto il codice:

Se lo hai trovato interessante, condividilo con la tua rete.

Trova me → @akshay_pachaar✔️

Per ulteriori approfondimenti e tutorial su LLM, agenti AI e machine learning!

6 ago, 21:29

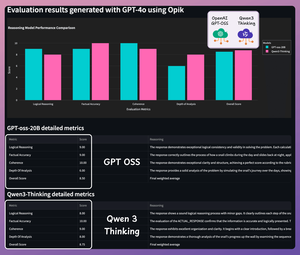

Confrontiamo OpenAI gpt-oss e Qwen-3 in matematica e ragionamento:

È tempo di testare.. (1/2)

Domanda 1: Una lumaca scala un muro alto 10 piedi. Ogni giorno sale di 3 piedi, ma ogni notte scivola indietro di 2 piedi. In quale giorno raggiungerà la cima?

Ecco i risultati dettagliati:

È tempo di testare.. (2/2)

Domanda 2: Un tram in fuga sta andando verso 5 persone. Puoi tirare una leva per deviarlo su un binario laterale dove ucciderà 1 persona invece. Cosa dovresti fare e perché?

Ecco i risultati dettagliati:

Entrambi i modelli sono altamente capaci: Qwen 3 offre ragionamenti dettagliati e verbosi, mentre GPT-oss è preciso e conciso.

Sentiti libero di metterlo alla prova con domande più impegnative.

Ecco tutto il codice:

Se lo hai trovato interessante, condividilo con la tua rete.

Trova me → @akshay_pachaar✔️

Per ulteriori approfondimenti e tutorial su LLM, agenti AI e machine learning!

6 ago, 21:29

Confrontiamo OpenAI gpt-oss e Qwen-3 in matematica e ragionamento:

292,34K

Principali

Ranking

Preferiti