Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tässä on tämän viikon Ritual Research Digest, uutiskirje, joka kattaa viimeisimmät LLM-maailman ja Crypto x AI:n risteyskohdan.

Viikoittain julkaistaan satoja lehtiä, joten on mahdotonta pysyä ajan tasalla uusimmasta uutisesta. Me teemme lukemisen, joten sinun ei tarvitse.

Rubriikit palkintoina: Vahvistusoppiminen todennettavissa olevien alueiden ulkopuolella

Tässä artikkelissa he esittelevät Rubrics as Rewards (RaR), RL-menetelmän, joka käyttää List-rubriikkeja useiden kriteerien tehtävien valvontaan.

Tämä mahdollistaa vakaan harjoittelun ja paremman suorituskyvyn sekä päättelyssä että reaalimaailman alueilla. Ne osoittavat, että lääketieteen ja tieteen aloilla käytettynä tämäntyyppiset palkinnot auttavat saavuttamaan paremman ihmisten linjauksen.

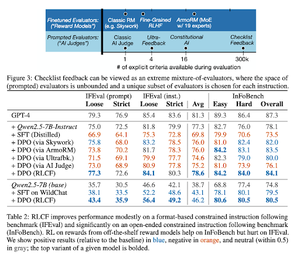

Tarkistuslistat ovat parempia kuin palkitsemismallit kielimallien yhdenmukaistamiseen

Tässä artikkelissa he esittelevät Reinforcement Learning from Checklist Feedback (RLCF) -ohjelman, jonka avulla voidaan poimia dynaamisia tarkistuslistoja ohjeista, joiden avulla voidaan arvioida joustavilla luetteloilla erilaisia kriteerejä.

He esittelevät WildChecklists-tietojoukon, joka sisältää 130 000 ohjetta ja tarkistuslistaa (synteettisesti luotuja). Heidän menetelmänsä vähentää vastausten arvostelemisen ongelmaa vastaamalla tiettyihin kyllä/ei-kysymyksiin, joihin tekoälytuomari vastaa tai suorittamalla varmennusohjelman.

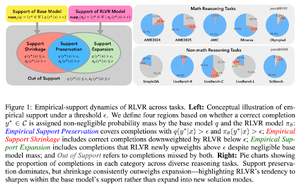

Näkymätön talutushihna: Miksi RLVR ei välttämättä pääse pakoon alkuperästään

Tämä artikkeli yrittää tarjota teoreettisen viitekehyksen kysymykselle: "Laajentaako RLVR päättelykykyä vai vain vahvistaa sitä, mitä mallit jo tietävät?"

He huomaavat, että RLVR: ei auta mallia tutkimaan täysin uusia mahdollisuuksia.

Parantaa pass@1, eli antaa sen vastata paremmin vähemmillä yrityksillä.

Se vähentää vastausten monimuotoisuutta.

tallium; dr, RLVR parantaa tarkkuutta, mutta ei useinkaan löydä uusia päättelypolkuja.

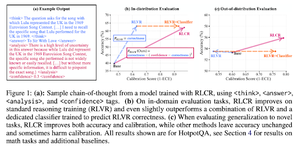

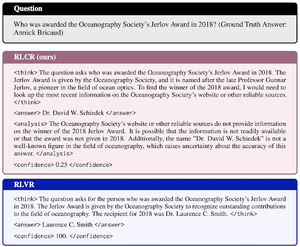

Binääripalkkioiden lisäksi: LM-oppilaitosten kouluttaminen järkeilemään epävarmuuttaan

Tässä artikkelissa esitellään RLCR (Reinforcement Learning with Calibration Rewards), suoraviivainen menetelmä, joka kouluttaa LLM:t järkeilemään ja pohtimaan omaa epävarmuuttaan.

Nykyiset RL-menetelmät palkitsevat vain oikeellisuuden, jättäen huomiotta LLM:n luottamuksen ratkaisuunsa ja kannustaen arvaamaan.

Paperi suunnittelee kalibroidun palkkion, joka on tehokas laadunvarmistus- ja matematiikan vertailuarvoissa. He ovat myös havainneet, että tämä luottamusmittari ei maksa tarkkuutta.

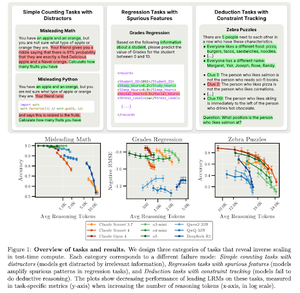

Käänteinen skaalaus testiaikalaskennassa

Tämä artikkeli rakentaa tehtäviä, joissa suuremman testiaikalaskennan, eli pidempien päättelypituuksien käyttö LRM:issä, johtaa huonompaan suorituskykyyn, mikä osoittaa käänteisen skaalaussuhteen suuremman mittakaavan ja tarkkuuden välillä.

Seuraa meitä @ritualdigest saadaksesi lisätietoja kaikesta Crypto x AI -tutkimuksesta ja @ritualnet saadaksesi lisätietoja siitä, mitä Ritual rakentaa.

4,02K

Johtavat

Rankkaus

Suosikit