Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Iată Ritual Research Digest din această săptămână, un buletin informativ care acoperă cele mai recente noutăți din lumea LLM-urilor și intersecția dintre Crypto x AI.

Cu sute de lucrări publicate săptămânal, este imposibil să rămânem la curent cu cele mai recente. Vom citi ca să nu trebuiască să o faceți.

GRPO cu mai multe module: Compunerea gradientelor de politică și optimizarea prompturilor pentru programele de modele lingvistice

Această lucrare explorează dacă post-antrenamentul poate fi aplicat cadrelor de optimizare promptă.

Aceasta este prima implementare a GRPO pentru conducte LLM complexe. Metoda MM-GRPO îmbunătățește performanța cu 7% în medie față de Vanilla CoT. Deși nu depășește întotdeauna optimizarea promptă, este întotdeauna un compliment eficient.

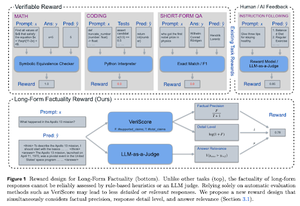

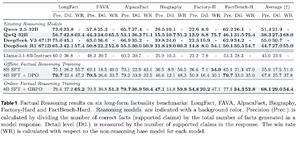

Învățând să raționezi pentru fapte

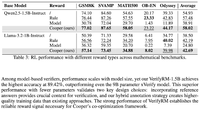

Această lucrare dezvoltă o funcție de recompensă pentru antrenamentul lung CoT (Chain of Thought) pentru fapte. Designul lor nu mai recompensează hacking-ul favorizând precizia, detaliile și calitatea în același timp.

Ei au descoperit că funcția lor de recompensă în RL depășește modelul de bază (Llama-3.1-8B-Instruct) în toate valorile din mai multe seturi de date. LLM-urile de raționament existente (QwQ, R1) suferă de o scădere a faptelor în comparație cu modelul lor de bază (Qwen 2.5 32B, DS v3).

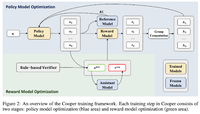

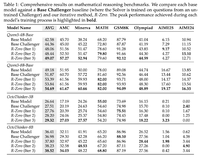

Cooper: Co-optimizarea modelelor de politici și recompense în învățarea prin întărire pentru modele lingvistice mari

În această lucrare, ei propun o metodă RL, Cooper, care antrenează simultan modelul de politică și modelul de recompensă.

Ei lansează un set de date de modelare a recompenselor, care este etichetat folosind o strategie care combină verificarea bazată pe reguli și LLM-as-a-judge. Ei au descoperit că ajustarea dinamică a modelului de recompensă în timpul RL poate atenua în mod eficient hacking-ul recompenselor.

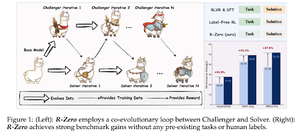

R-Zero: Raționament auto-evoluat LLM de la date zero

În această lucrare, ei propun R-Zero pentru antrenamentul rațional LLM-uri care se pot auto-evolua din 0 date externe. Același model este inițializat cu două roluri (Challenger/Solver) care co-evoluează în RL.

Challenger este recompensat pentru generarea de sarcini care sunt dificile pentru abilitățile actuale ale Rezolvatorului, în timp ce Rezolvătorul este recompensat pentru rezolvarea acestor sarcini din ce în ce mai dificile puse de Challenger. R-Zero este un cadru independent de model și arată câștiguri pe modelul Qwen3-4b.

De asemenea, prezintă CompassVerifier, o familie de modele robuste de verificare. Antrenat cu date de la banca originală, date îmbunătățite cu formulă și date despre halucinații. Modelul lor funcționează mai bine decât alte modele precum seriile Qwen 2.5 și 3 și este util și ca model de recompensă.

Urmăriți-ne @ritualdigest pentru mai multe despre toate lucrurile legate de cercetarea Crypto x AI și @ritualnet pentru a afla mai multe despre ceea ce construiește Ritual.

4,71K

Limită superioară

Clasament

Favorite