Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Mathelirium

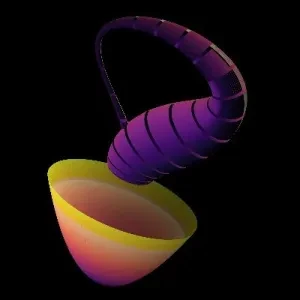

После того как стало ясно, что многомерные единичные шары скрывают почти весь свой объем в тонкой оболочке, вот еще более безумное продолжение:

Многомерный гауссовский распределение — это не уютный колокол с массой, собранной на пике, оно в основном пустое в центре, с почти всей вероятностью, находящейся в тонком гало на склоне на расстоянии примерно "квадратный корень из размерности" от начала координат.

Это означает, что "типичный" выбор из стамерного гауссовского распределения находится далеко от среднего! 🤯 Он располагается на этом кольце, где плотность ниже, но объем огромен.

В реальной жизни это огромно: когда вы инициализируете большую нейронную сеть с гауссовскими весами, большинство сетей, которые вы получаете, имеют примерно одинаковую общую норму веса, все находясь на этой оболочке, так что обучение происходит на тонком энергетическом кольце, а не близко к нулю.

#HighDimensionalSpace

#MachineLearning

#Gaussian

104,4K

В предыдущем посте мы увидели, что в высоких измерениях почти весь объем единичной сферы находится в тончайшей оболочке у границы.

Но есть еще один поворот! 😄

Большинство точек также расположены в узкой центральной полосе вокруг любого фиксированного направления. Таким образом, "типичная" точка находится далеко от начала координат с точки зрения общего расстояния, но ее координата вдоль любой заданной оси крошечная. Высокомерные точки находятся как "на поверхности", так и "близко к экватору", что объясняет, почему случайные векторы почти ортогональны в высокоразмерных пространствах машинного обучения. 🤯

Спасибо @mutko55 за напоминание об этом.

#HighDimensionalSpace #MachineLearning

35,77K

Это одна из самых странных вещей, которые я когда-либо узнал.🤨😦🤯

Мы так привыкли думать в 1, 2 и 3 измерениях, что наша интуиция в основном живет там, но как только вы входите в высокие измерения, даже такие базовые вещи, как расстояние, начинают вести себя так, что это кажется неправильным.

В высокоразмерном шаре почти весь объем находится в тонкой оболочке у границы... уменьшите радиус всего на чуть-чуть, и вы выбросили почти все, так что случайные точки вообще не находятся в середине, они сжаты в микроскопический ореол на краю.

Это одна из причин, по которой расстояние, ближайшие соседи и геометрическая интуиция начинают вести себя так странно в высокоразмерных пространствах Машинного Обучения. Высокоразмерная геометрия тихо говорит вам, что ваш низкоразмерный мозг лжет вам. 🤯 #HighDimensionalSpace #MachineLearning

206,77K

Топ

Рейтинг

Избранное