Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Mathelirium

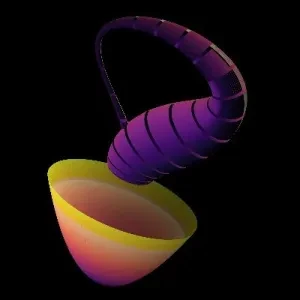

Po zobaczeniu, że jednostkowe kule w wysokich wymiarach ukrywają prawie całą swoją objętość w cienkiej powłoce, oto jeszcze bardziej szalony sequel:

Wysokowymiarowy Gaussian to nie przytulny dzwon z masą przytuloną na szczycie, jest zasadniczo pusty w środku, z prawie całą prawdopodobieństwem żyjącym w cienkim halo na stoku w odległości około „pierwiastka z wymiaru” od początku.

To oznacza, że „typowe” losowanie z setkowymiarowego Gaussiana jest dalekie od średniej! 🤯 Siedzi na tym pierścieniu, gdzie gęstość jest niższa, ale objętość jest ogromna.

Interpretując to w prawdziwym życiu, to ogromne: gdy inicjalizujesz dużą sieć neuronową z wagami Gaussowskimi, większość sieci, które otrzymujesz, ma mniej więcej tę samą ogólną normę wag, wszystkie siedzą na tej powłoce, więc trening odbywa się na cienkim pierścieniu energii, a nie blisko zera.

#HighDimensionalSpace

#MachineLearning

#Gaussian

104,4K

W poprzednim poście zobaczyliśmy, że w wysokich wymiarach prawie cała objętość jednostkowej kuli znajduje się w cienkiej jak brzytwa powłoce blisko granicy.

Ale jest jeszcze jeden zwrot akcji! 😄

Większość punktów również leży w wąskiej centralnej płytce wokół dowolnego ustalonego kierunku. Więc „typowy” punkt jest daleko od początku w sensie ogólnej odległości, ale jego współrzędna wzdłuż dowolnej danej osi jest niewielka. Punkty w wysokich wymiarach są zarówno „na powierzchni”, jak i „blisko równika”, co jest powodem, dla którego losowe wektory są prawie ortogonalne w wysokowymiarowych przestrzeniach uczenia maszynowego. 🤯

Dzięki @mutko55 za przypomnienie mi o tym.

#HighDimensionalSpace #MachineLearning

35,77K

To jedna z najdziwniejszych rzeczy, jakich kiedykolwiek się nauczyłem.🤨😦🤯

Zostaliśmy tak uwarunkowani, by myśleć w 1, 2 i 3 wymiarach, że nasza intuicja zasadniczo tam żyje, ale gdy tylko wkroczysz w wysokie wymiary, nawet coś tak podstawowego jak odległość zaczyna zachowywać się w sposób, który wydaje się niewłaściwy.

W kuli o wysokim wymiarze prawie cała objętość znajduje się w cienkiej powłoce blisko granicy... zmniejsz promień tylko odrobinę, a wyrzucisz prawie wszystko, więc losowe punkty wcale nie siedzą w środku, są ściśnięte w mikroskopijną aureolę na krawędzi.

To jedna z przyczyn, dla których odległość, najbliżsi sąsiedzi i intuicja geometryczna zaczynają działać tak dziwnie w wysokowymiarowych przestrzeniach Machine Learning. Wysokowymiarowa geometria cicho mówi ci, że twój niskowymiarowy mózg kłamie. 🤯 #HighDimensionalSpace #MachineLearning

206,77K

Najlepsze

Ranking

Ulubione